| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- grafana

- vagrant

- docker

- Kubernetes

- loadbalancer

- Jenkins

- Ingress

- kiali

- CNI

- traffic cloning

- requestauthentication

- vpc cni

- istio in action

- prometheus

- K8S

- aws eks

- argocd

- CICD

- service entry

- envoy

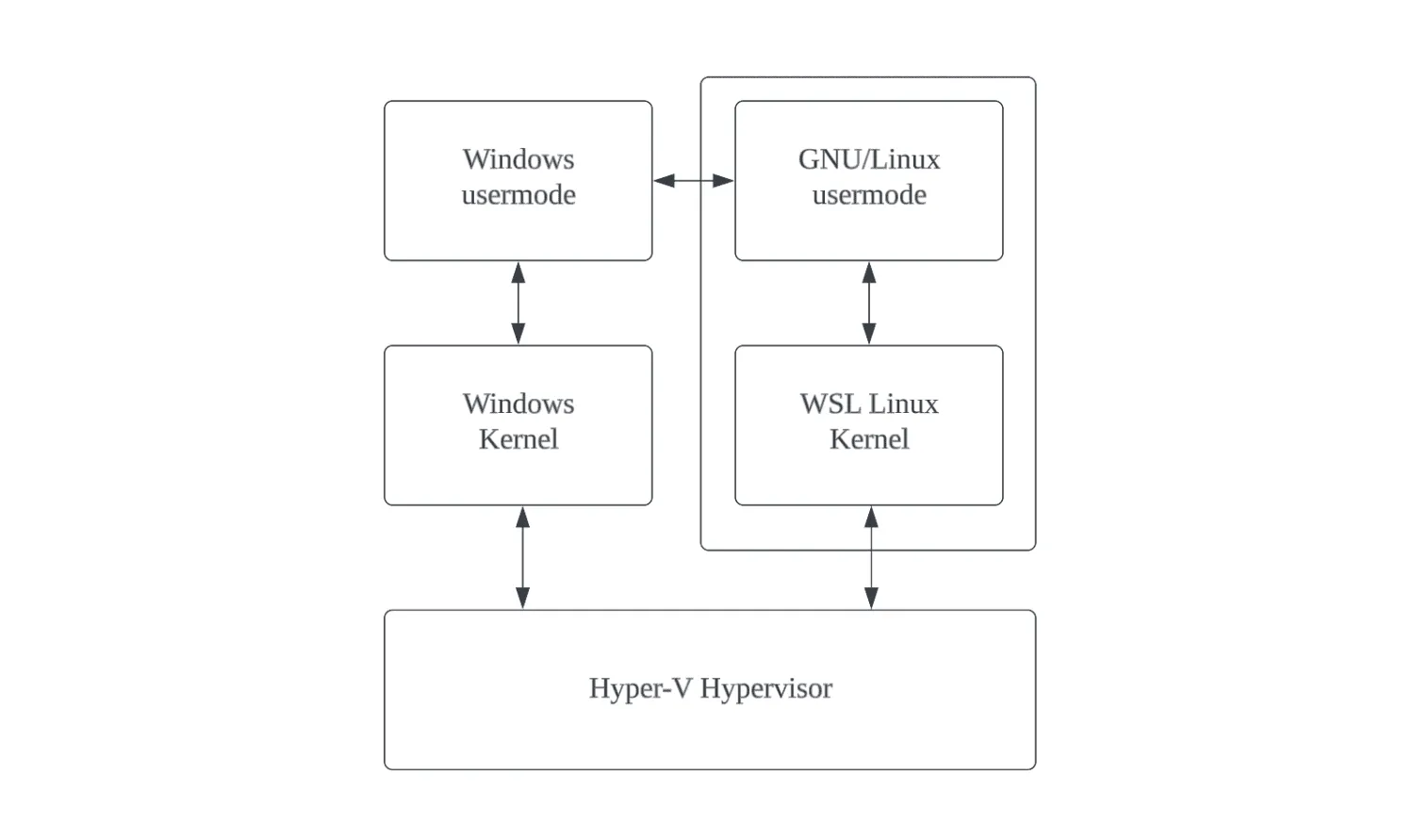

- WSL

- peerauthentication

- aws gateway api controller

- Istio

- Kind

- leastconnection

- Observability

- authorizationpolicy

- service mesh

- traffic mirroring

- Today

- Total

WellSpring

AEWS 2주차 - EKS Networking 본문

※ 본 게재 글은 gasida님의 'AEWS' 강의내용과 실습예제 및 AWS 공식사이트 및 관련 Blog 등을 참고하여 작성하였습니다.

0. 실습환경 구성

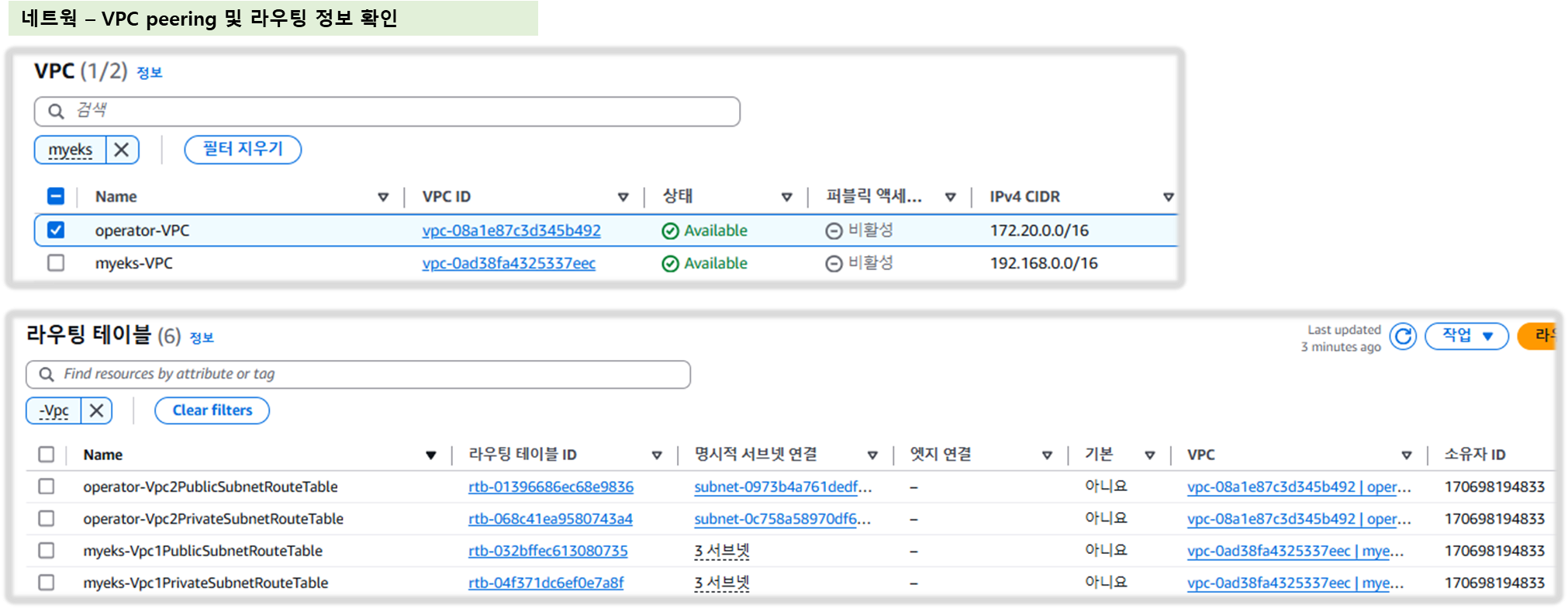

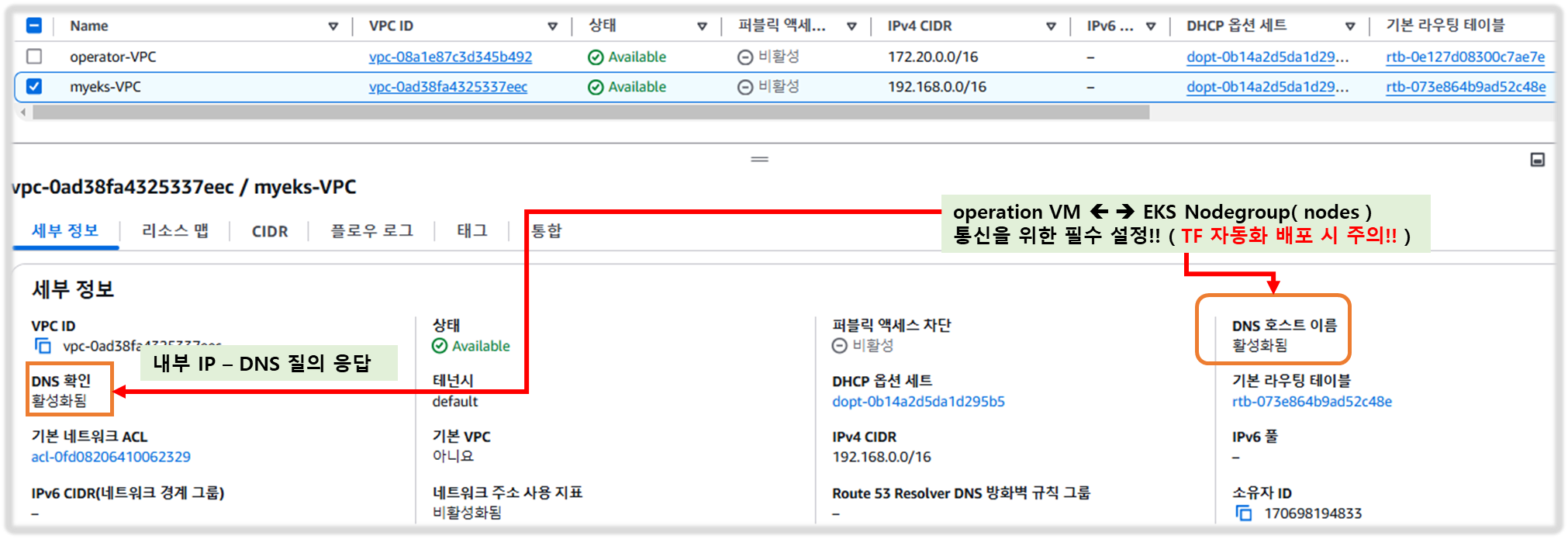

☞ 구성도 : 2개의 VPC(EKS 배포, 운영용 구분), 운영서버 EC2 + EKS 제어부, EKS 데이터부(관리형 노드 그룹, AL2023 - 페도라 기반, dnf - Docs)

- myeks-vpc 에 각기 AZ를 사용하는 퍼블릭/프라이빗 서브넷 배치

- operator-vpc 에 AZ1를 사용하는 퍼블릭/프라이빗 서브넷 배치

- 내부 통신을 위한 VPC Peering 배치

[ 실습 순서 ]

- 자신의 PC에 실습을 위한 툴 및 설정 : macOS or Windows(WSL2 사용 권장)

- AWS CloudFormation 을 통해 기본 실습 환경 배포 : 2개의 VPC, 운영 서버 EC2 1대

- eksctl 을 통해 EKS 배포

- 관리형 노드 그룹(EC2) 접속

[ 참고 - gasida님 가이드 : Windows (WSL2) + VSCODE 연동 ]

1. Windows 에 WSL2 (Ubuntu 24.04 배포판) 설치 - Docs , 설명서

- https://www.lainyzine.com/ko/article/how-to-check-windows-10-edition-version-build-information/

- https://www.lainyzine.com/ko/article/how-to-install-wsl2-and-use-linux-on-windows-10/#windows-10에-wsl2-설치하는-방법

- https://velog.io/@pikamon/Linux-3

- Powershell 관리자 권한으로 실행

# DISM(배포 이미지 서비스 및 관리) 명령어로 Microsoft-Windows-Subsystem-Linux 기능을 활성화

dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart

# DISM 명령어로 VirtualMachinePlatform 기능을 활성화

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart

# wsl 설치

wsl --install

# 기본값 WSL 2 버전 설정

wsl --set-default-version 2

# wsl 업데이트

wsl --update- 윈도우 OS 재부팅

- Powershell 관리자 권한으로 실행

# 설치 가능한 배포판 확인

wsl --list --online

# Ubuntu 배포판 설치

wsl --install Ubuntu-24.04

...

Enter new UNIX username: <각자 Ubuntu 사용 계정>

New password: <해당 계정 암호>

Retype new password: <해당 계정 암호>

passwd: password updated successfully

Installation successful!

To run a command as administrator (user "root"), use "sudo <command>".

---------------------------------------

# 기본 정보 확인

hostnamectl

whoami

id

pwd

# apt 업데이트

sudo apt update

sudo apt install jq htop curl wget ca-certificates net-tools -y

ifconfig eth0

ping -c 1 8.8.8.8

# 빠져나오기

$ exit

---------------------------------------

# 설치된 배포판 확인

wsl -l -v

# Ubuntu 재진입

wsl

2. [ WSL Ubuntu ] 필수 툴 설치

# Install awscli

sudo snap install aws-cli --classic

aws --version

# Install eksctl

curl -sL "https://github.com/eksctl-io/eksctl/releases/latest/download/eksctl_Linux_amd64.tar.gz" | tar xz -C ./

sudo mv ./eksctl /usr/local/bin

eksctl version

# Install kubectl

curl -O https://s3.us-west-2.amazonaws.com/amazon-eks/1.31.2/2024-11-15/bin/linux/amd64/kubectl

sudo install -o root -g root -m 0755 kubectl /usr/local/bin/kubectl

kubectl version --client=true

# Install Helm

curl -s https://raw.githubusercontent.com/helm/helm/master/scripts/get-helm-3 | bash

helm version

# krew 툴 및 플러그인 설치

curl -sL https://github.com/kubernetes-sigs/krew/releases/download/v0.4.4/krew-linux_amd64.tar.gz | tar xz -C ./

./krew-linux_amd64 install krew

export PATH="$HOME/.krew/bin:$PATH"

echo 'export PATH="$HOME/.krew/bin:$PATH"' >> ~/.bashrc

kubectl krew version

kubectl krew install ctx ns neat get-all df-pv stern

kubectl krew list

# kubectl 단축 및 자동 완성 설정

echo 'source <(kubectl completion bash)' >> ~/.bashrc

echo 'alias k=kubectl' >> ~/.bashrc

echo 'complete -F __start_kubectl k' >> ~/.bashrc

# kube-ps1 설치

git clone https://github.com/jonmosco/kube-ps1.git $HOME/kube-ps1

cat <<"EOT" >> ~/.bashrc

source $HOME/kube-ps1/kube-ps1.sh

KUBE_PS1_SYMBOL_ENABLE=false

function get_cluster_short() {

echo "$1" | cut -d . -f1

}

KUBE_PS1_CLUSTER_FUNCTION=get_cluster_short

KUBE_PS1_SUFFIX=') '

PS1='$(kube_ps1)'$PS1

EOT

# (옵션) kubecolor 설치 : 사용 시에는 kubectl(k) 대신 kubecolor 사용

curl -sL "https://github.com/kubecolor/kubecolor/releases/download/v0.5.0/kubecolor_0.5.0_linux_amd64.tar.gz" | tar xz -C ./

sudo mv ./kubecolor /usr/local/bin

kubecolor -h

3. [ WSL Ubuntu ] AWS Configure 자격 증명 설정 ⇒ 업무용 PC일 경우 aws profile 를 구별해서 사용을 권장

# 자격 구성 설정 없이 확인

aws ec2 describe-instances

# IAM User 자격 구성 : 실습 편리를 위해 administrator 권한을 가진 IAM User 의 자격 증명 입력

aws configure

AWS Access Key ID [None]: AKIA5...

AWS Secret Access Key [None]: CVNa2...

Default region name [None]: ap-northeast-2

Default output format [None]: json

# 자격 구성 적용 확인 : 노드 IP 확인

aws ec2 describe-instances

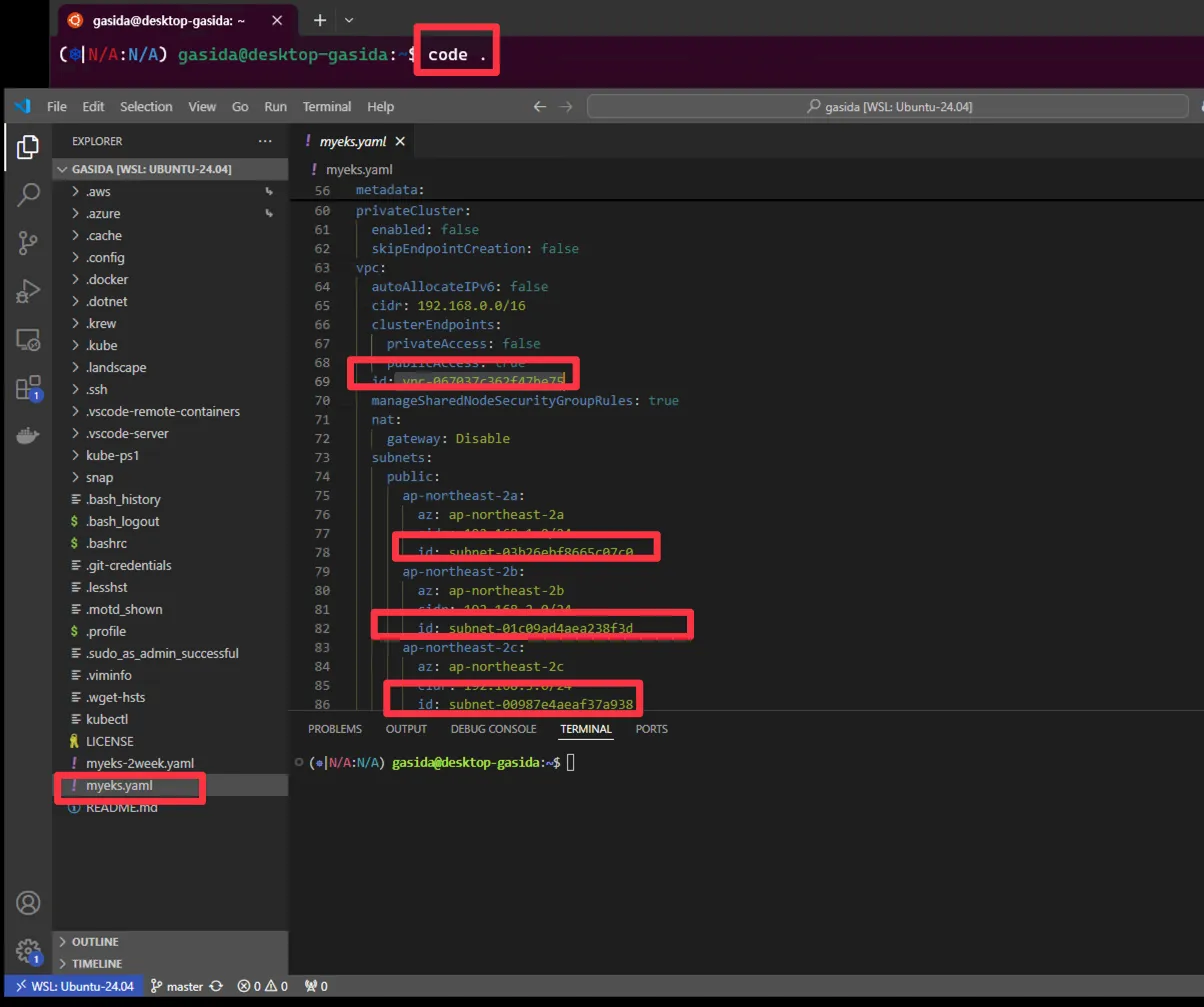

4. [WSL Ubuntu] 우분투 내부에 파일을 VSCODE 에서 변경 시 - Docs , Blog

# 사용자 기본 디렉터리에서 아래 입력

code .

☞ 모든 실습 명령 입력은 WSL Ubuntu 진입해서, Ubuntu 에서 실습 진행하시면 됩니다.

[1] 자신의 PC에 실습을 위한 툴 및 설정 : Windows (WSL2) 환경

- WSL2 설치 : Link

- awscliv2 설치 (Ubuntu on WSL) : Link

- eksctl 설치 : Link

- helm 설치 : Link

- krew 설치 : Link

[ Self - Guide ]

## default tool (pre-install for package)

sudo apt install curl unzip

## Install awscli

curl "https://awscli.amazonaws.com/awscli-exe-linux-x86_64.zip" -o "awscliv2.zip"

sudo unzip awscliv2.zip

sudo ./aws/install

aws --version

## AWS configure

#AWS Access Key ID [None]: AKI********LVJ

#AWS Secret Access Key [None]: 5iH***********************4Hn

#Default region name [None]: ap-northeast-2

#Default output format [None]: json

## Install eksctl

# for ARM systems, set ARCH to: `arm64`, `armv6` or `armv7`

ARCH=amd64

PLATFORM=$(uname -s)_$ARCH

curl -sLO "https://github.com/eksctl-io/eksctl/releases/latest/download/eksctl_$PLATFORM.tar.gz"

# (Optional) Verify checksum

curl -sL "https://github.com/eksctl-io/eksctl/releases/latest/download/eksctl_checksums.txt" | grep $PLATFORM | sha256sum --check

tar -xzf eksctl_$PLATFORM.tar.gz -C /tmp && rm eksctl_$PLATFORM.tar.gz

sudo mv /tmp/eksctl /usr/local/bin

eksctl version

## Install kubectl (Linux AMD64)

curl -O https://s3.us-west-2.amazonaws.com/amazon-eks/1.31.3/2024-12-12/bin/linux/amd64/kubectl

curl -O https://s3.us-west-2.amazonaws.com/amazon-eks/1.31.3/2024-12-12/bin/linux/amd64/kubectl.sha256

sha256sum -c kubectl.sha256

sudo chmod +x ./kubectl

mkdir -p $HOME/bin && cp ./kubectl $HOME/bin/kubectl && export PATH=$HOME/bin:$PATH

kubectl version --client=true

## Install Helm

curl https://baltocdn.com/helm/signing.asc | gpg --dearmor | sudo tee /usr/share/keyrings/helm.gpg > /dev/null

sudo apt-get install apt-transport-https --yes

echo "deb [arch=$(dpkg --print-architecture) signed-by=/usr/share/keyrings/helm.gpg] https://baltocdn.com/helm/stable/debian/ all main" | sudo tee /etc/apt/sources.list.d/helm-stable-debian.list

sudo apt-get update

sudo apt-get install helm

helm version

# krew 툴 및 플러그인 설치 (Bash 환경에서)

(

set -x; cd "$(mktemp -d)" &&

OS="$(uname | tr '[:upper:]' '[:lower:]')" &&

ARCH="$(uname -m | sed -e 's/x86_64/amd64/' -e 's/\(arm\)\(64\)\?.*/\1\2/' -e 's/aarch64$/arm64/')" &&

KREW="krew-${OS}_${ARCH}" &&

curl -fsSLO "https://github.com/kubernetes-sigs/krew/releases/latest/download/${KREW}.tar.gz" &&

tar zxvf "${KREW}.tar.gz" &&

./"${KREW}" install krew

)

# ~/.bashrc 에 경로추가

export PATH="${KREW_ROOT:-$HOME/.krew}/bin:$PATH"

kubectl krew version

## krew 통한 기타 Tool 설치

kubectl krew install neat get-all df-pv stern

kubectl krew list

# kube-ps1 설치

git clone https://github.com/jonmosco/kube-ps1.git $HOME/kube-ps1

cat <<"EOT" >> ~/.bashrc

source $HOME/kube-ps1/kube-ps1.sh

KUBE_PS1_SYMBOL_ENABLE=false

function get_cluster_short() {

echo "$1" | cut -d . -f1

}

KUBE_PS1_CLUSTER_FUNCTION=get_cluster_short

KUBE_PS1_SUFFIX=') '

PS1='$(kube_ps1)'$PS1

EOT

# (옵션) kubecolor 설치 : 사용 시에는 kubectl(k) 대신 kubecolor 사용

curl -sL "https://github.com/kubecolor/kubecolor/releases/download/v0.5.0/kubecolor_0.5.0_linux_amd64.tar.gz" | tar xz -C ./

sudo mv ./kubecolor /usr/local/bin

kubecolor -h[ Tip & Tips - ssh config 설정으로 keypair 없이 접속환경 만들기 ]

## ~/.ssh 이하 config 파일 생성 후, 하기 포멧형식 작성

Host {ALIAS 호스트명}

HostName {host IP}

User {User ID :ec2-user}

IdentityFile {Keypair 위치/}

## 예시 ##

#Host 192.168.1.233

# HostName 192.168.1.233

# User ec2-user

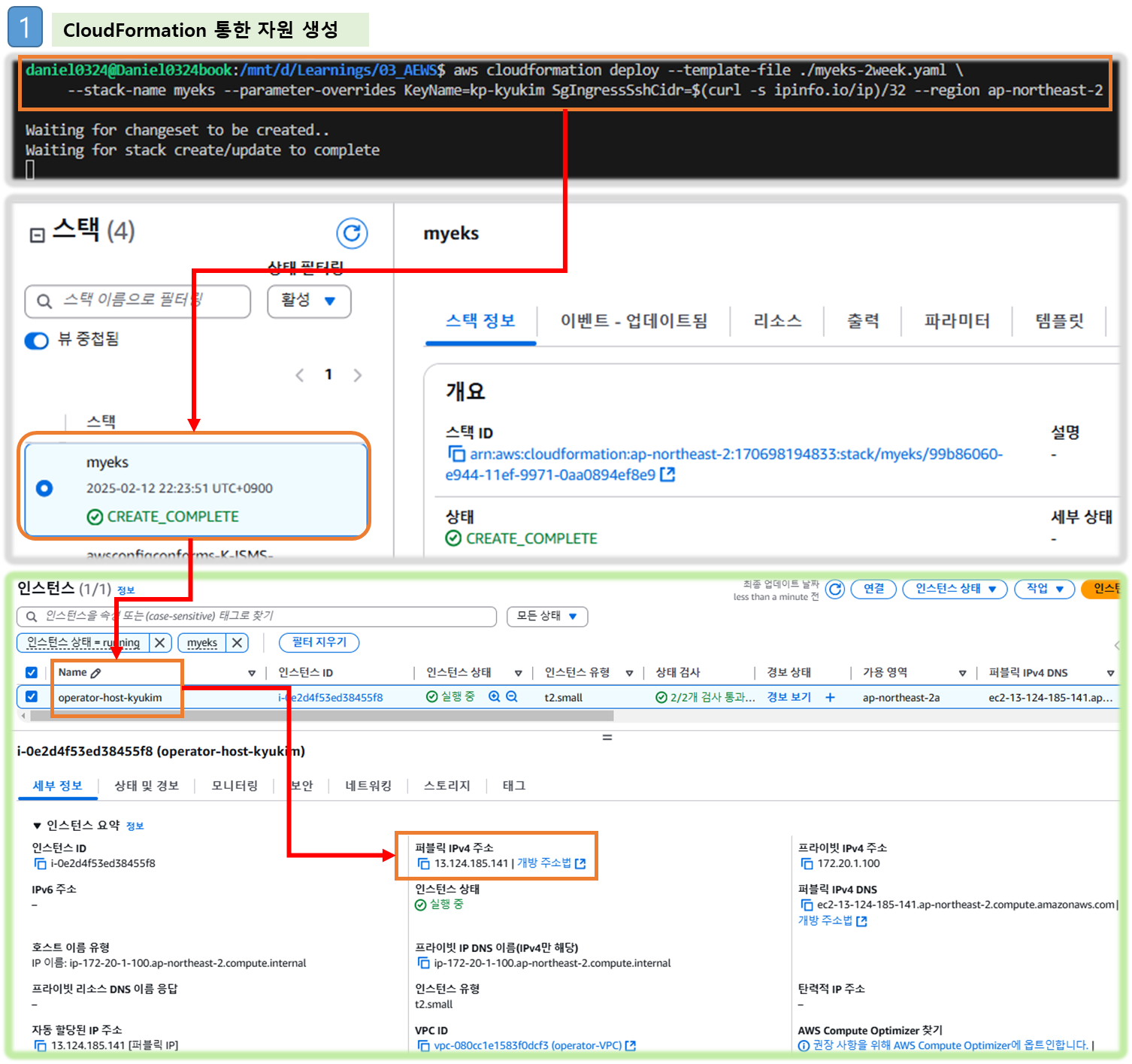

# IdentityFile ~/kp-kyukim.pem[2] AWS CloudFormation 을 통해 기본 실습 환경 배포

# yaml 파일 다운로드

curl -O https://s3.ap-northeast-2.amazonaws.com/cloudformation.cloudneta.net/K8S/myeks-2week.yaml

# 배포

# aws cloudformation deploy --template-file myeks-1week.yaml --stack-name mykops --parameter-overrides KeyName=<My SSH Keyname> SgIngressSshCidr=<My Home Public IP Address>/32 --region <리전>

예시) aws cloudformation deploy --template-file ~/Downloads/myeks-2week.yaml \

--stack-name myeks --parameter-overrides KeyName=kp-gasida SgIngressSshCidr=$(curl -s ipinfo.io/ip)/32 --region ap-northeast-2

# CloudFormation 스택 배포 완료 후 운영서버 EC2 IP 출력

aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[*].OutputValue' --output text

예시) 3.35.137.31

# 운영서버 EC2 에 SSH 접속

예시) ssh ec2-user@3.35.137.31

ssh -i <ssh 키파일> ec2-user@$(aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[0].OutputValue' --output text)

- 배포된 리소스 정보 확인 : 운영서버 EC2, VPC(DNS 설정 옵션), VPC Peering, Routing Table

[ 실습 결과 - 한 눈에 보기 ]

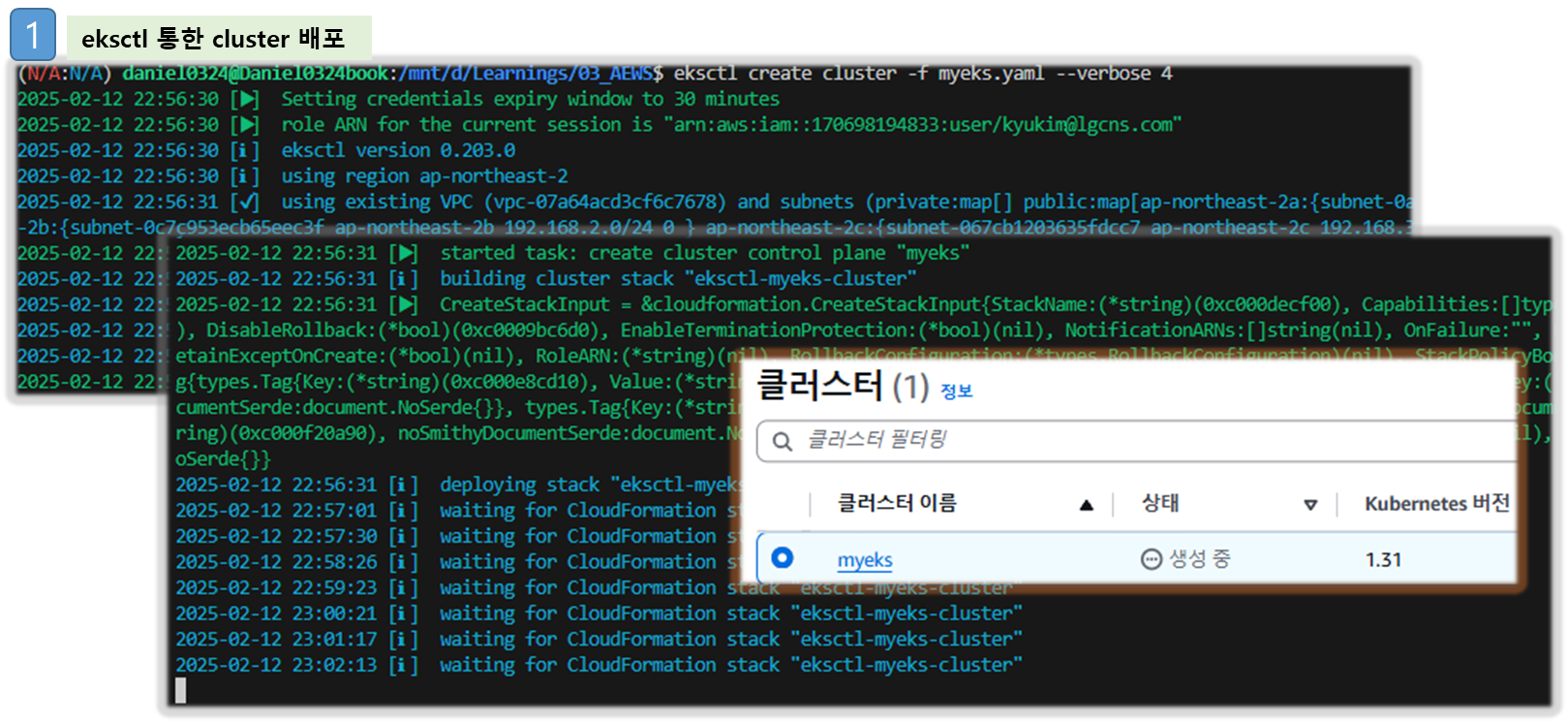

[3] eksctl 을 통해 EKS 배포

Step1. 배포할 YAML 파일 작성

#

export CLUSTER_NAME=myeks

# myeks-VPC/Subnet 정보 확인 및 변수 지정

export VPCID=$(aws ec2 describe-vpcs --filters "Name=tag:Name,Values=$CLUSTER_NAME-VPC" --query 'Vpcs[*].VpcId' --output text)

echo $VPCID

export PubSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet1" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet2" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet3" --query "Subnets[0].[SubnetId]" --output text)

echo $PubSubnet1 $PubSubnet2 $PubSubnet3

# 출력된 내용 참고 : 아래 yaml 파일 참고해서 vpc/subnet id, ssh key 경로 수정

eksctl create cluster --name $CLUSTER_NAME --region=ap-northeast-2 --nodegroup-name=ng1 --node-type=t3.medium --nodes 3 --node-volume-size=30 --vpc-public-subnets "$PubSubnet1","$PubSubnet2","$PubSubnet3" --version 1.31 --with-oidc --external-dns-access --full-ecr-access --alb-ingress-access --node-ami-family AmazonLinux2023 --ssh-access --dry-run > myeks.yaml

-------------------------------------------

# 미사용

## export PrivateSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PrivateSubnet1" --query "Subnets[0].[SubnetId]" --output text)

## export PrivateSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PrivateSubnet2" --query "Subnets[0].[SubnetId]" --output text)

## export PrivateSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PrivateSubnet3" --query "Subnets[0].[SubnetId]" --output text)

## echo $PrivateSubnet1 $PrivateSubnet2 $PrivateSubnet3

# ssh 퍼블릭 키 경로 지정

## SshPublic=<각자 자신의 ssh 퍼블릭 키 경로>

## SshPublic=~/.ssh/kp-gasida.pub

## echo $SshPublic

## eksctl create cluster --name $CLUSTER_NAME --region=ap-northeast-2 --nodegroup-name=ng1 --node-type=t3.medium --nodes 3 --node-volume-size=30 --vpc-public-subnets "$PubSubnet1","$PubSubnet2","$PubSubnet3" --version 1.31 --with-oidc --external-dns-access --full-ecr-access --alb-ingress-access --node-ami-family AmazonLinux2023 --ssh-access --ssh-public-key $SshPublic --dry-run > myeks.yaml

Step2. myeks.yaml 파일 작성 : ssm 접속은 기본값 적용됨 → ssh.publicKeyName 으로 이름 지정 가능

( VPC ID, public subnet, public keyname 수정할 것 !! )

apiVersion: eksctl.io/v1alpha5

kind: ClusterConfig

metadata:

name: myeks

region: ap-northeast-2

version: "1.31"

kubernetesNetworkConfig:

ipFamily: IPv4

iam:

vpcResourceControllerPolicy: true

withOIDC: true

accessConfig:

authenticationMode: API_AND_CONFIG_MAP

vpc:

autoAllocateIPv6: false

cidr: 192.168.0.0/16

clusterEndpoints:

privateAccess: true # if you only want to allow private access to the cluster

publicAccess: true # if you want to allow public access to the cluster

id: vpc-0ad38fa4325337eec # 각자 환경 정보로 수정 ***

manageSharedNodeSecurityGroupRules: true # if you want to manage the rules of the shared node security group

nat:

gateway: Disable

subnets:

public:

ap-northeast-2a:

az: ap-northeast-2a

cidr: 192.168.1.0/24

id: subnet-0237a0693f1987c0d # 각자 환경 정보로 수정 ***

ap-northeast-2b:

az: ap-northeast-2b

cidr: 192.168.2.0/24

id: subnet-0346e42f00e631442 # 각자 환경 정보로 수정 ***

ap-northeast-2c:

az: ap-northeast-2c

cidr: 192.168.3.0/24

id: subnet-0d1ae6b34c2aaa698 # 각자 환경 정보로 수정 ***

addons:

- name: vpc-cni # no version is specified so it deploys the default version

version: latest # auto discovers the latest available

attachPolicyARNs: # attach IAM policies to the add-on's service account

- arn:aws:iam::aws:policy/AmazonEKS_CNI_Policy

configurationValues: |-

enableNetworkPolicy: "true"

- name: kube-proxy

version: latest

- name: coredns

version: latest

- name: metrics-server

version: latest

privateCluster:

enabled: false

skipEndpointCreation: false

managedNodeGroups:

- amiFamily: AmazonLinux2023

desiredCapacity: 3

disableIMDSv1: true

disablePodIMDS: false

iam:

withAddonPolicies:

albIngress: false # Disable ALB Ingress Controller

appMesh: false

appMeshPreview: false

autoScaler: false

awsLoadBalancerController: true # Enable AWS Load Balancer Controller

certManager: true # Enable cert-manager

cloudWatch: false

ebs: false

efs: false

externalDNS: true # Enable ExternalDNS

fsx: false

imageBuilder: true

xRay: false

instanceSelector: {}

instanceType: t3.medium

preBootstrapCommands:

# install additional packages

- "dnf install nvme-cli links tree tcpdump sysstat ipvsadm ipset bind-utils htop -y"

# disable hyperthreading

- "for n in $(cat /sys/devices/system/cpu/cpu*/topology/thread_siblings_list | cut -s -d, -f2- | tr ',' '\n' | sort -un); do echo 0 > /sys/devices/system/cpu/cpu${n}/online; done"

labels:

alpha.eksctl.io/cluster-name: myeks

alpha.eksctl.io/nodegroup-name: ng1

maxSize: 3

minSize: 3

name: ng1

privateNetworking: false

releaseVersion: ""

securityGroups:

withLocal: null

withShared: null

ssh:

allow: true

publicKeyName: kp-kyukim # 각자 환경 정보로 수정 ***

tags:

alpha.eksctl.io/nodegroup-name: ng1

alpha.eksctl.io/nodegroup-type: managed

volumeIOPS: 3000

volumeSize: 30

volumeThroughput: 125

volumeType: gp3

Step3. 최종 yaml 로 eks 배포

# kubeconfig 파일 경로 위치 지정 :

export KUBECONFIG=$HOME/kubeconfig

# 혹은 각자 편한 경로 위치에 파일 지정

# export KUBECONFIG=~/Downloads/kubeconfig

# 배포

eksctl create cluster -f myeks.yaml --verbose 4

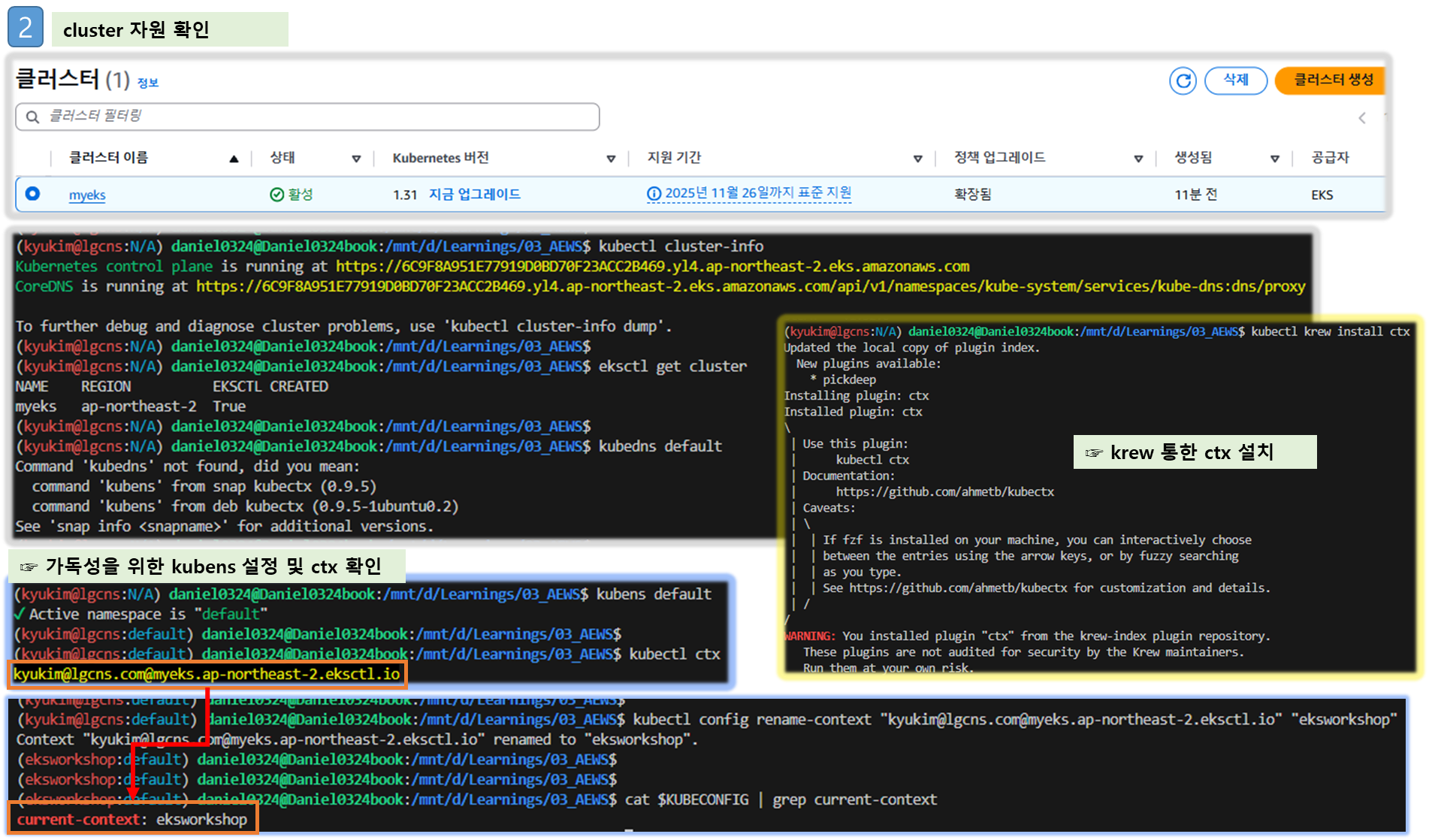

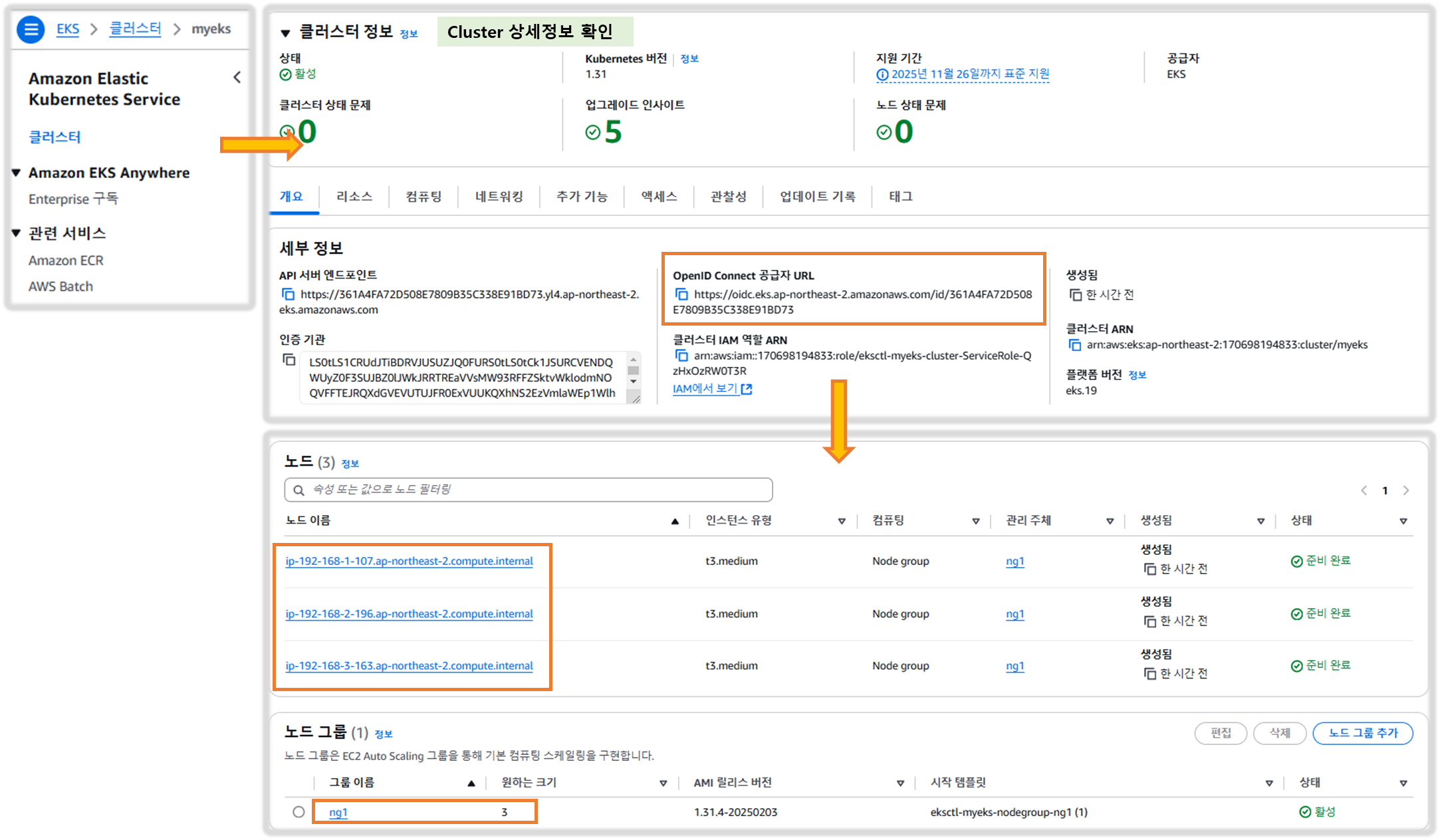

Step4. 배포 후 기본정보 확인

- EKS 관리 콘솔 확인

- Overview : API server endpoint, Open ID Connect provider URL기본 정보(oidc)

- Compute : Node groups 클릭 → AMI(AL2023)..

- Networking : access(public and private)..

- Add-ons : VPC CNI 클릭 → edit 후 권한 설정 확인(IRSA) ⇒ 해당 IAM Role 확인 ← 보안 진행 주차에서 상세히 소개

- Access : IAM access entries (설치 시 사용한 자격증명 username 확인) ← 보안 진행 주차에서 상세히 소개

- EKS 정보 확인

#

kubectl cluster-info

eksctl get cluster

# 네임스페이스 default 변경 적용 ( 설치 : sudo apt install kubectx )

kubens default

#

kubectl ctx

cat $KUBECONFIG | grep current-context

kubectl config rename-context "<각자 자신의 IAM User>@myeks.ap-northeast-2.eksctl.io" "eksworkshop"

kubectl config rename-context "admin@myeks.ap-northeast-2.eksctl.io" "eksworkshop"

cat $KUBECONFIG | grep current-context

#

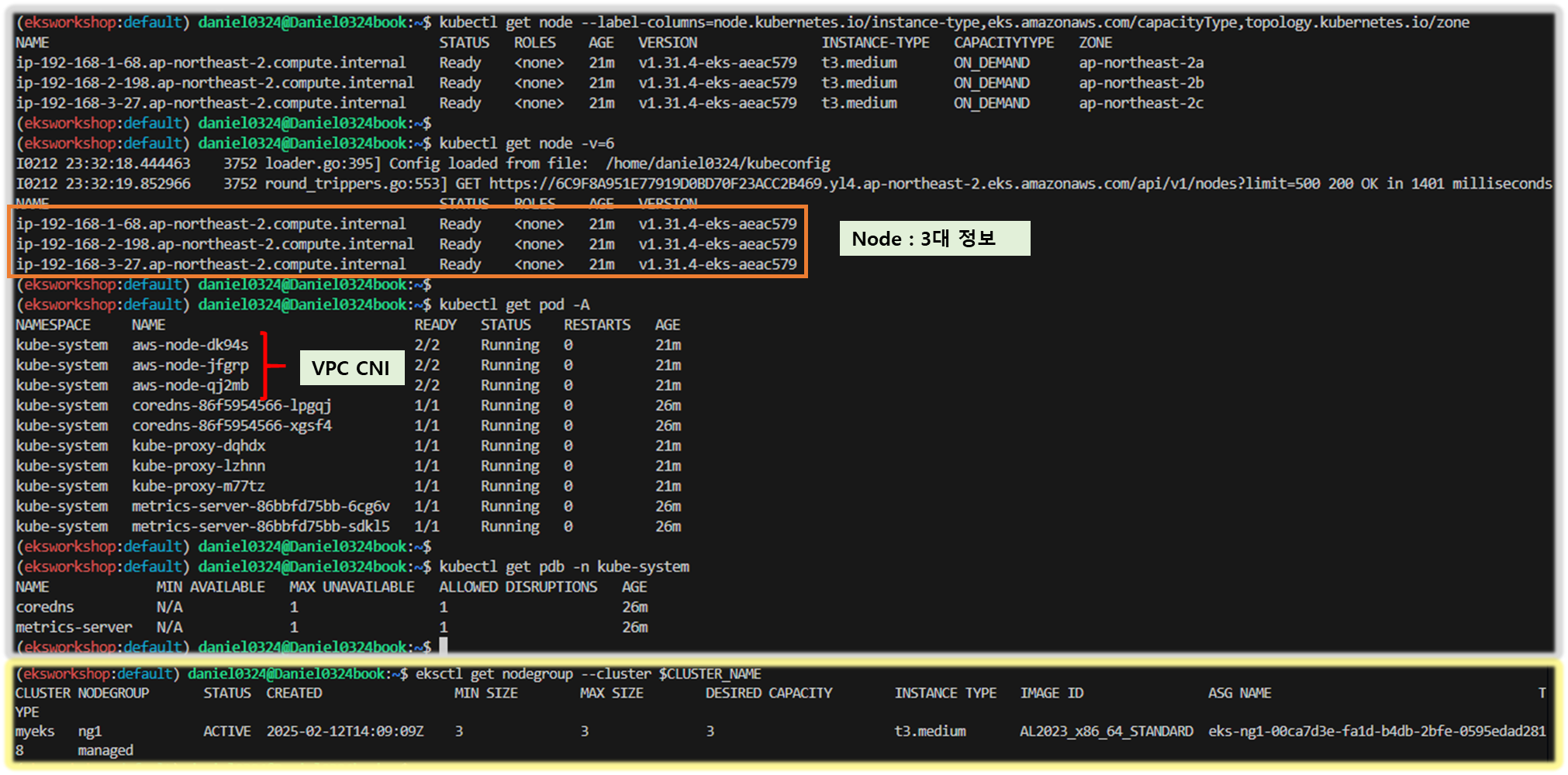

kubectl get node --label-columns=node.kubernetes.io/instance-type,eks.amazonaws.com/capacityType,topology.kubernetes.io/zone

kubectl get node -v=6

#

kubectl get pod -A

kubectl get pdb -n kube-system

NAME MIN AVAILABLE MAX UNAVAILABLE ALLOWED DISRUPTIONS AGE

coredns N/A 1 1 28m

metrics-server N/A 1 1 28m

# 관리형 노드 그룹 확인

eksctl get nodegroup --cluster $CLUSTER_NAME

aws eks describe-nodegroup --cluster-name $CLUSTER_NAME --nodegroup-name ng1 | jq

# eks addon 확인

eksctl get addon --cluster $CLUSTER_NAME

NAME VERSION STATUS ISSUES IAMROLE UPDATE AVAILABLE CONFIGURATION VALUES POD IDENTITY ASSOCIATION ROLES

coredns v1.11.4-eksbuild.2 ACTIVE 0

kube-proxy v1.31.3-eksbuild.2 ACTIVE 0

metrics-server v0.7.2-eksbuild.1 ACTIVE 0

vpc-cni v1.19.2-eksbuild.1 ACTIVE 0 arn:aws:iam::911283464785:role/eksctl-myeks-addon-vpc-cni-Role1-WqTaK0VjADcW enableNetworkPolicy: "true

[ 실행 결과 - 한 눈에 보기 ]

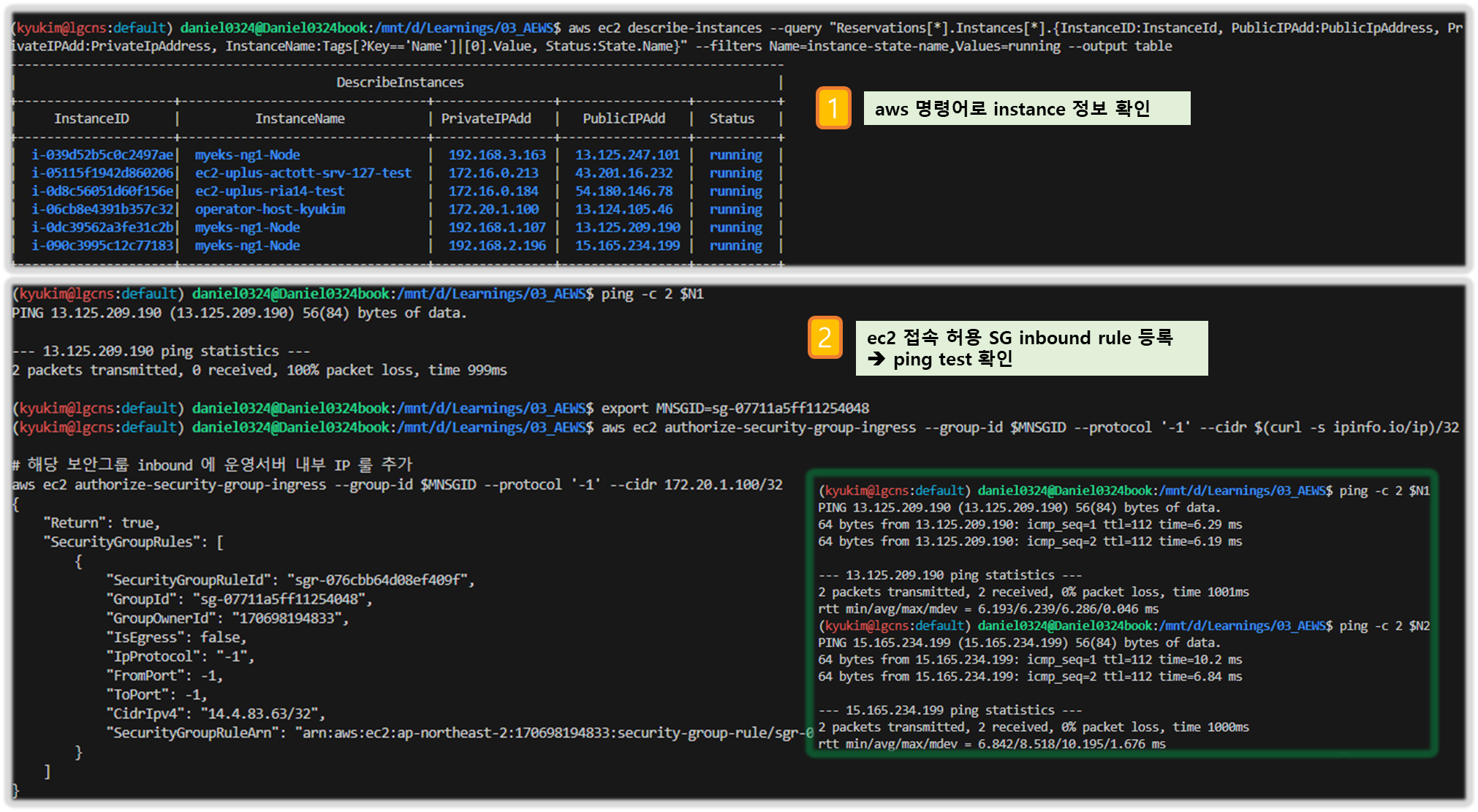

[4] 관리형 노드 그룹(EC2) 접속 및 노드 정보 확인

- 관리 콘솔 EC2 서비스 : 관리형 노드 그룹(EC2) 에 보안그룹 ID 확인

- 해당 보안그룹 inbound 에 자신의 집 공인 IP 추가 후 접속 확인

# 인스턴스 공인 IP 확인

aws ec2 describe-instances --query "Reservations[*].Instances[*].{InstanceID:InstanceId, PublicIPAdd:PublicIpAddress, PrivateIPAdd:PrivateIpAddress, InstanceName:Tags[?Key=='Name']|[0].Value, Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

# 인스턴스 공인 IP 변수 지정

export N1=<az1 배치된 EC2 공인 IP>

export N2=<az2 배치된 EC2 공인 IP>

export N3=<az3 배치된 EC2 공인 IP>

export N1=43.203.169.0

export N2=13.125.28.29

export N3=13.125.255.7

echo $N1, $N2, $N3

# ping 테스트

ping -c 2 $N1

ping -c 2 $N2

# *nodegroup-ng1* 포함된 보안그룹 ID

export MNSGID=<각자 자신의 관리형 노드 그룹(EC2) 에 보안그룹 ID>

export MNSGID=sg-07711a5ff11254048

# 해당 보안그룹 inbound 에 자신의 집 공인 IP 룰 추가

aws ec2 authorize-security-group-ingress --group-id $MNSGID --protocol '-1' --cidr $(curl -s ipinfo.io/ip)/32

# 해당 보안그룹 inbound 에 운영서버 내부 IP 룰 추가

aws ec2 authorize-security-group-ingress --group-id $MNSGID --protocol '-1' --cidr 172.20.1.100/32

# AWS EC2 관리 콘솔에서 EC2에 보안 그룹에 inbound rule 에 추가된 규칙 정보 확인

# ping 테스트

ping -c 2 $N1

ping -c 2 $N2

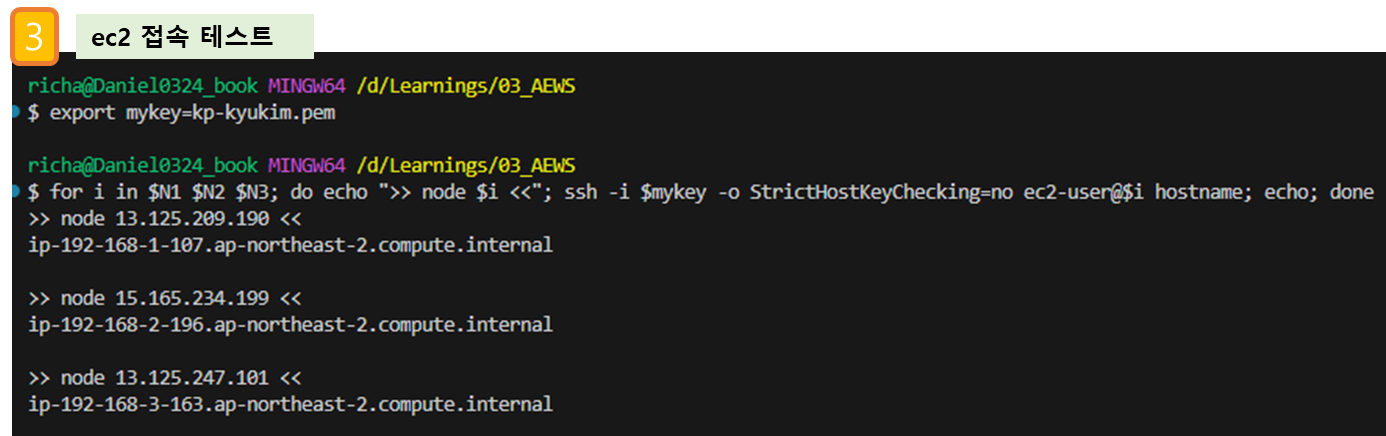

# 워커 노드 SSH 접속

export mykey=kp-kyukim.pem

ssh -i <SSH 키> -o StrictHostKeyChecking=no ec2-user@$N1 hostname

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh -i $mykey -o StrictHostKeyChecking=no ec2-user@$i hostname; echo; done

ssh ec2-user@$N1

exit

ssh ec2-user@$N2

exit

ssh ec2-user@$N2

exit

------------------

# 운영서버 EC2에서 접속 시

## 인스턴스 공인 IP 변수 지정

export N1=<az1 배치된 EC2 내부 IP>

export N2=<az2 배치된 EC2 내부 IP>

export N3=<az3 배치된 EC2 내부 IP>

export N1=192.168.1.186

export N2=192.168.2.123

export N3=192.168.3.174

echo $N1, $N2, $N3

## ping 테스트

ping -c 2 $N1

ping -c 2 $N2

[ 실행 결과 - 한 눈에 보기 ]

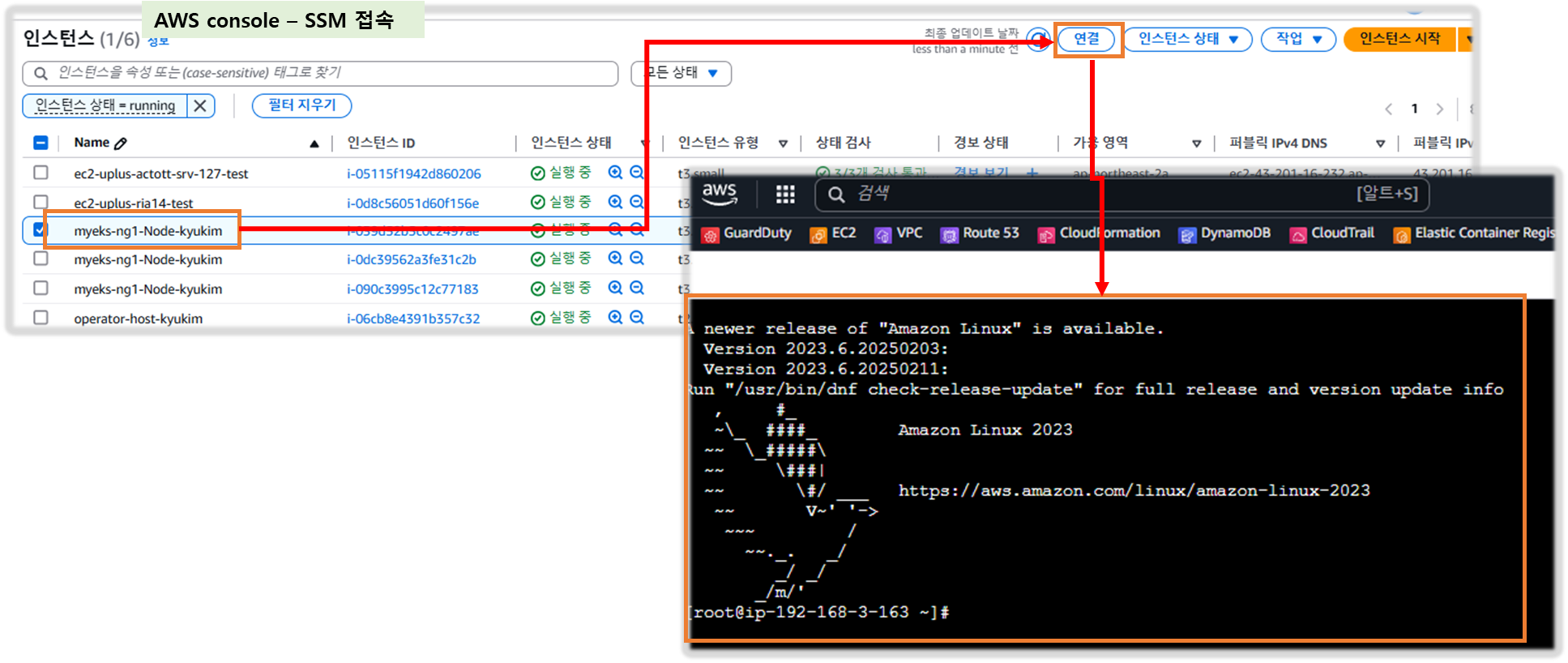

- (옵션) AWS EC2 System Manager - Session Manager 로 관리형 노드 그룹(EC2) 접속

- 방안1 : 터미널에서 접속

- LabGuide - AWS Systems Manager Session Manager

# 인스턴스 ID 확인

aws ec2 describe-instances --query "Reservations[*].Instances[*].{InstanceID:InstanceId, PublicIPAdd:PublicIpAddress, PrivateIPAdd:PrivateIpAddress, InstanceName:Tags[?Key=='Name']|[0].Value, Status:State.Name}" --filters Name=instance-state-name,Values=running --output text

# Session Manager 를 통한 접속

aws ssm start-session --target i-08de73b8e3d968f24

--------------------------------------------------

# 기본 사용자 정보 확인

whoami

pwd

# bash shell 적용

bash

whoami

pwd

# 기본 정보 확인

hostnamectl

# sudo 권한 사용 확인 >> 가능한 이유는? ChatGPT 등에 물어보시라!

sudo cat /etc/passwd

# 빠져나오기

exit

exit

--------------------------------------------------

[ 실행 결과 - 한 눈에 보기 ]

- 방안2 : 관리 콘솔 AWS EC2 System Manager - Session Manager 에서 접속 - Link

- 세션 종료 후 로깅 확인해보기

[ 노드 정보 확인 ]

# 노드 정보 확인

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i hostnamectl; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -c addr; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -c route; echo; done

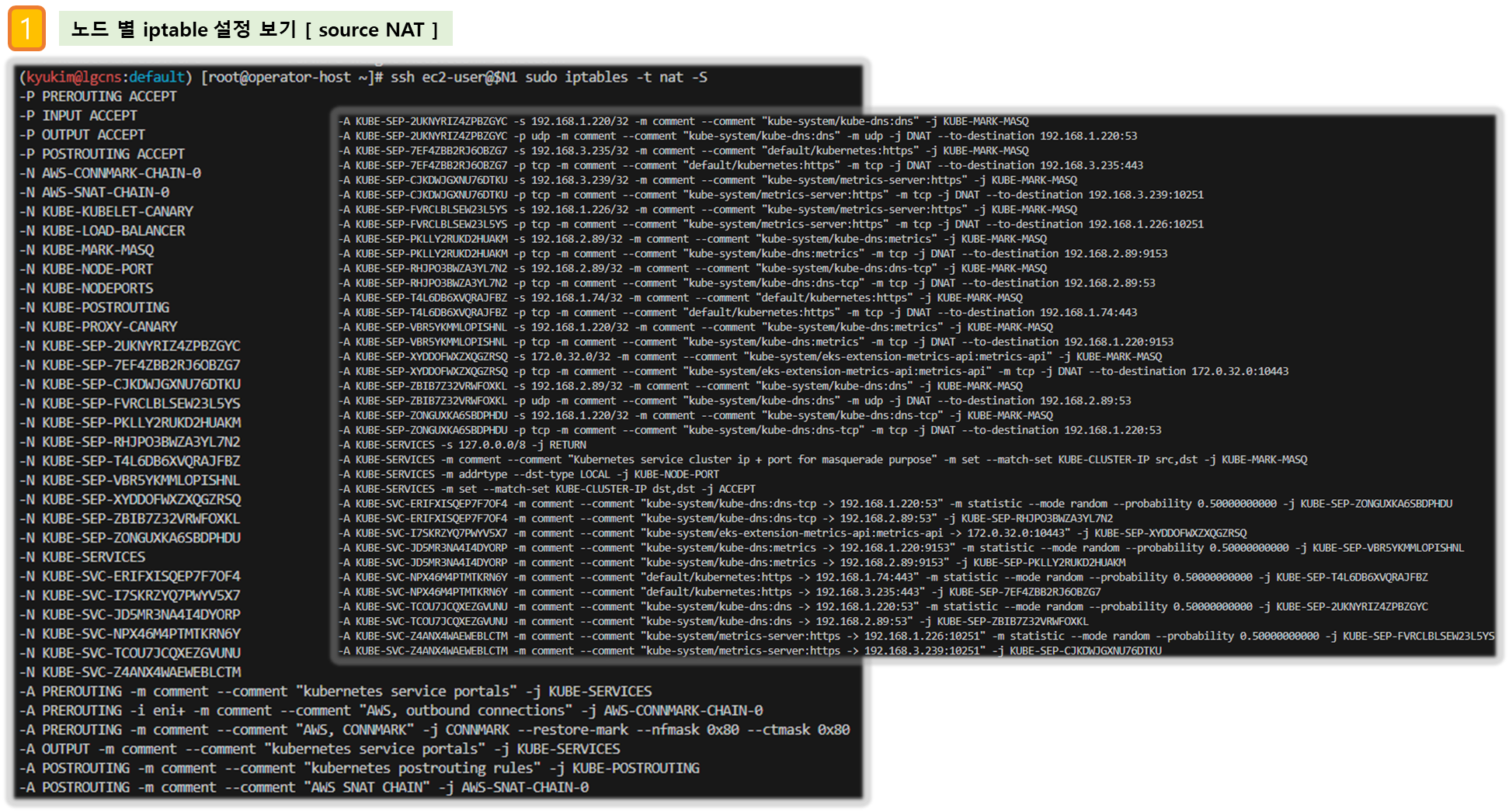

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo iptables -t nat -S; echo; done

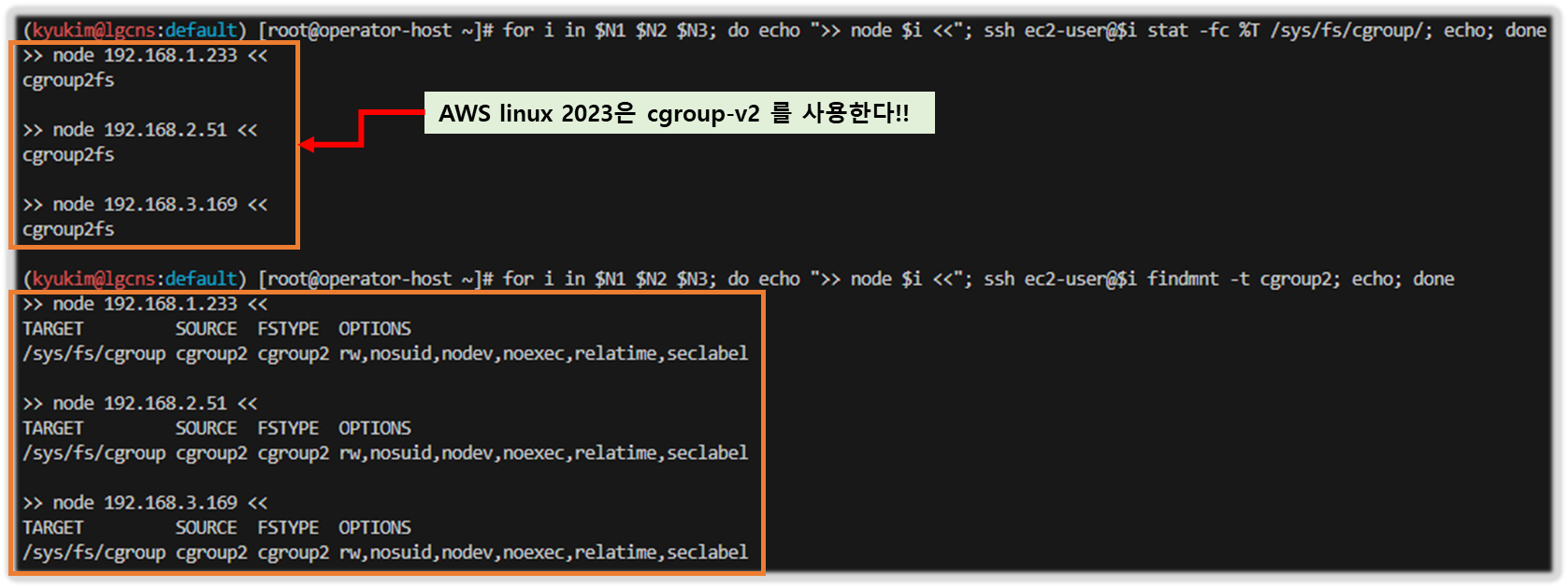

# Node cgroup version : v1(tmpfs), v2(cgroup2fs) - Link

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i stat -fc %T /sys/fs/cgroup/; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i findmnt -t cgroup2; echo; done

#

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo systemctl status kubelet; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i ps axf |grep /usr/bin/containerd; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo tree /etc/kubernetes/kubelet/; echo; done

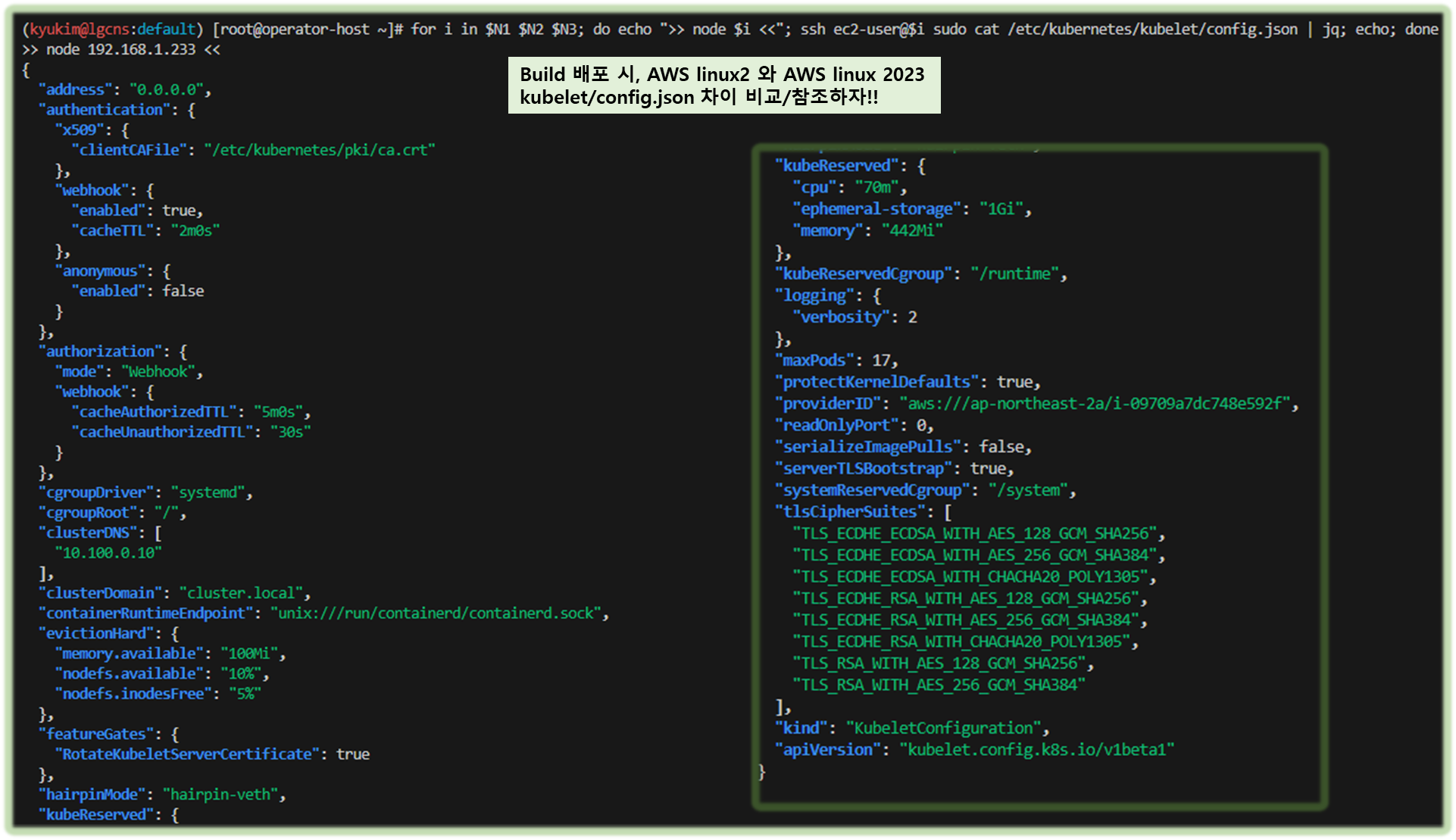

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo cat /etc/kubernetes/kubelet/config.json | jq; echo; done

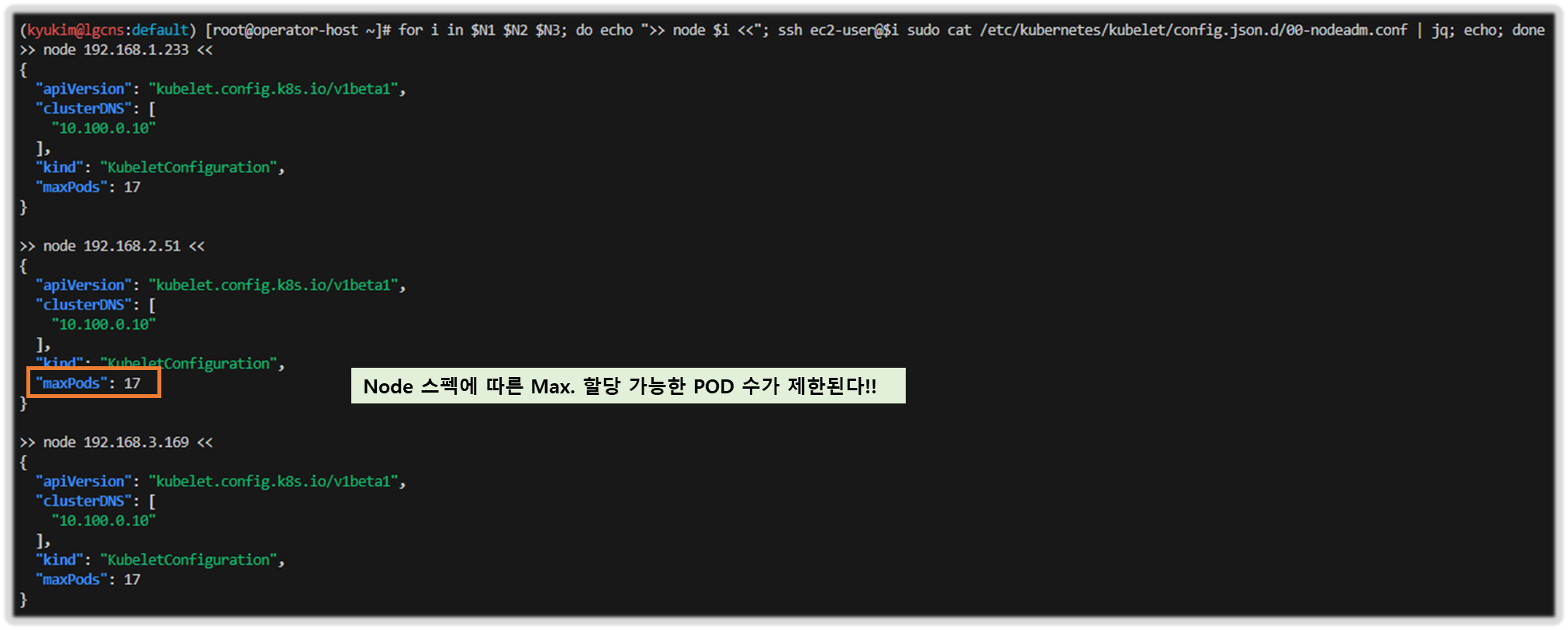

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo cat /etc/kubernetes/kubelet/config.json.d/00-nodeadm.conf | jq; echo; done

#

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i lsblk; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i df -hT /; echo; done

# 컨테이너 리스트 확인

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ctr -n k8s.io container list; echo; done

CONTAINER IMAGE RUNTIME

28b6a15c475e32cd8777c1963ba684745573d0b6053f80d2d37add0ae841eb45 602401143452.dkr.ecr-fips.us-east-1.amazonaws.com/eks/pause:3.5 io.containerd.runc.v2

4f266ebcee45b133c527df96499e01ec0c020ea72785eb10ef63b20b5826cf7c 602401143452.dkr.ecr-fips.us-east-1.amazonaws.com/eks/pause:3.5 io.containerd.runc.v2

...

# 컨테이너 이미지 확인

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ctr -n k8s.io image list --quiet; echo; done

...

# 태스크 리스트 확인

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ctr -n k8s.io task list; echo; done

[ 실행 결과 - 한 눈에 보기 ]

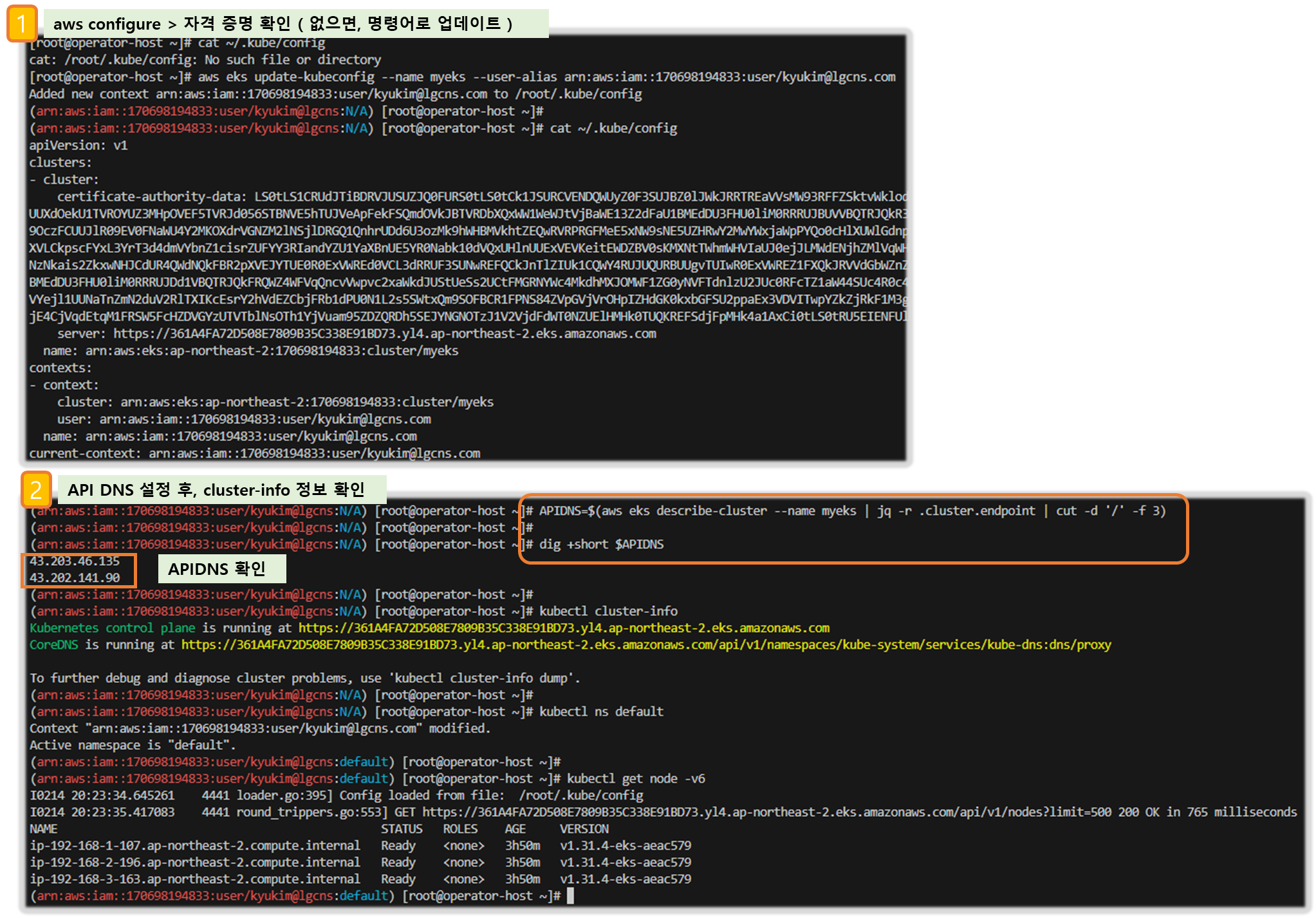

[5] 운영서버 EC2에서 eks 를 사용 할 수 있게 설정

# eks 설치한 iam 자격증명을 설정하기

aws configure

...

# get-caller-identity 확인

aws sts get-caller-identity --query Arn

# kubeconfig 생성

cat ~/.kube/config

aws eks update-kubeconfig --name myeks --user-alias <위 출력된 자격증명 사용자>

aws eks update-kubeconfig --name myeks --user-alias admin

# 추가된 kubeconfig 정보 확인

cat ~/.kube/config

# eks api dig 조회 : VPC 내부에서 질의하는데 왜 그럴까? private hosted zone 의 특징을 알아보자

APIDNS=$(aws eks describe-cluster --name myeks | jq -r .cluster.endpoint | cut -d '/' -f 3)

dig +short $APIDNS

#

kubectl cluster-info

kubectl ns default

kubectl get node -v6

[ 실습 결과 - 한 눈에 보기 ]

★ 실습에서 자주 사용하는 변수 설정

#

export KUBECONFIG=~/Downloads/kubeconfig

export CLUSTER_NAME=myeks

# myeks-VPC/Subnet 정보 확인 및 변수 지정

export VPCID=$(aws ec2 describe-vpcs --filters "Name=tag:Name,Values=$CLUSTER_NAME-VPC" --query 'Vpcs[*].VpcId' --output text)

echo $VPCID

export PubSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet1" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet2" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet3" --query "Subnets[0].[SubnetId]" --output text)

echo $PubSubnet1 $PubSubnet2 $PubSubnet3

# 인스턴스 IP 확인

aws ec2 describe-instances --query "Reservations[*].Instances[*].{InstanceID:InstanceId, PublicIPAdd:PublicIpAddress, PrivateIPAdd:PrivateIpAddress, InstanceName:Tags[?Key=='Name']|[0].Value, Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

# 인스턴스 공인 IP 변수 지정

#export N1=<az1 배치된 EC2 공인 IP>

#export N2=<az2 배치된 EC2 공인 IP>

#export N3=<az3 배치된 EC2 공인 IP>

export N1=13.125.209.190

export N2=15.165.234.199

export N3=13.125.247.101

echo $N1, $N2, $N3

# 노드 정보 확인

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i hostnamectl; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -c addr; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -c route; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo iptables -t nat -S; echo; done

# 파드 이름 변수 지정

PODNAME1=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[0].metadata.name}')

PODNAME2=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[1].metadata.name}')

PODNAME3=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[2].metadata.name}')

# 파드 IP 변수 지정

PODIP1=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[0].status.podIP}')

PODIP2=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[1].status.podIP}')

PODIP3=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[2].status.podIP}')

# 자신의 도메인 변수 지정 : 소유하고 있는 자신의 도메인을 입력하시면 됩니다

MyDomain=<자신의 도메인>

MyDomain=gasida.link

MyDnzHostedZoneId=`aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Id" --output text`

echo $MyDnzHostedZoneId

# A 레코드 값 반복 조회

while true; do aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']" | jq ; date ; echo ; sleep 1; done[심화] 이게 돼요? 도커 없이 컨테이너 만들기 3 : 격리 Namespece - Docs , Youtube

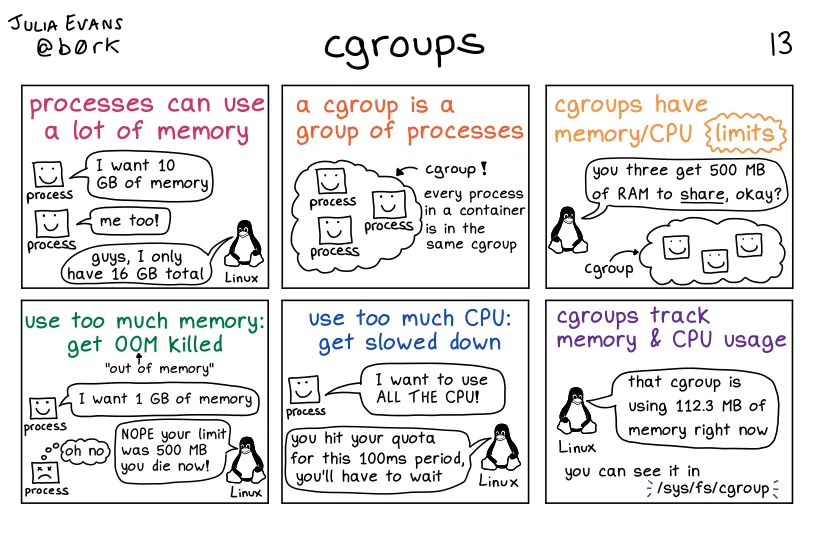

[심화] 이게 돼요? 도커 없이 컨테이너 만들기 4 : 자원 관리, cgroups - Docs , Youtube

[ 요약 ]

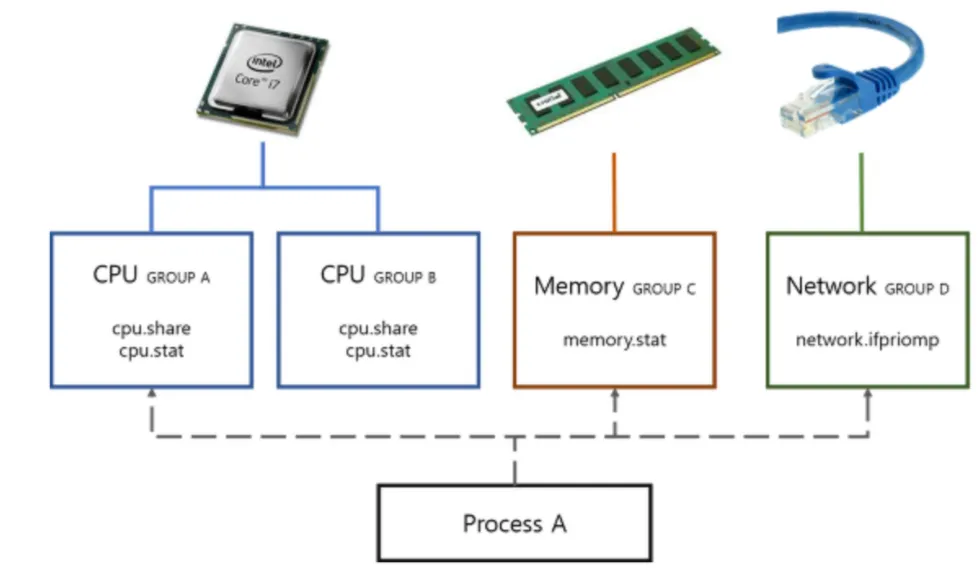

- cgroup이란? : Cpu, Disk I/O, Memory, Network 등 자원 사용을 제한/격리 시키는 커널 기능

- cgroups인가? cgroup 인가?

- 프로세스는 실행 중인 프로그램의 인스턴스를 의미. OS에서 프로세스를 관리하며, 각 프로세스는 고유한 ID(PID)를 가짐.

- 프로세스는 CPU와 메모리를 사용하는 기본 단위로, OS 커널(cgroup)에서 각 프로세스의 자원을 관리함.

- cgroups : Blog1 , Blog2

- cgroup v1, v2 : Blog1 , Blog2 , check

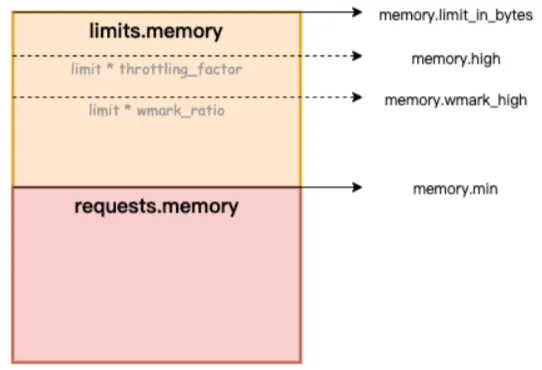

- cgroup v1, v2가 존재하며 v2는 v1에 비해 자원계층구조의 가시성을 향상.

- cgroup v1에서는 request, limit 두개의 자원설정만이 가능했는데, cgroup v2에서는 memoryQoS라는 기능을 추가하여 컨테이너 등에서 쉽사리 OOM이 나지않게 하는 기능 지원 → Memory High : 메모리 사용량 조절 제한. cgroup의 사용량이 높은 경계를 초과하면 cgroup의 프로세스가 제한되고 회수 압력이 커짐

- control groups : 프로세스들의 자원의 사용(CPU, 메모리, 디스크 입출력, 네트워크 등)을 제한, 격리시키는 리눅스 커널 기능 - Link

- 하나 또는 복수의 장치를 묶어서 하나의 그룹을 만들 수 있으며 개별 그룹은 시스템에서 설정한 값만큼 하드웨어를 사용

- 시스템의 프로세스들은 장치별로 특정한 cgroup에 속하여 프로세스가 사용하는 하드웨어 자원의 총량에 제한을 받음

- process를 계층적인 group으로 구성해서, resource 사용을 제한하고 모니터링할 수 있는 linux kernel feature

- cgroup의 interface는 cgroupfs이라 불리는 pseudo-filesystem을 통해 제공됨

- cgroupfs의 subdirectory를 생성/삭제/변경하면서 정의됨

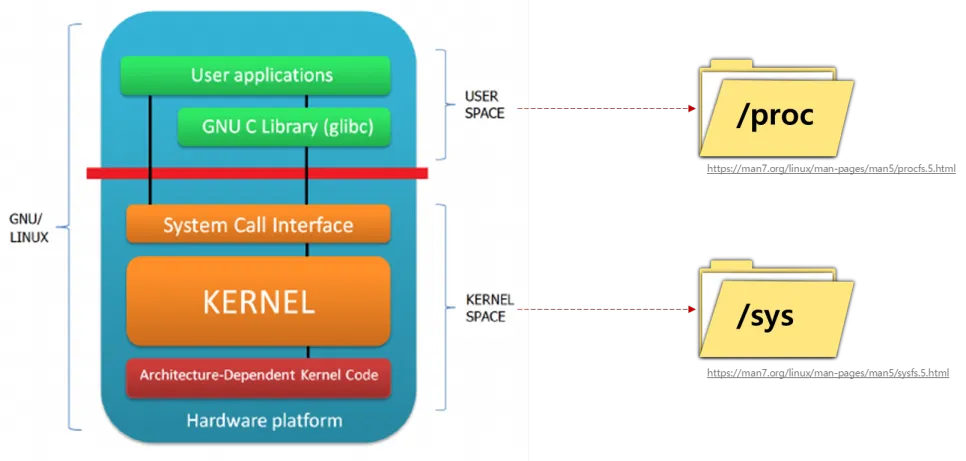

- /proc 와 /sys

- Runtime의 메모리 정보를 파일시스템 폴더에 mount한 pseudo-filesystem

- 커널 2.x 버전까지는 /proc 폴더 하나만 있었지만, 3.x 버전 부터 /sys를 추가로 구분하였음

- /proc, /sys 는 커널이 관리하는 메모리를 마운트했기 때문에 해당 디렉토리에 접근하는 순간 메모리에서 정보를 읽어 오게 됨

[ 참고 - cgroup 실습 ]

#

mount -t cgroup

mount -t cgroup2

cgroup2 on /sys/fs/cgroup type cgroup2 (rw,nosuid,nodev,noexec,relatime,nsdelegate,memory_recursiveprot)

#

findmnt -t cgroup2

TARGET SOURCE FSTYPE OPTIONS

/sys/fs/cgroup cgroup2 cgroup2 rw,nosuid,nodev,noexec,relatime,nsdelegate,memory_recursiveprot

# cgroup2 이외에 proc, bpf 도 있음

findmnt -A

TARGET SOURCE FSTYPE OPTIONS

/ /dev/nvme0n1p1 ext4 rw,relatime,discard,errors=remount-ro

...

├─/proc proc proc rw,nosuid,nodev,noexec,relatime

...

├─/sys sysfs sysfs rw,nosuid,nodev,noexec,relatime

│ ├─/sys/kernel/security securityfs securityfs rw,nosuid,nodev,noexec,relatime

│ ├─/sys/fs/cgroup cgroup2 cgroup2 rw,nosuid,nodev,noexec,relatime,nsdelegate,memory_recursiveprot

│ ├─/sys/fs/pstore pstore pstore rw,nosuid,nodev,noexec,relatime

│ ├─/sys/firmware/efi/efivars efivarfs efivarfs rw,nosuid,nodev,noexec,relatime

│ ├─/sys/fs/bpf bpf bpf rw,nosuid,nodev,noexec,relatime,mode=700

...

# cgroupv1 만 지원 시, cgroup2 출력되지 않음

grep cgroup /proc/filesystems

nodev cgroup

nodev cgroup2

stat -fc %T /sys/fs/cgroup/

cgroup2fs

# 터미널2

sleep 100000

# /proc에 cgroup 정보 확인

cat /proc/cgroups

cat /proc/$(pgrep sleep)/cgroup

0::/user.slice/user-1000.slice/session-7.scope

tree /proc/$(pgrep sleep) -L 2

...

├── ns

│ ├── cgroup -> cgroup:[4026531835]

│ ├── ipc -> ipc:[4026531839]

│ ├── mnt -> mnt:[4026531841]

│ ├── net -> net:[4026531840]

...

# cgroup 목록 확인

ls /sys/fs/cgroup

cat /sys/fs/cgroup/cgroup.controllers

#

tree /sys/fs/cgroup/ -L 1

tree /sys/fs/cgroup/ -L 2

tree /sys/fs/cgroup/user.slice -L 1

tree /sys/fs/cgroup/user.slice/user-1000.slice -L 1

tree /sys/fs/cgroup/user.slice/user-1000.slice -L 2

1. AWS VPC CNI 소개

1-1. 요약 설명

- CNI는 리눅스 컨테이너 간의 네트워킹 제어를 가능케 해주는 플러그인을 만들기 위한 표준이다.

- 기본적으로 라우팅, 터널링과 같은 각종 네트워크 기능들을 사용하게 해 준다.

- CNI 플러그인은 K8S에 Overlay Network를 구성해주며, 이를 통해 다른 노드에 있는 파드와도 통신이 가능하다.

☞ Amazon VPC CNI는 작업자 노드에 aws-node라는 Kubernetes Daemonset으로 배포된다.

작업자 노드가 프로비저닝되면 기본 ENI라고 하는 기본 ENI가 노드에 연결되며, CNI는 노드의 기본 ENIs에 연결된 서브넷에서 ENI 및 보조 IP 주소의 웜 풀을 할당한다.

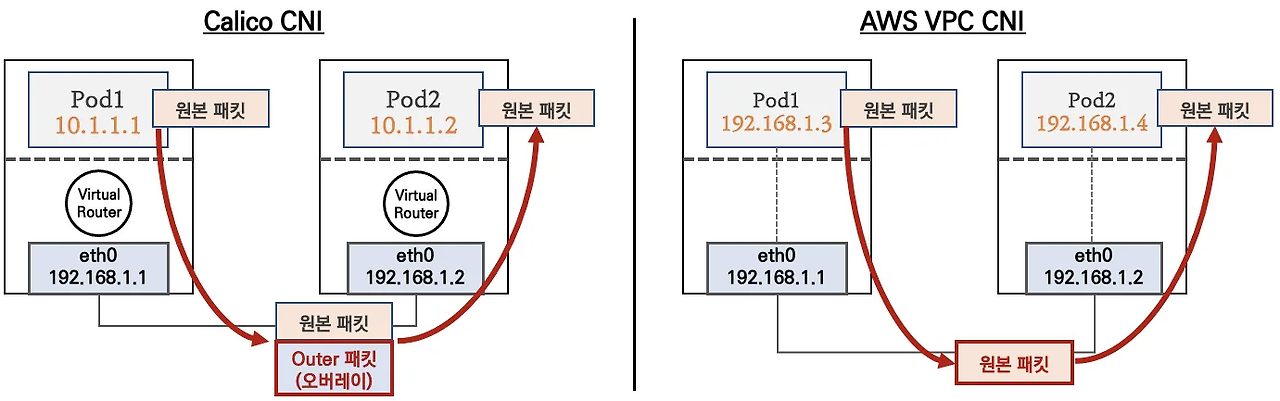

☞ K8S Calico CNI 와 AWS VPC CNI 차이

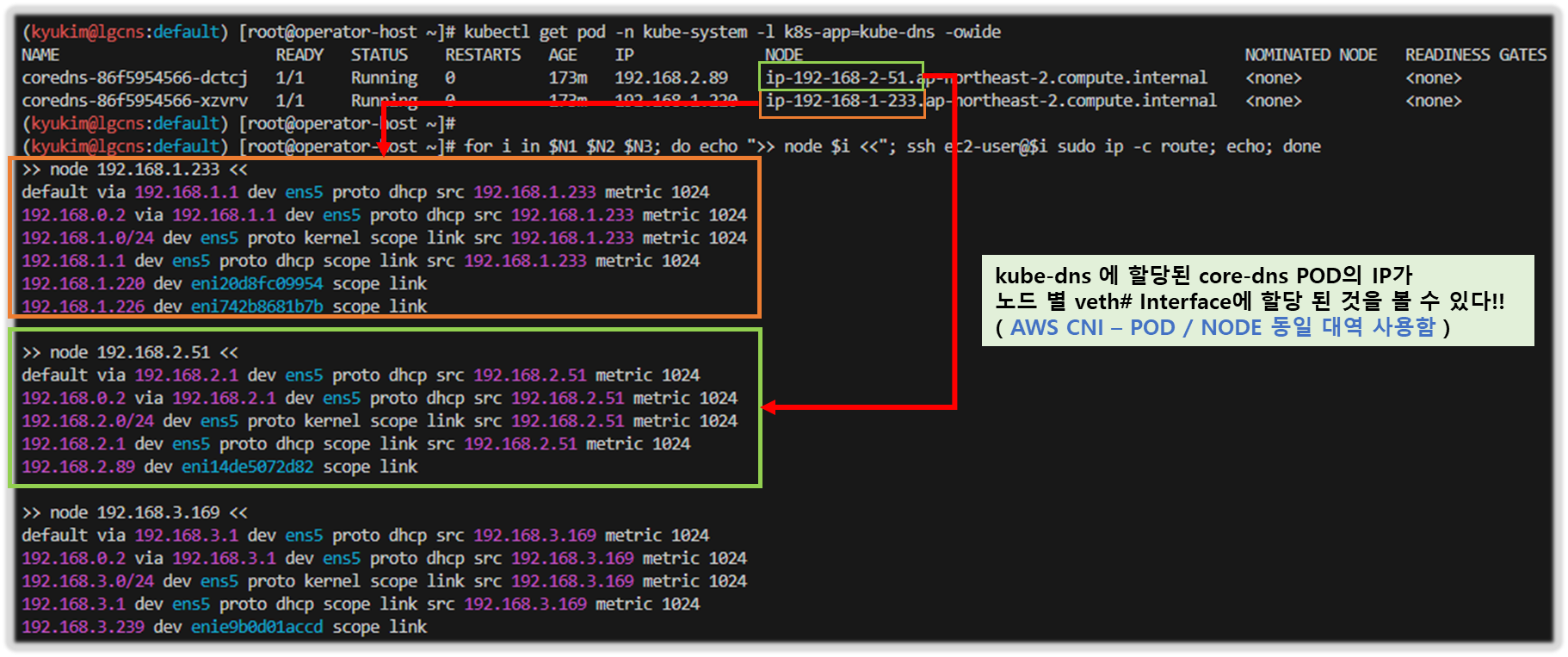

[ AWS VPC CNI의 특징 ]

- 네트워크 통신의 최적화(성능, 지연)를 위해서 노드와 파드의 네트워크 대역을 동일하게 설정함

- 네트워크 대역을 동일하게 설정하면, 파드와 노드 간 통신이 같은 네트워크 대역 내에서 이루어져 추가적인 라우팅 경로가 필요 없게 된다. 이렇게 설정할 경우, 데이터가 전달되는 경로가 짧아지기 때문에 전송 속도가 빨라지고 지연(latency)도 줄어들게 된다.

- 파드간 통신 시 일반적으로 K8S CNI는 오버레이(VXLAN, IP-IP 등) 통신을 하고, AWS VPC CNI는 동일 대역으로 직접 통신을 한다.

[ 참고 자료 ]

1-2. 실습 - 따라하기

▶ 네트워크 기본정보 확인

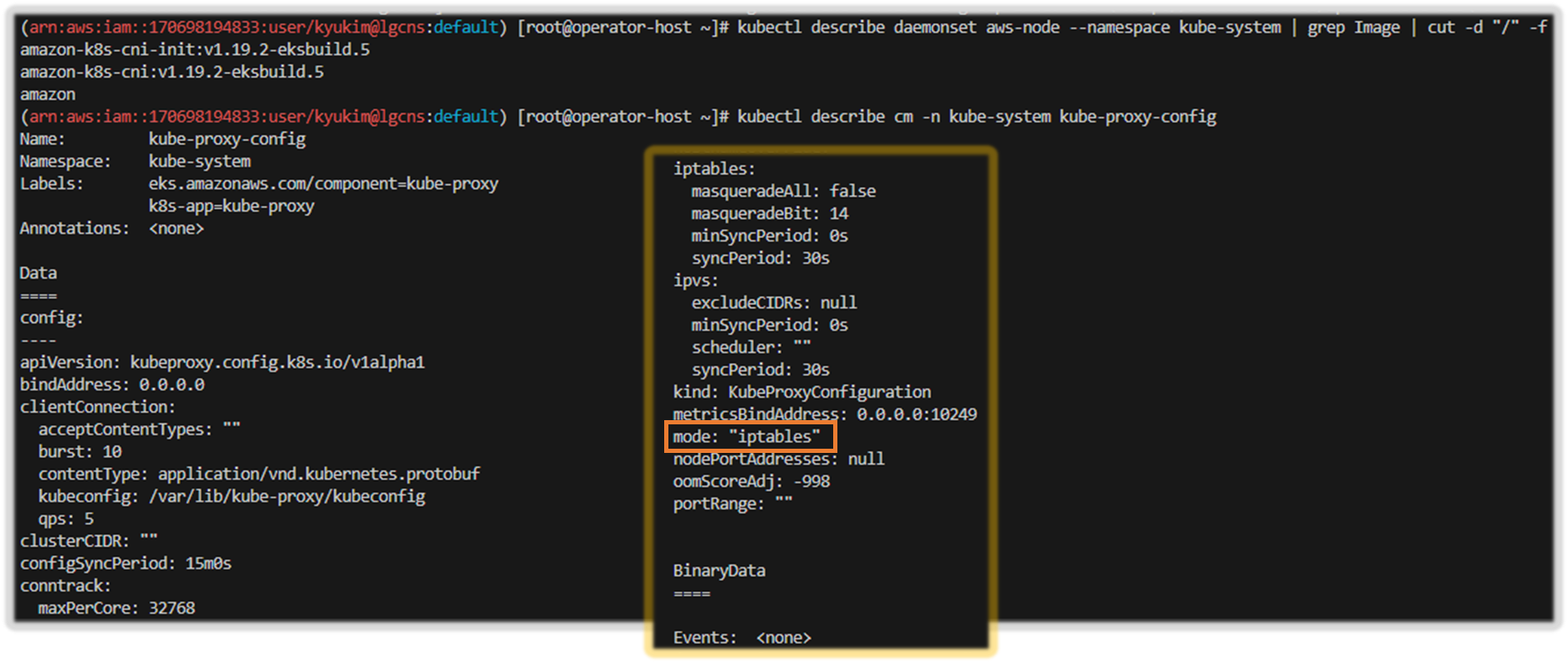

# CNI 정보 확인

kubectl describe daemonset aws-node --namespace kube-system | grep Image | cut -d "/" -f 2

# kube-proxy config 확인 : 모드 iptables 사용 >> ipvs 모드로 변경 해보자!

kubectl describe cm -n kube-system kube-proxy-config

...

mode: "iptables"

...

# 노드 IP 확인

aws ec2 describe-instances --query "Reservations[*].Instances[*].{PublicIPAdd:PublicIpAddress,PrivateIPAdd:PrivateIpAddress,InstanceName:Tags[?Key=='Name']|[0].Value,Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

# 파드 IP 확인

kubectl get pod -n kube-system -o=custom-columns=NAME:.metadata.name,IP:.status.podIP,STATUS:.status.phase

# 파드 이름 확인

kubectl get pod -A -o name

# 파드 갯수 확인

kubectl get pod -A -o name | wc -l

[ 실행 결과 - 한 눈에 보기 ]

1. CNI 정보 및 Kube-proxy 정보 확인

kubectl describe cm -n kube-system kube-proxy

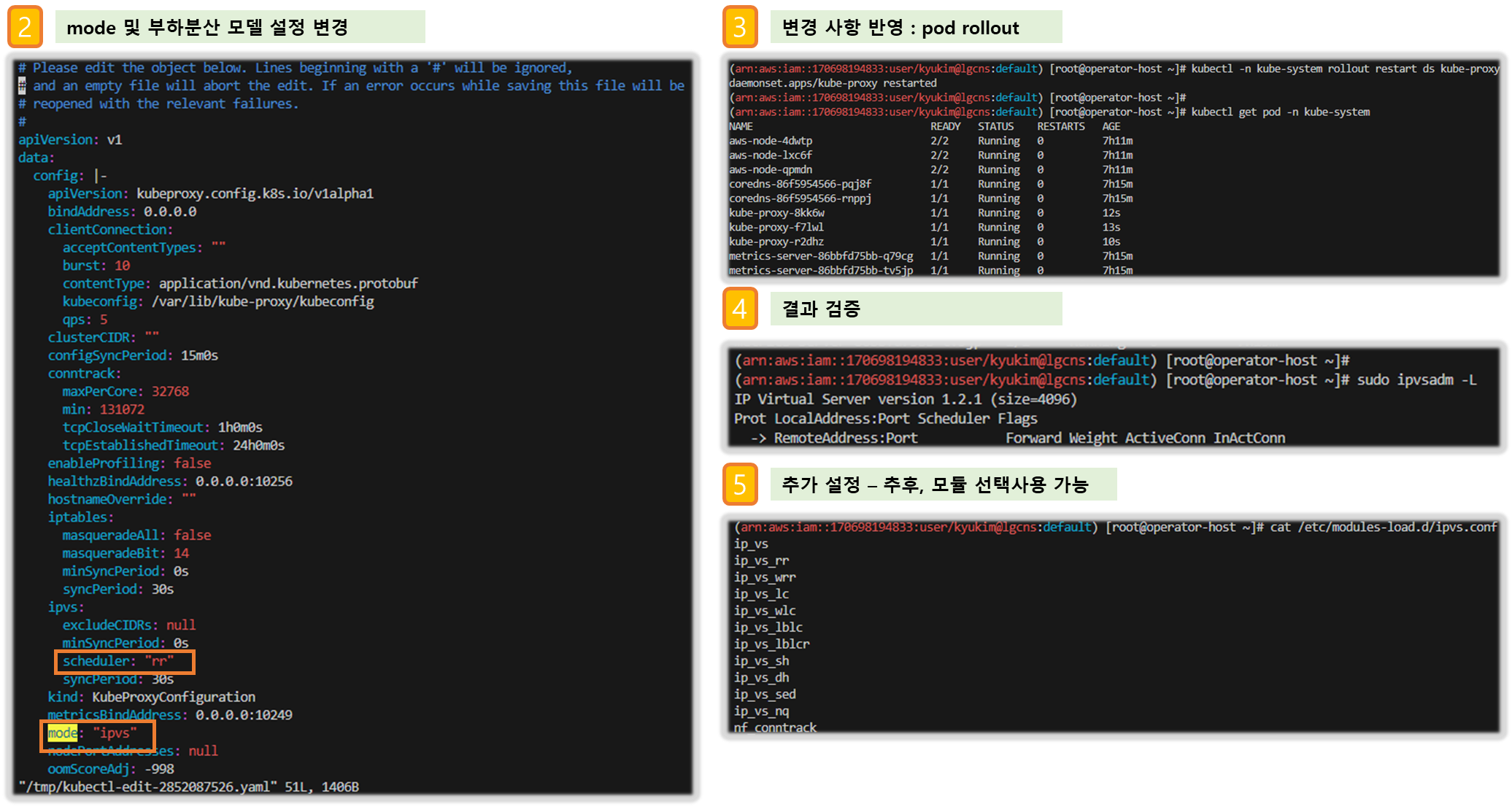

2. kube-proxy 모드 변경

Ref. Link : AWS Link, Blog Link

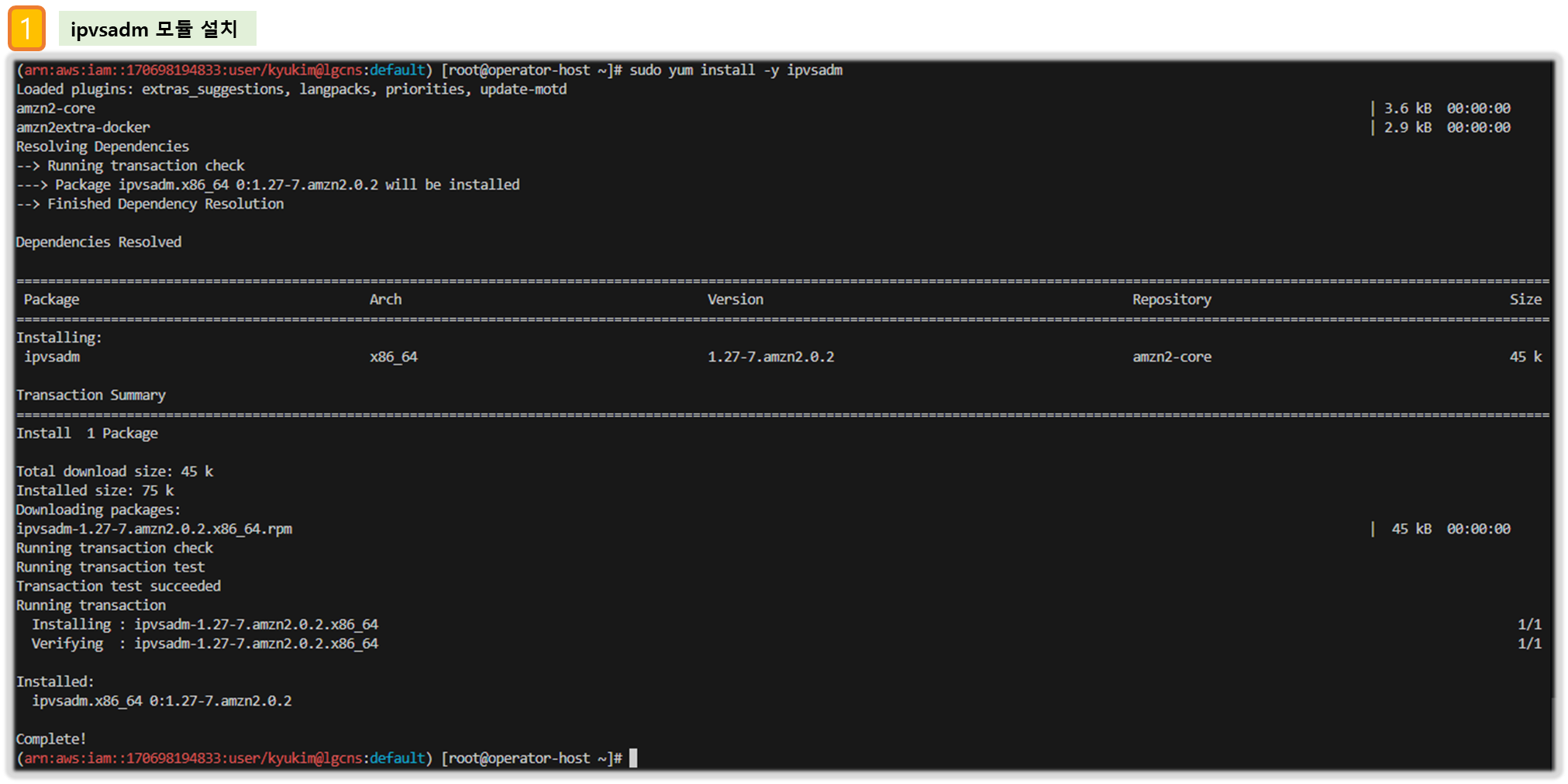

Step1. IPVS 설치

## centOS

sudo yum install -y ipvs

Step2. config map 확인

kubectl describe cm -n kube-system kube-proxy

Step3. kube-proxy config map 편집

kubectl edit cm -n kube-system kube-proxy-config

☞ mode : "iptables" -> "ipvs" 로 수정 후, POD 재배포

round-robin 사용할 경우 : scheduler : "rr" 추가 한다!!

[예시]

iptables:

masqueradeAll: false

masqueradeBit: 14

minSyncPeriod: 0s

syncPeriod: 30s

ipvs:

excludeCIDRs: null

minSyncPeriod: 0s

scheduler: "rr"

syncPeriod: 30s

kind: KubeProxyConfiguration

metricsBindAddress: 0.0.0.0:10249

mode: "ipvs"

nodePortAddresses: null

oomScoreAdj: -998

portRange: ""

udpIdleTimeout: 250ms

## ds 통한 POD roll-out

kubectl -n kube-system rollout restart ds kube-proxy

## ipvs mode 검증

sudo ipvsadm -L

sudo ipvsadm -Ln☞ /etc/modules-load.d/ 디렉터리 내의 파일에 이러한 모듈 사용 (권장)

sudo sh -c 'cat << EOF > /etc/modules-load.d/ipvs.conf

ip_vs

ip_vs_rr

ip_vs_wrr

ip_vs_lc

ip_vs_wlc

ip_vs_lblc

ip_vs_lblcr

ip_vs_sh

ip_vs_dh

ip_vs_sed

ip_vs_nq

nf_conntrack

EOF'

☞ 다음 명령을 실행하여 이미 실행 중인 시스템에 이러한 모듈을 로드할 수 있다.

sudo modprobe ip_vs

sudo modprobe ip_vs_rr

sudo modprobe ip_vs_wrr

sudo modprobe ip_vs_lc

sudo modprobe ip_vs_wlc

sudo modprobe ip_vs_lblc

sudo modprobe ip_vs_lblcr

sudo modprobe ip_vs_sh

sudo modprobe ip_vs_dh

sudo modprobe ip_vs_sed

sudo modprobe ip_vs_nq

sudo modprobe nf_conntrack

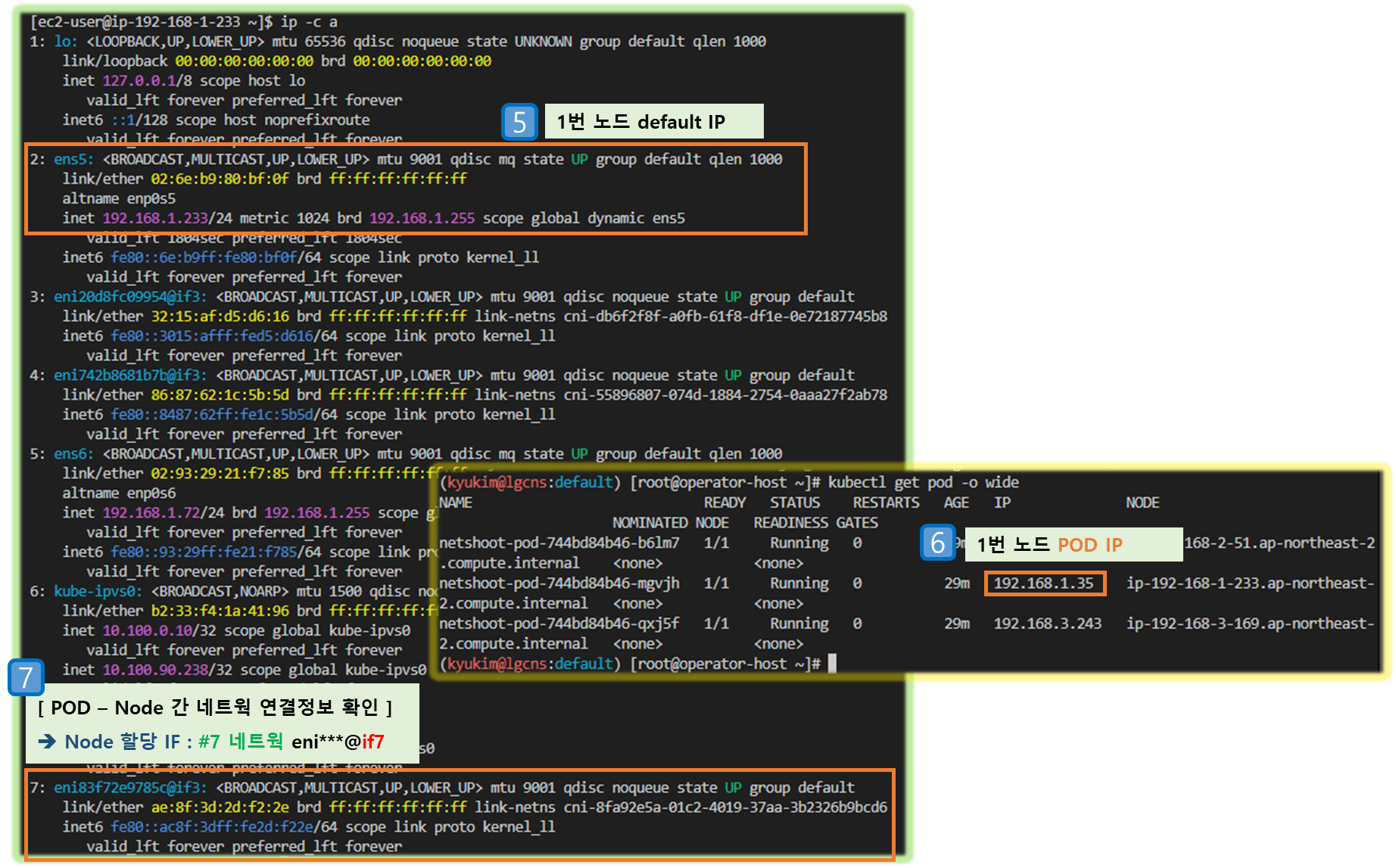

▶ 노드에 네트워크 정보 확인하기

# CNI 정보 확인

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i tree /var/log/aws-routed-eni; echo; done

ssh ec2-user@$N1 sudo cat /var/log/aws-routed-eni/plugin.log | jq

ssh ec2-user@$N1 sudo cat /var/log/aws-routed-eni/ipamd.log | jq

ssh ec2-user@$N1 sudo cat /var/log/aws-routed-eni/egress-v6-plugin.log | jq

ssh ec2-user@$N1 sudo cat /var/log/aws-routed-eni/ebpf-sdk.log | jq

ssh ec2-user@$N1 sudo cat /var/log/aws-routed-eni/network-policy-agent.log | jq

# 네트워크 정보 확인 : eniY는 pod network 네임스페이스와 veth pair

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -br -c addr; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -c addr; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -c route; echo; done

ssh ec2-user@$N1 sudo iptables -t nat -S

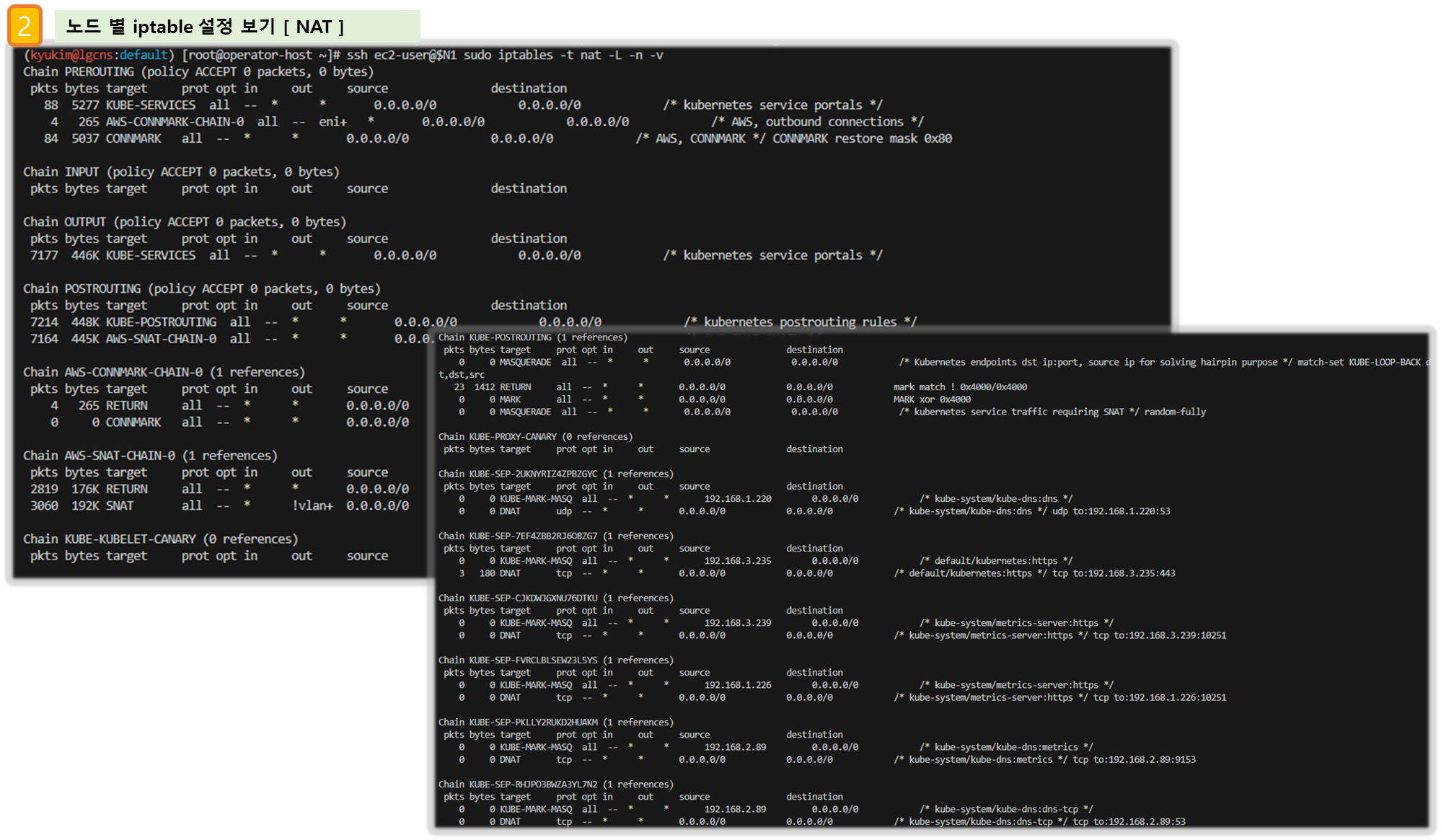

ssh ec2-user@$N1 sudo iptables -t nat -L -n -v

[ 실행 결과 - 한 눈에 보기 ]

2. 노드에서 기본 네트워크 정보 확인

2-1. 노드 네트워크 구성 및 특징

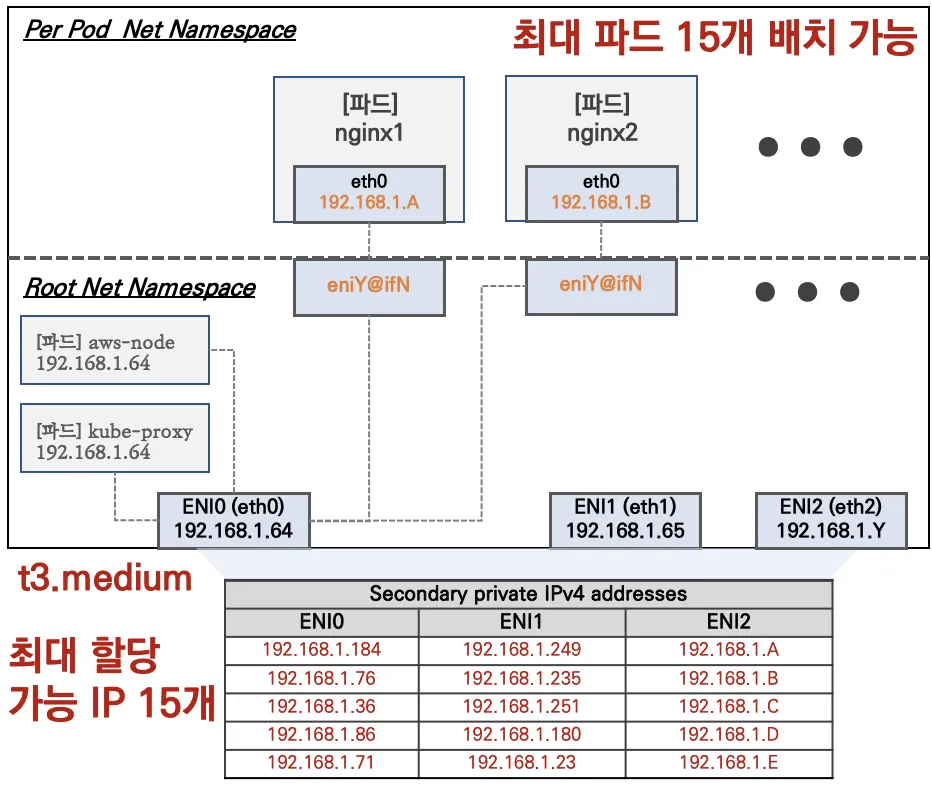

- Network 네임스페이스는 호스트(Root)와 파드 별(Per Pod)로 구분된다

- 특정한 파드(kube-proxy, aws-node)는 호스트(Root)의 IP를 그대로 사용한다 ⇒ 파드의 Host Network 옵션

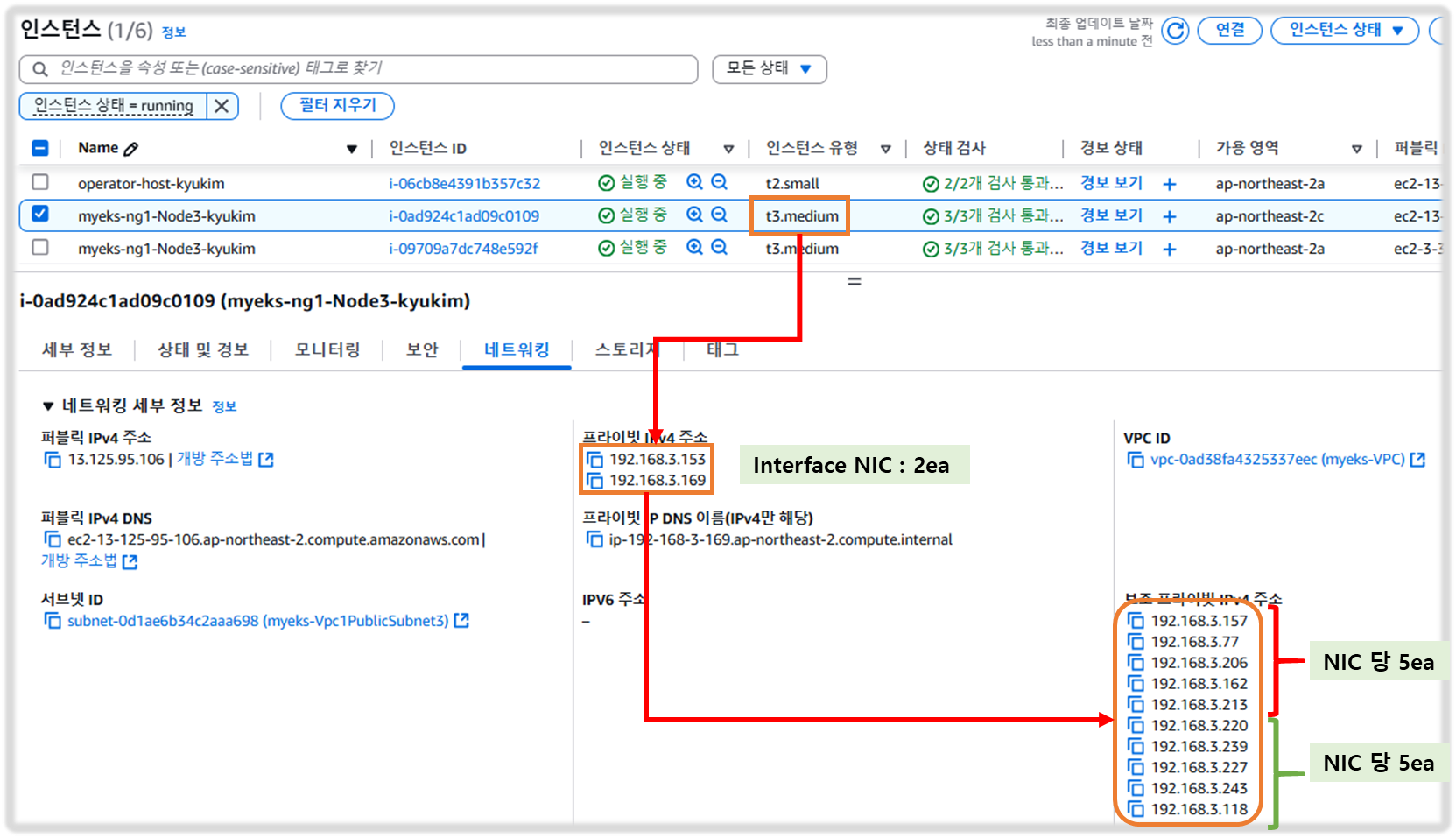

- t3.medium 의 경우 ENI 마다 최대 6개의 IP를 가질 수 있다

- ENI0, ENI1 으로 2개의 ENI는 자신의 IP 이외에 추가적으로 5개의 보조 프라이빗 IP를 가질수 있다

- coredns 파드는 veth 으로 호스트에는 eniY@ifN 인터페이스와 파드에 eth0 과 연결되어 있다

2-2. 실습

1) 보조 IPv4를 사용하는 지 확인

# coredns 파드 IP 정보 확인

kubectl get pod -n kube-system -l k8s-app=kube-dns -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

coredns-6777fcd775-57k77 1/1 Running 0 70m 192.168.1.142 ip-192-168-1-251.ap-northeast-2.compute.internal <none> <none>

coredns-6777fcd775-cvqsb 1/1 Running 0 70m 192.168.2.75 ip-192-168-2-34.ap-northeast-2.compute.internal <none> <none>

# 노드의 라우팅 정보 확인 >> EC2 네트워크 정보의 '보조 프라이빗 IPv4 주소'와 비교해보자

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -c route; echo; done

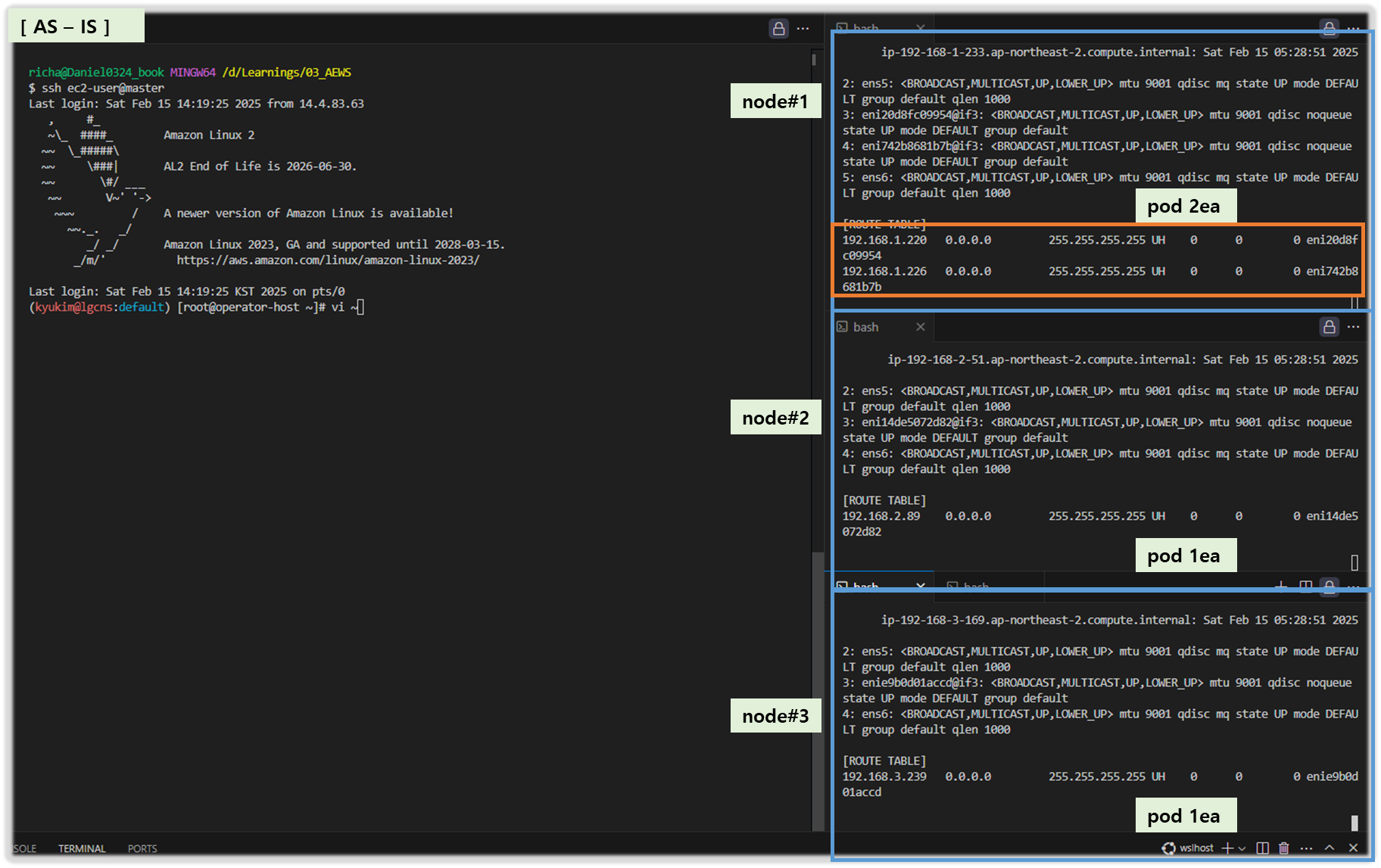

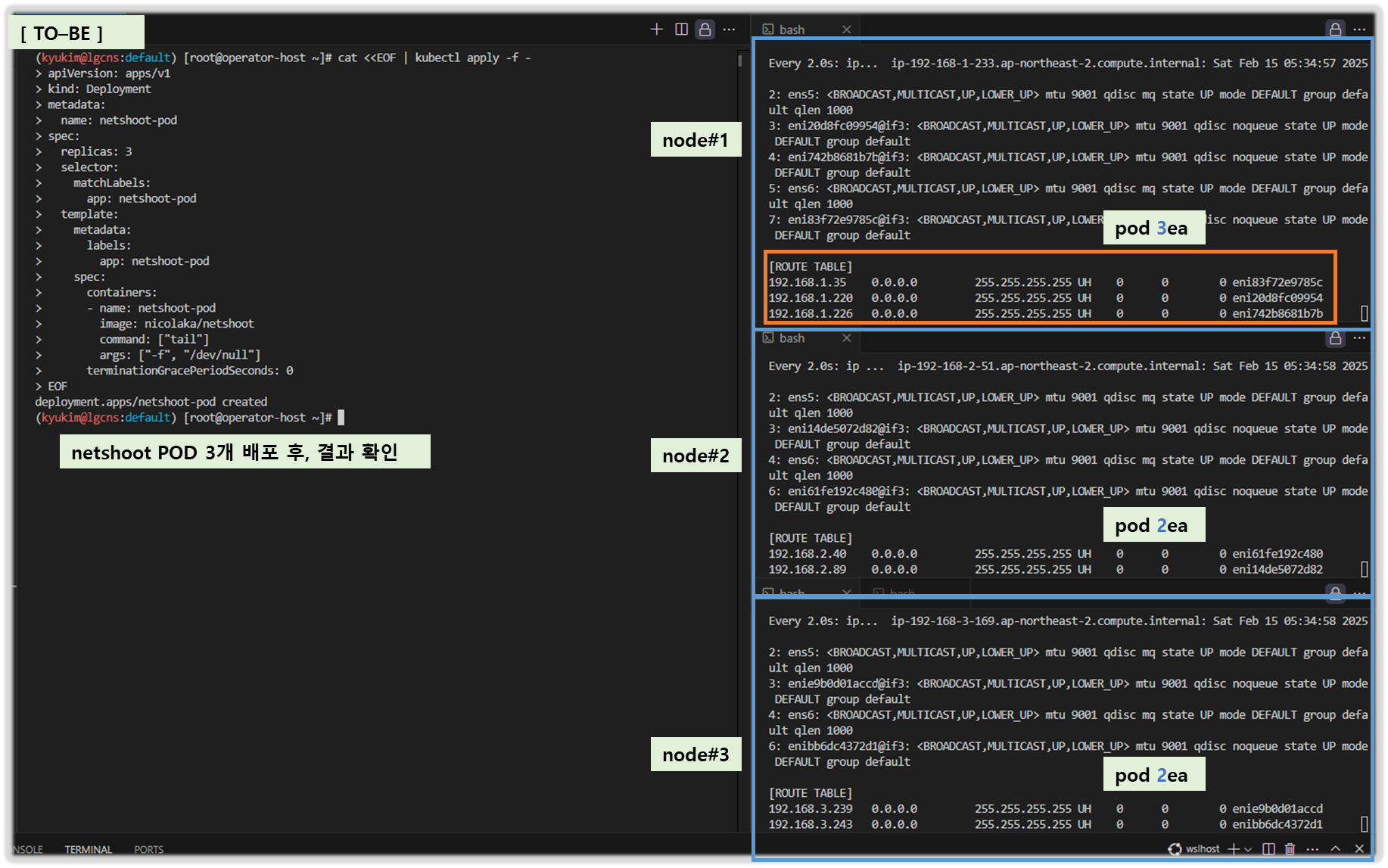

2) 테스트용 netshoot-pod 디플로이먼트 생성 - nicolaka/netshoot

# [터미널1~3] 노드 모니터링

ssh ec2-user@$N1

watch -d "ip link | egrep 'ens|eni' ;echo;echo "[ROUTE TABLE]"; route -n | grep eni"

ssh ec2-user@$N2

watch -d "ip link | egrep 'ens|eni' ;echo;echo "[ROUTE TABLE]"; route -n | grep eni"

ssh ec2-user@$N3

watch -d "ip link | egrep 'ens|eni' ;echo;echo "[ROUTE TABLE]"; route -n | grep eni"

# 테스트용 netshoot-pod 디플로이먼트 생성

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: netshoot-pod

spec:

replicas: 3

selector:

matchLabels:

app: netshoot-pod

template:

metadata:

labels:

app: netshoot-pod

spec:

containers:

- name: netshoot-pod

image: nicolaka/netshoot

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

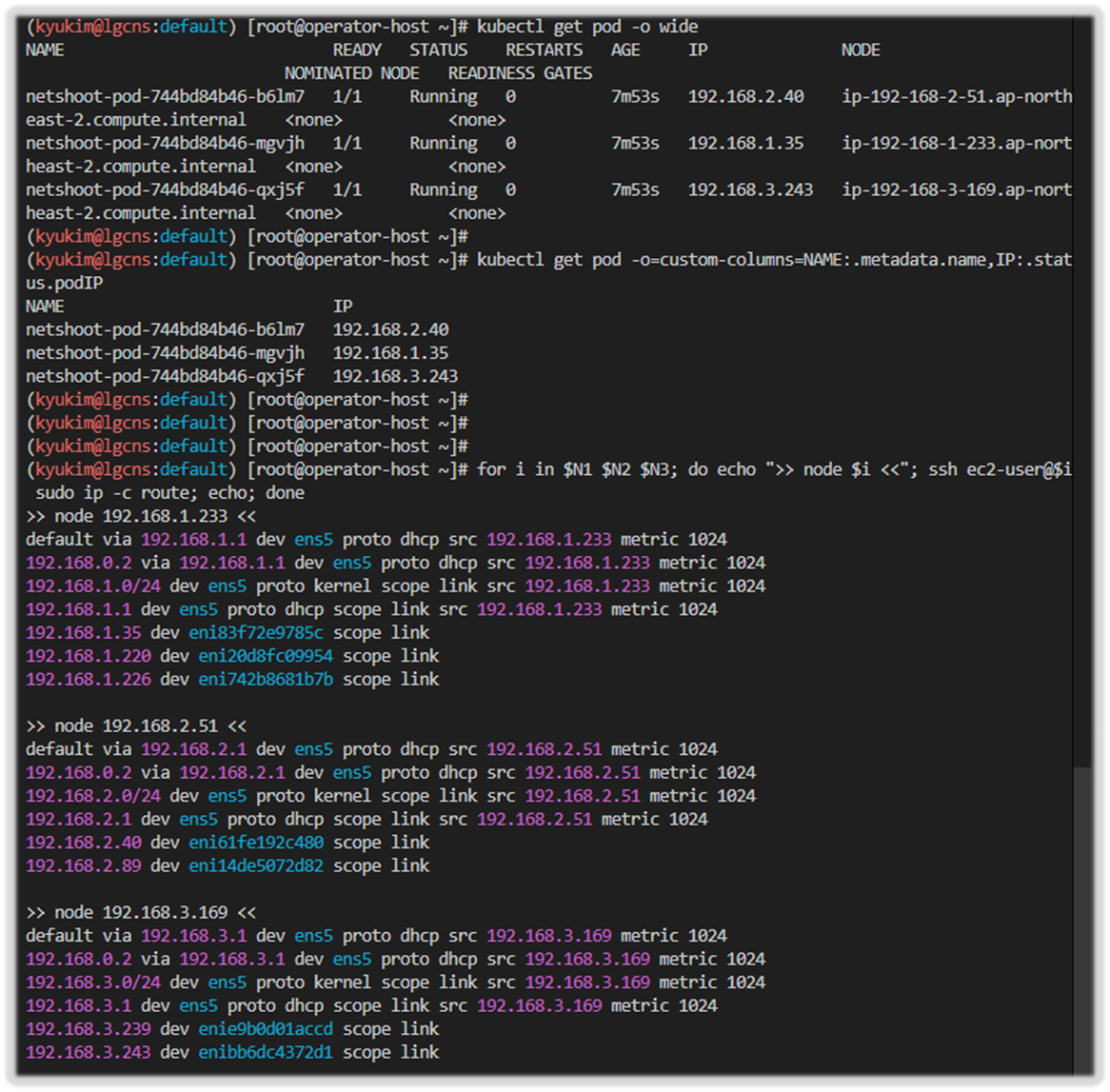

# 파드 이름 변수 지정

PODNAME1=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[0].metadata.name}')

PODNAME2=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[1].metadata.name}')

PODNAME3=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[2].metadata.name}')

# 파드 확인

kubectl get pod -o wide

kubectl get pod -o=custom-columns=NAME:.metadata.name,IP:.status.podIP

# 노드에 라우팅 정보 확인

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -c route; echo; done- 파드가 생성되면, 워커 노드에 eniY@ifN 추가되고 라우팅 테이블에도 정보가 추가된다

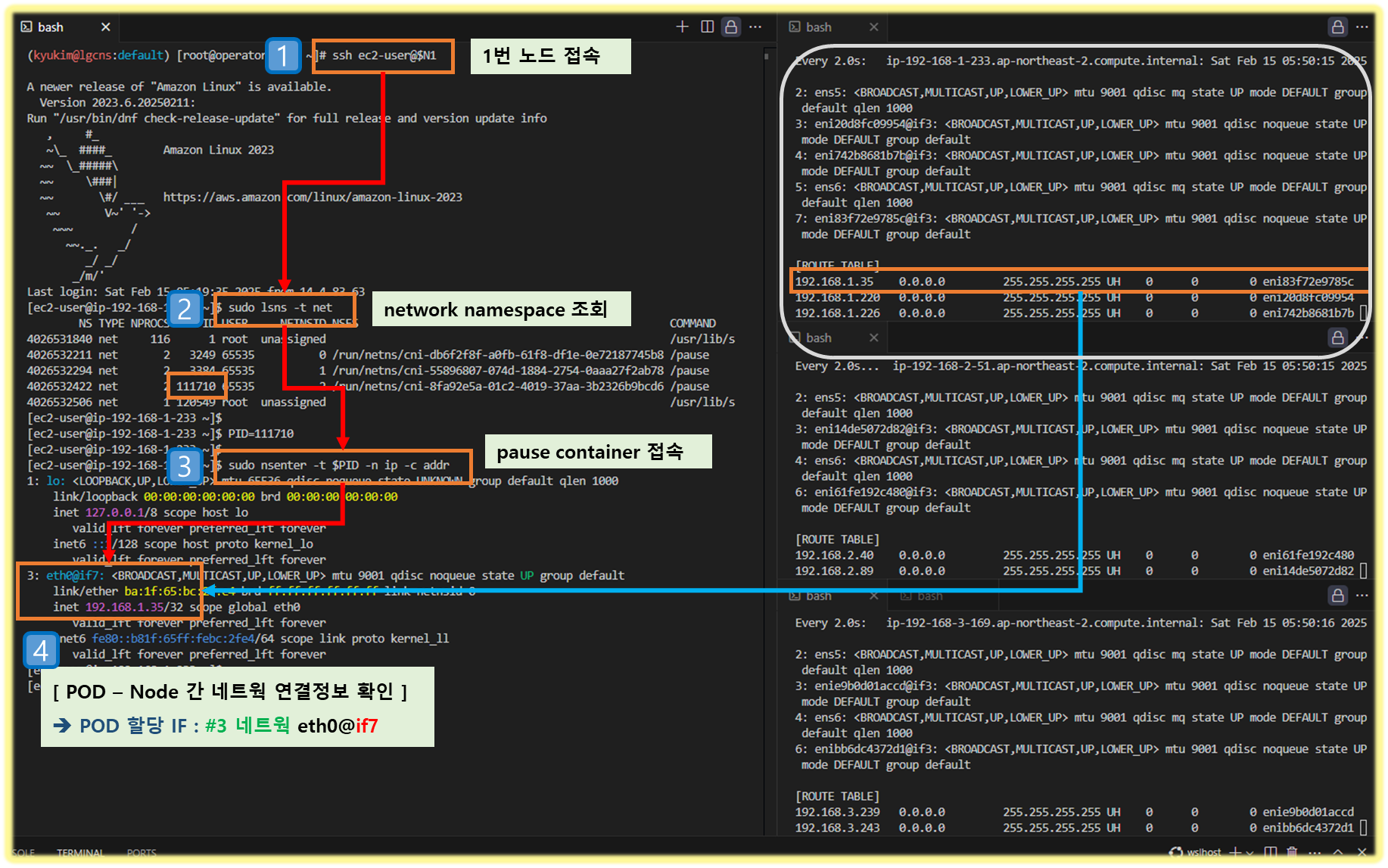

- 테스트용 파드 eniY 정보 확인 - 워커 노드 EC2

# 노드3에서 네트워크 인터페이스 정보 확인

ssh ec2-user@$N3

----------------

ip -br -c addr show

ip -c link

ip -c addr

ip route # 혹은 route -n

# 네임스페이스 정보 출력 -t net(네트워크 타입)

sudo lsns -t net

# PID 정보로 파드 정보 확인

PID=<PID> # PID 높은 것 중 COMMAND가 pause 인것

sudo nsenter -t $PID -n ip -c addr

sudo nsenter -t $PID -n ip -c route

exit

----------------

- 테스트용 파드 접속(exec) 후 확인

# 테스트용 파드 접속(exec) 후 Shell 실행

kubectl exec -it $PODNAME1 -- zsh

# 아래부터는 pod-1 Shell 에서 실행 : 네트워크 정보 확인

----------------------------

ip -c addr

ip -c route

route -n

ping -c 1 <pod-2 IP>

ps

cat /etc/resolv.conf

exit

----------------------------

# 파드2 Shell 실행

kubectl exec -it $PODNAME2 -- ip -c addr

# 파드3 Shell 실행

kubectl exec -it $PODNAME3 -- ip -br -c addr[ 실행 결과 - 한 눈에 보기 ]

☞ POD 배포 전/후, 노드 별 IF 할당 변화 확인하기

☞ 노드에 떠 있는 POD (container) 진입하여 Network 정보 확인

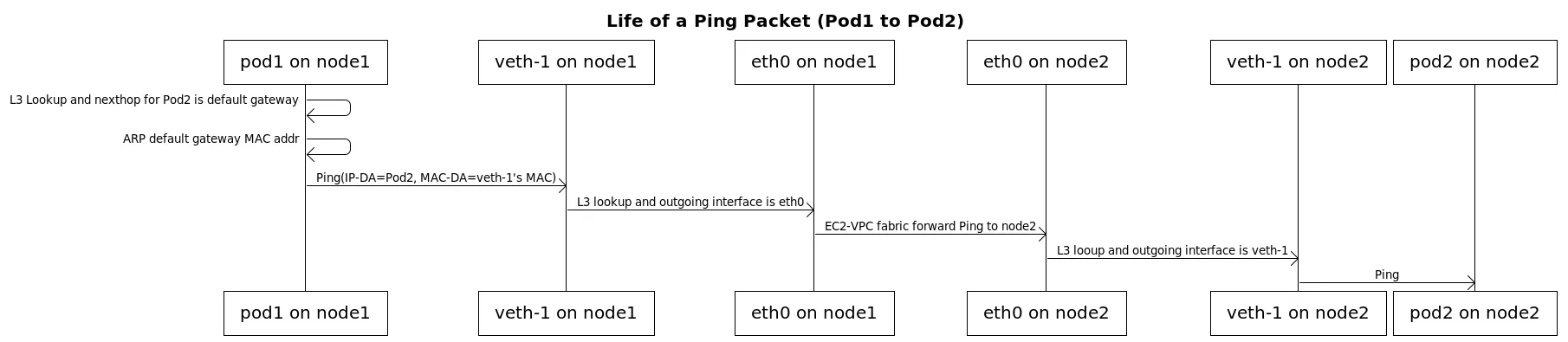

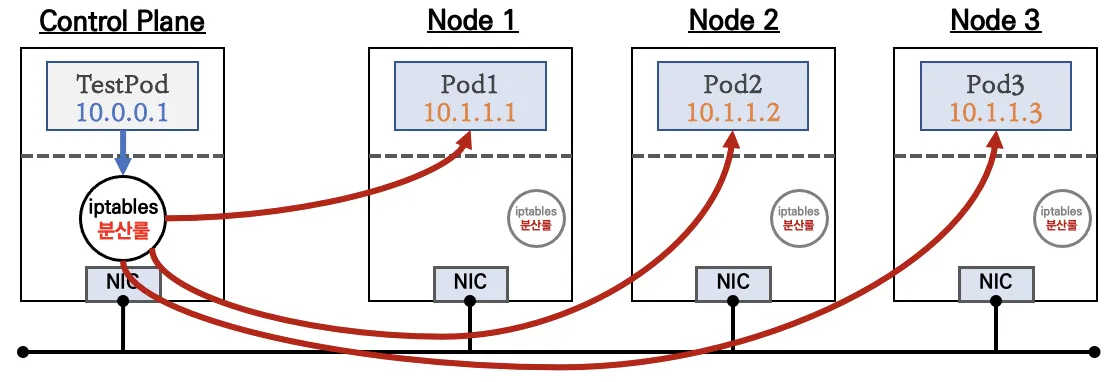

3. 노드 간 파드 통신

3-1. 네트웍 통신 Flow 확인

- 목표 : 파드 간 통신 시 tcpdump를 통해서 통신과정 확인

- 파드간 통신 흐름 : AWS VPC CNI 경우 별도의 오버레이(Overlay) 통신 기술 없이, VPC Native 하게 파드간 직접 통신이 가능하다

[참고- 파드 간 통신 packet Life cycle]

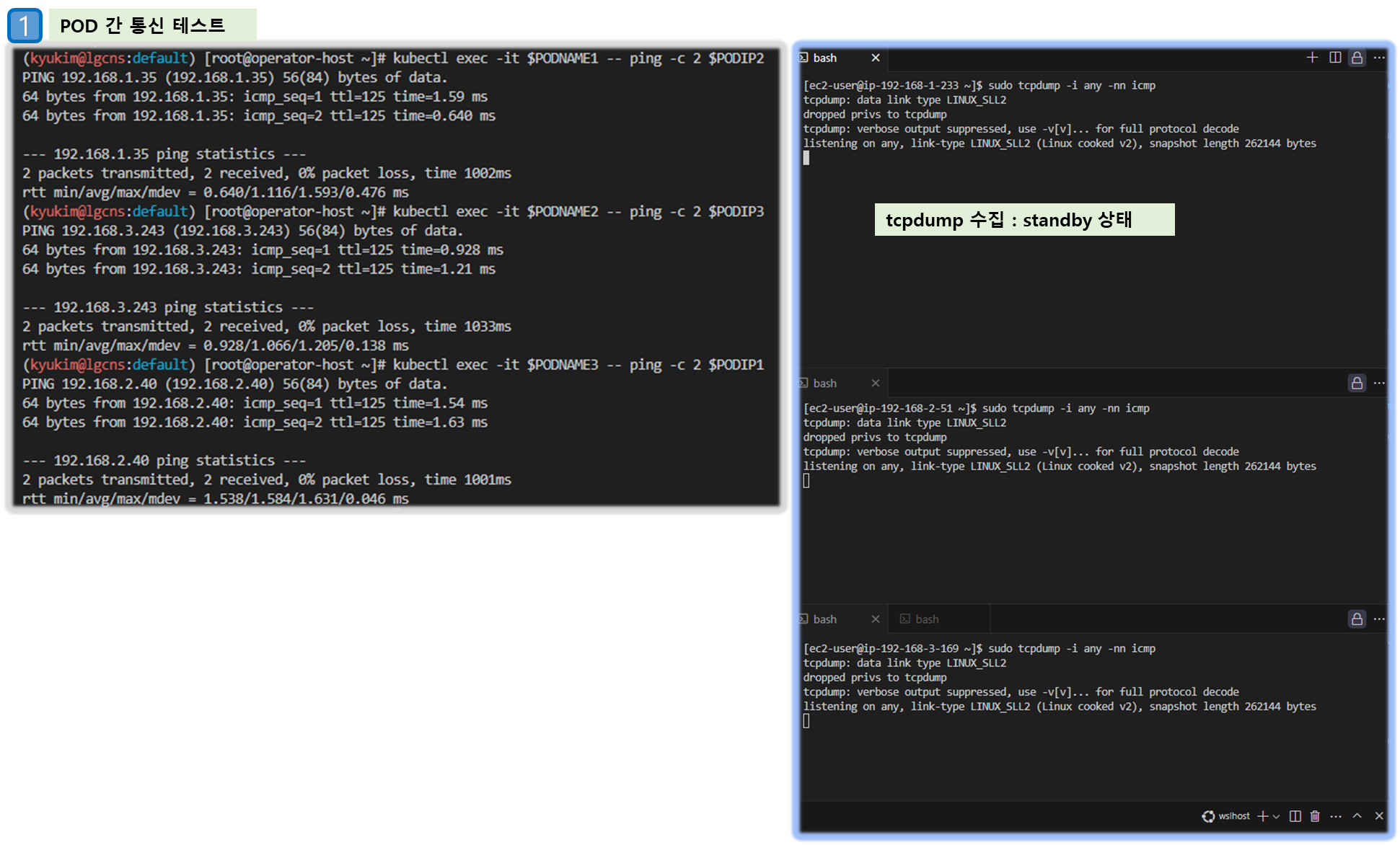

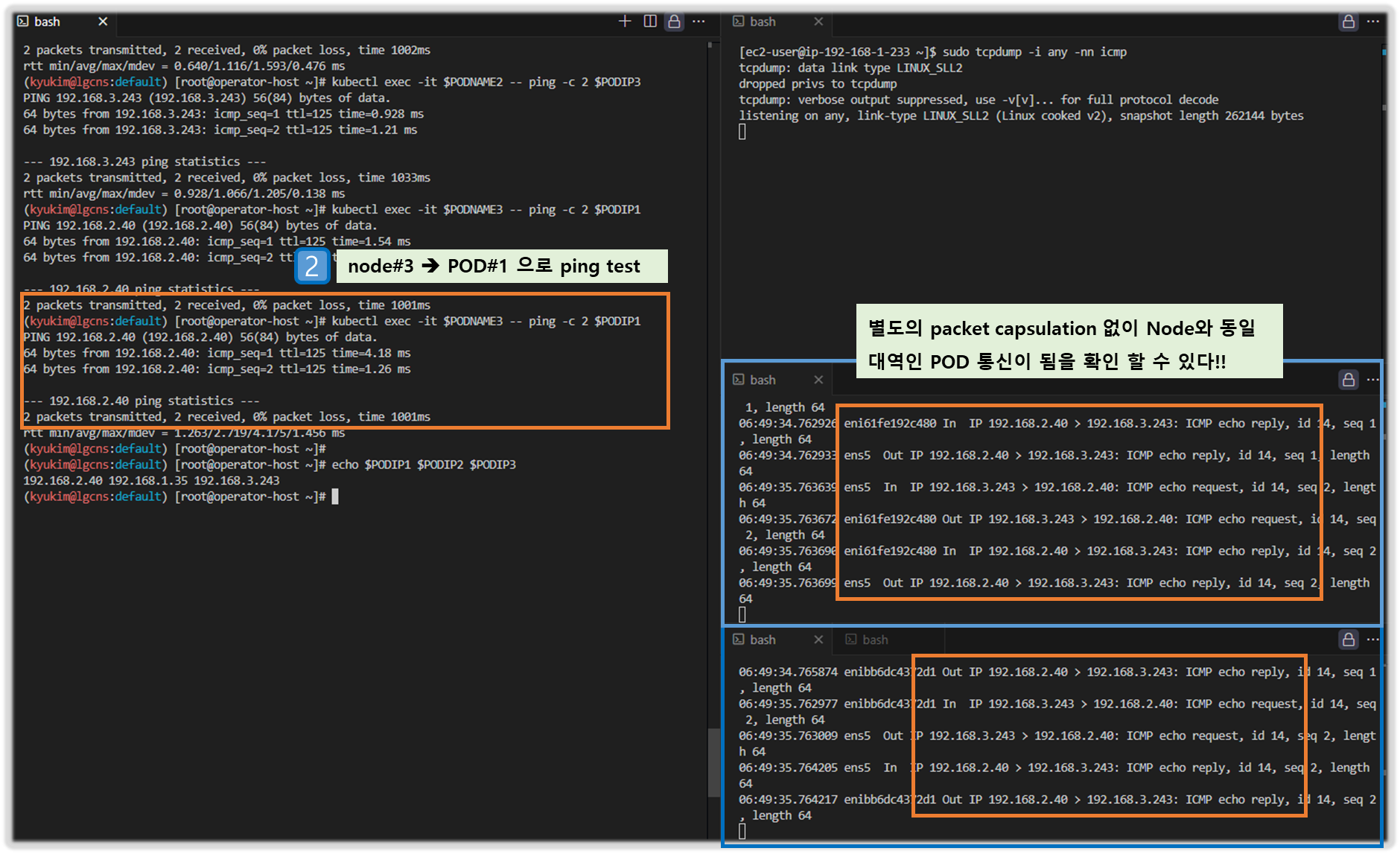

3-2. 실습

☞ 파드간 통신 테스트 및 확인 : 별도의 NAT 동작 없이 통신 가능!

# 파드 IP 변수 지정

PODIP1=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[0].status.podIP}')

PODIP2=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[1].status.podIP}')

PODIP3=$(kubectl get pod -l app=netshoot-pod -o jsonpath='{.items[2].status.podIP}')

# 파드1 Shell 에서 파드2로 ping 테스트

kubectl exec -it $PODNAME1 -- ping -c 2 $PODIP2

# 파드2 Shell 에서 파드3로 ping 테스트

kubectl exec -it $PODNAME2 -- ping -c 2 $PODIP3

# 파드3 Shell 에서 파드1로 ping 테스트

kubectl exec -it $PODNAME3 -- ping -c 2 $PODIP1

# 워커 노드 EC2 : TCPDUMP 확인

## For Pod to external (outside VPC) traffic, we will program iptables to SNAT using Primary IP address on the Primary ENI.

sudo tcpdump -i any -nn icmp

sudo tcpdump -i ens5 -nn icmp

sudo tcpdump -i ens6 -nn icmp

sudo tcpdump -i eniYYYYYYYY -nn icmp

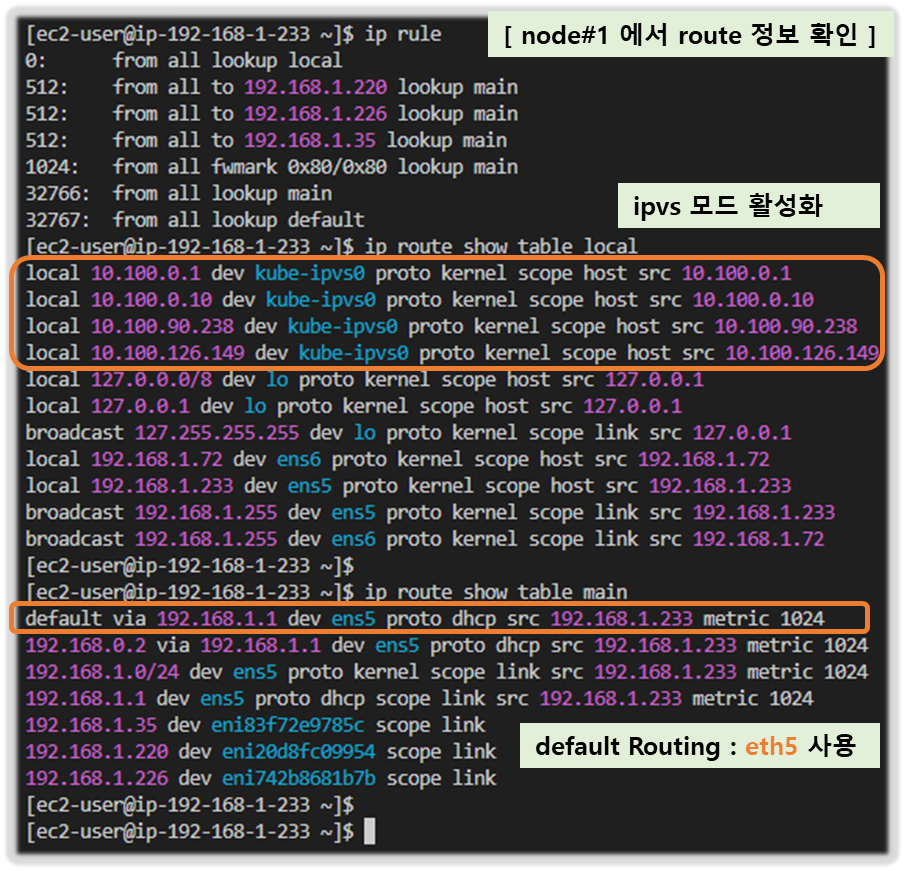

[워커 노드1]

# routing policy database management 확인

ip rule

# routing table management 확인

ip route show table local

# 디폴트 네트워크 정보를 ens5 을 통해서 빠져나간다

ip route show table main

default via 192.168.1.1 dev ens5

...[ 실행 결과 - 한 눈에 보기 ]

Step1. 노드 별 POD에서 상대 노드 POD 호출 테스트

Step2. 노드 별 라우팅 정보 확인

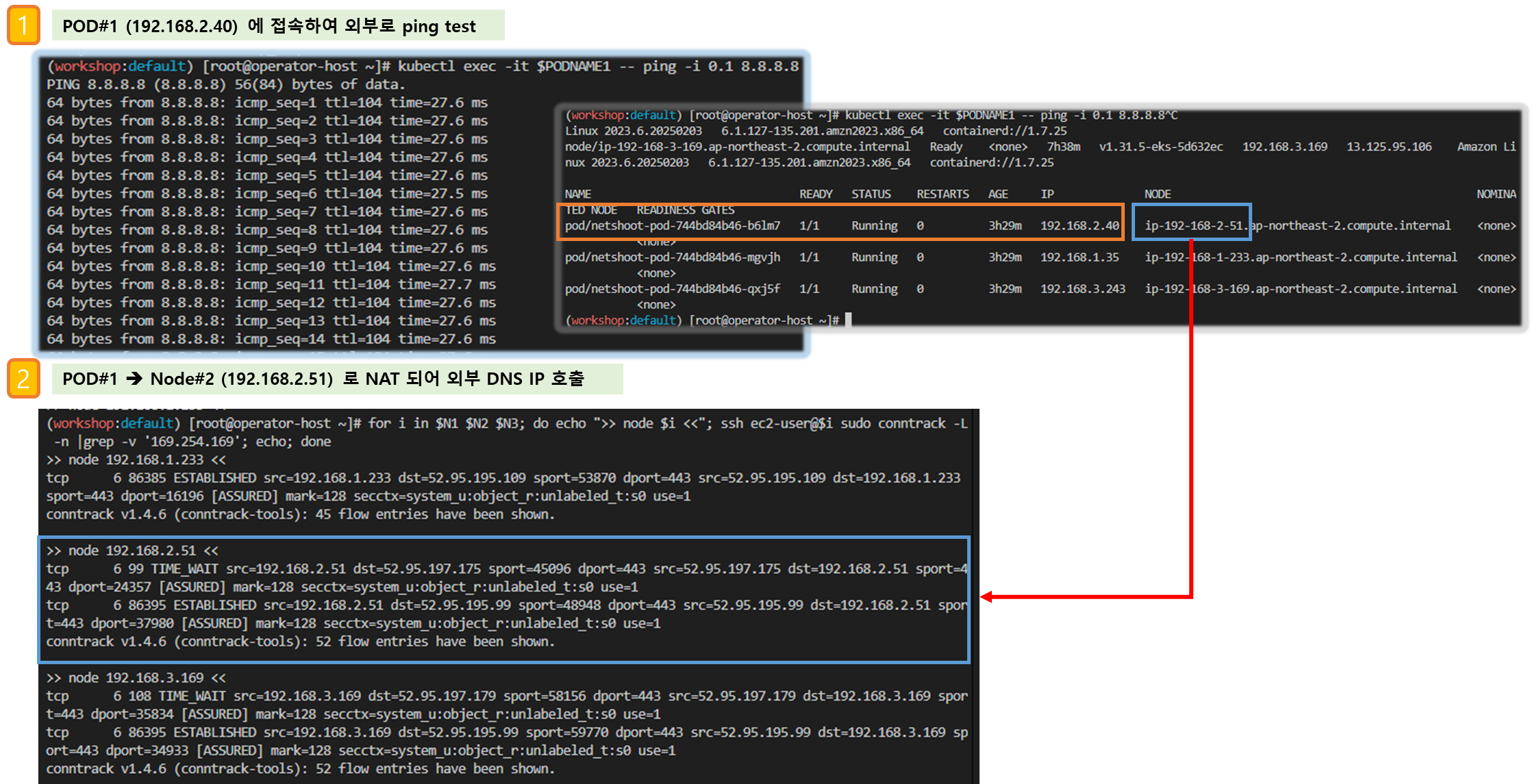

4. 파드에서 외부 통신

4-1. POD 에서 외부 통신 흐름이해

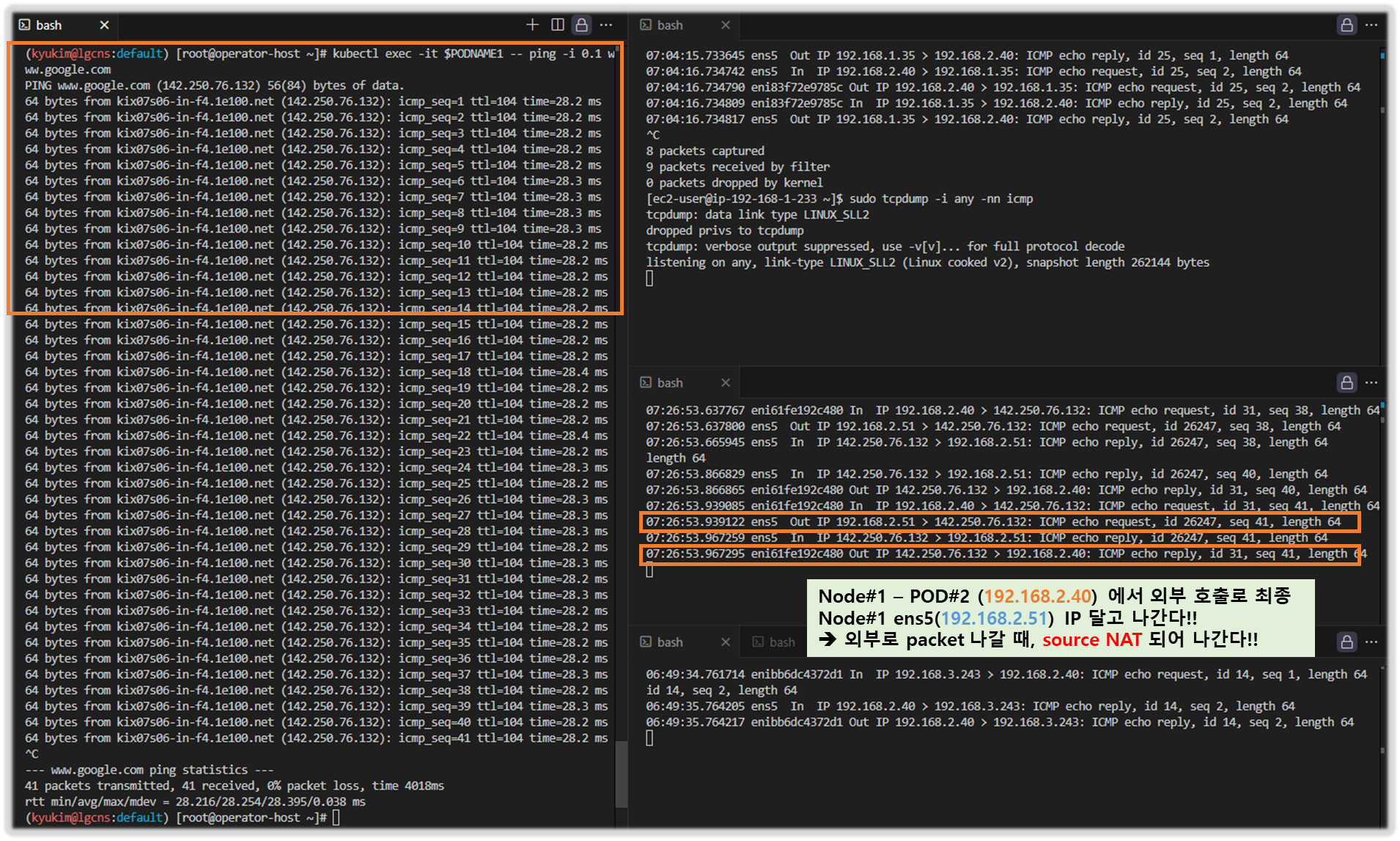

☞ 파드에서 외부 통신 흐름 : iptable 에 SNAT 을 통하여 노드의 eth0(ens5) IP로 변경되어서 외부와 통신됨

- VPC CNI 의 External source network address translation (SNAT) 설정에 따라, 외부(인터넷) 통신 시 SNAT 하거나 혹은 SNAT 없이 통신을 할 수 있다 - 링크

4-2. 실습

☞ 파드에서 외부 통신 테스트 및 확인

- 파드 shell 실행 후 외부로 ping 테스트 & 워커 노드에서 tcpdump 및 iptables 정보 확인

# pod-1 Shell 에서 외부로 ping

kubectl exec -it $PODNAME1 -- ping -c 1 www.google.com

kubectl exec -it $PODNAME1 -- ping -i 0.1 www.google.com

kubectl exec -it $PODNAME1 -- ping -i 0.1 8.8.8.8

# 워커 노드 EC2 : TCPDUMP 확인

sudo tcpdump -i any -nn icmp

sudo tcpdump -i ens5 -nn icmp

# 퍼블릭IP 확인

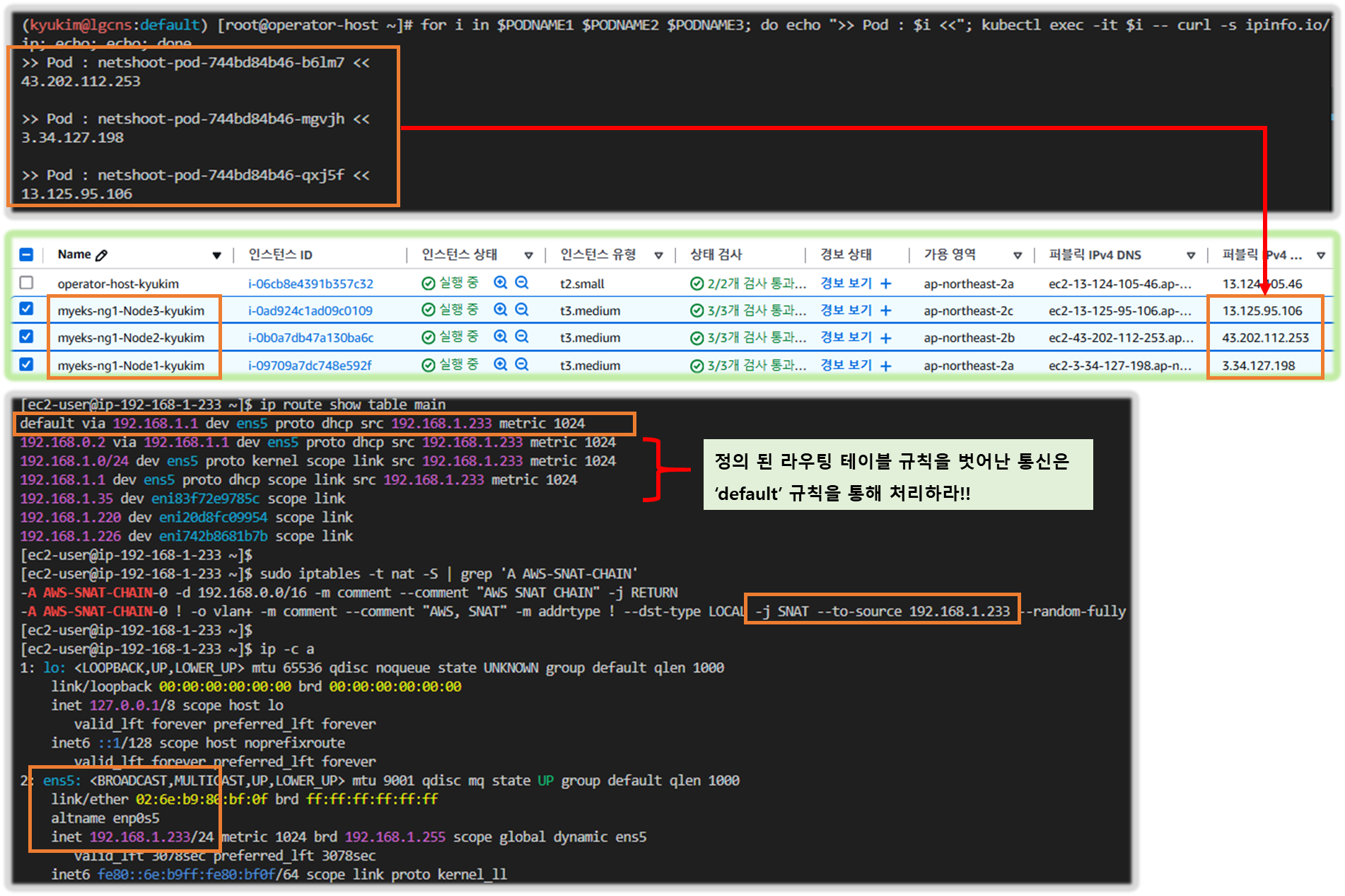

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i curl -s ipinfo.io/ip; echo; echo; done

# 작업용 EC2 : pod-1 Shell 에서 외부 접속 확인 - 공인IP는 어떤 주소인가?

## The right way to check the weather - 링크

for i in $PODNAME1 $PODNAME2 $PODNAME3; do echo ">> Pod : $i <<"; kubectl exec -it $i -- curl -s ipinfo.io/ip; echo; echo; done

kubectl exec -it $PODNAME1 -- curl -s wttr.in/seoul

kubectl exec -it $PODNAME1 -- curl -s wttr.in/seoul?format=3

kubectl exec -it $PODNAME1 -- curl -s wttr.in/Moon

kubectl exec -it $PODNAME1 -- curl -s wttr.in/:help

# 워커 노드 EC2

## 출력된 결과를 보고 어떻게 빠져나가는지 고민해보자!

ip rule

ip route show table main

sudo iptables -L -n -v -t nat

sudo iptables -t nat -S

# 파드가 외부와 통신시에는 아래 처럼 'AWS-SNAT-CHAIN-0' 룰(rule)에 의해서 SNAT 되어서 외부와 통신!

# 참고로 뒤 IP는 eth0(ENI 첫번째)의 IP 주소이다

# --random-fully 동작 - 링크1 링크2

sudo iptables -t nat -S | grep 'A AWS-SNAT-CHAIN'

-A AWS-SNAT-CHAIN-0 ! -d 192.168.0.0/16 -m comment --comment "AWS SNAT CHAIN" -j RETURN

-A AWS-SNAT-CHAIN-0 ! -o vlan+ -m comment --comment "AWS, SNAT" -m addrtype ! --dst-type LOCAL -j SNAT --to-source 192.168.1.251 --random-fully

## 아래 'mark 0x4000/0x4000' 매칭되지 않아서 RETURN 됨!

-A KUBE-POSTROUTING -m mark ! --mark 0x4000/0x4000 -j RETURN

-A KUBE-POSTROUTING -j MARK --set-xmark 0x4000/0x0

-A KUBE-POSTROUTING -m comment --comment "kubernetes service traffic requiring SNAT" -j MASQUERADE --random-fully

...

# 카운트 확인 시 AWS-SNAT-CHAIN-0에 매칭되어, 목적지가 192.168.0.0/16 아니고 외부 빠져나갈때 SNAT 192.168.1.251(EC2 노드1 IP) 변경되어 나간다!

sudo iptables -t filter --zero; sudo iptables -t nat --zero; sudo iptables -t mangle --zero; sudo iptables -t raw --zero

watch -d 'sudo iptables -v --numeric --table nat --list AWS-SNAT-CHAIN-0; echo ; sudo iptables -v --numeric --table nat --list KUBE-POSTROUTING; echo ; sudo iptables -v --numeric --table nat --list POSTROUTING'

# conntrack 확인 : EC2 메타데이터 주소(169.254.169.254) 제외 출력

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo conntrack -L -n |grep -v '169.254.169'; echo; done

conntrack v1.4.5 (conntrack-tools):

icmp 1 28 src=172.30.66.58 dst=8.8.8.8 type=8 code=0 id=34392 src=8.8.8.8 dst=172.30.85.242 type=0 code=0 id=50705 mark=128 use=1

tcp 6 23 TIME_WAIT src=172.30.66.58 dst=34.117.59.81 sport=58144 dport=80 src=34.117.59.81 dst=172.30.85.242 sport=80 dport=44768 [ASSURED] mark=128 use=1[ 실행 결과 - 한 눈에 보기 ]

1) Node 내 POD에서 외부 DNS 주소 호출 시, 최종 Node ens5 의 IP를 타고 NAT 되어 나가는 것을 확인함.

2) conntrack - traffic 로그 확인하기

[ 중요 : 중간 자원정리 하기 !! ]

kubectl delete deploy netshoot-pod

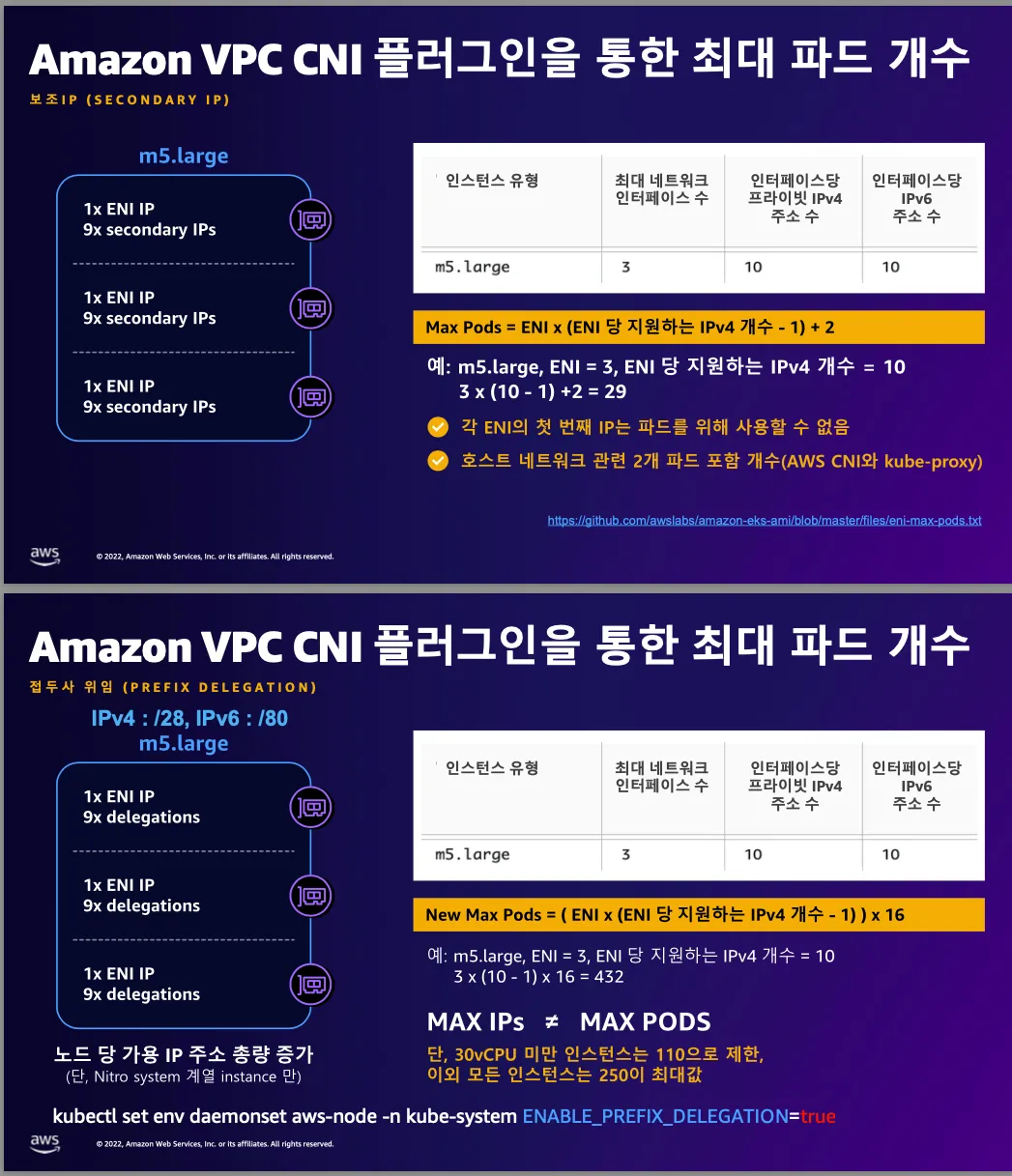

5. 노드에 파드 생성 갯수 제한

5-1. 노드 갯수 산정기준

- Secondary IPv4 addresses : 인스턴스 유형에 최대 ENI 갯수와 할당 가능 IP 수를 조합하여 선정

- IPv4 Prefix Delegation : IPv4 28bit 서브넷(prefix)를 위임하여 할당 가능 IP 수와 인스턴스 유형에 권장하는 최대 갯수로 선정

☞ AWS VPC CNI Custom Networking : 노드와 파드 대역 분리, 파드에 별도 서브넷 부여 후 사용 - Docs

[ More ... ]

- Secondary IPv4 addresses (기본값) : 인스턴스 유형에 최대 ENI 갯수와 할당 가능 IP 수를 조합하여 산정

5-2. 실습

▶ 사전 준비 : kube-ops-view 설치

# kube-ops-view

helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=LoadBalancer --set env.TZ="Asia/Seoul" --namespace kube-system

# kube-ops-view 접속 URL 확인 (1.5 배율)

kubectl get svc -n kube-system kube-ops-view -o jsonpath='{.status.loadBalancer.ingress[0].hostname}' | awk '{ print "KUBE-OPS-VIEW URL = http://"$1":8080/#scale=1.5"}'

▶ 워커 노드의 인스턴스 타입 별 파드 생성 갯수 제한확인

- 인스턴스 타입 별 ENI 최대 갯수와 할당 가능한 최대 IP 갯수에 따라서 파드 배치 갯수가 결정됨

- 단, aws-node 와 kube-proxy 파드는 호스트의 IP를 사용함으로 최대 갯수에서 제외함

☞ 워커 노드의 인스턴스 정보 확인 : t3.medium 사용 시

# t3 타입의 정보(필터) 확인

aws ec2 describe-instance-types --filters Name=instance-type,Values=t3.\* \

--query "InstanceTypes[].{Type: InstanceType, MaxENI: NetworkInfo.MaximumNetworkInterfaces, IPv4addr: NetworkInfo.Ipv4AddressesPerInterface}" \

--output table

--------------------------------------

| DescribeInstanceTypes |

+----------+----------+--------------+

| IPv4addr | MaxENI | Type |

+----------+----------+--------------+

| 15 | 4 | t3.2xlarge |

| 6 | 3 | t3.medium |

| 12 | 3 | t3.large |

| 15 | 4 | t3.xlarge |

| 2 | 2 | t3.micro |

| 2 | 2 | t3.nano |

| 4 | 3 | t3.small |

+----------+----------+--------------+

# c5 타입의 정보(필터) 확인

aws ec2 describe-instance-types --filters Name=instance-type,Values=c5\*.\* \

--query "InstanceTypes[].{Type: InstanceType, MaxENI: NetworkInfo.MaximumNetworkInterfaces, IPv4addr: NetworkInfo.Ipv4AddressesPerInterface}" \

--output table

# 파드 사용 가능 계산 예시 : aws-node 와 kube-proxy 파드는 host-networking 사용으로 IP 2개 남음

((MaxENI * (IPv4addr-1)) + 2)

t3.medium 경우 : ((3 * (6 - 1) + 2 ) = 17개 >> aws-node 와 kube-proxy 2개 제외하면 15개

# 워커노드 상세 정보 확인 : 노드 상세 정보의 Allocatable 에 pods 에 17개 정보 확인

kubectl describe node | grep Allocatable: -A6

Allocatable:

cpu: 1930m

ephemeral-storage: 27905944324

hugepages-1Gi: 0

hugepages-2Mi: 0

memory: 3388360Ki

pods: 17

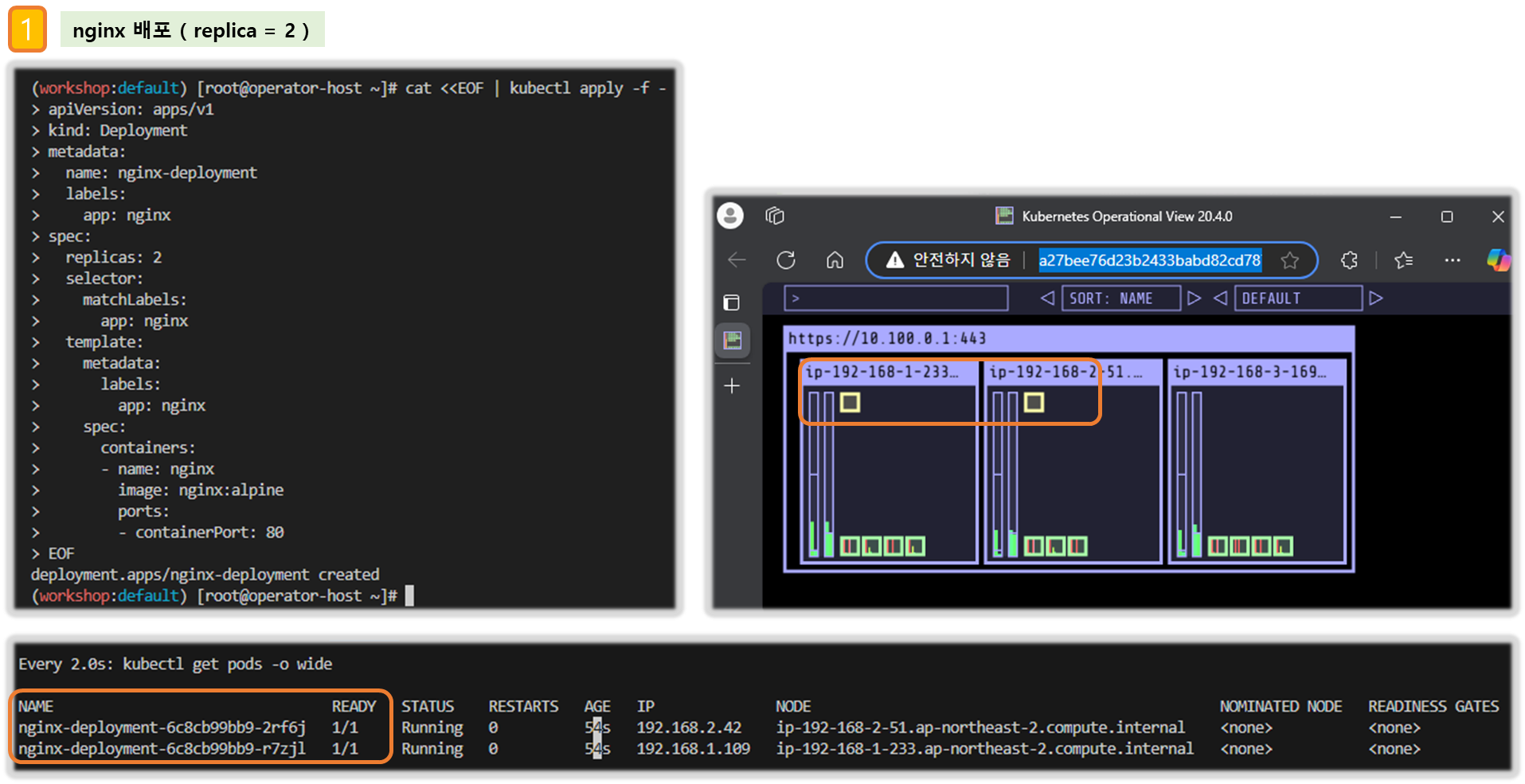

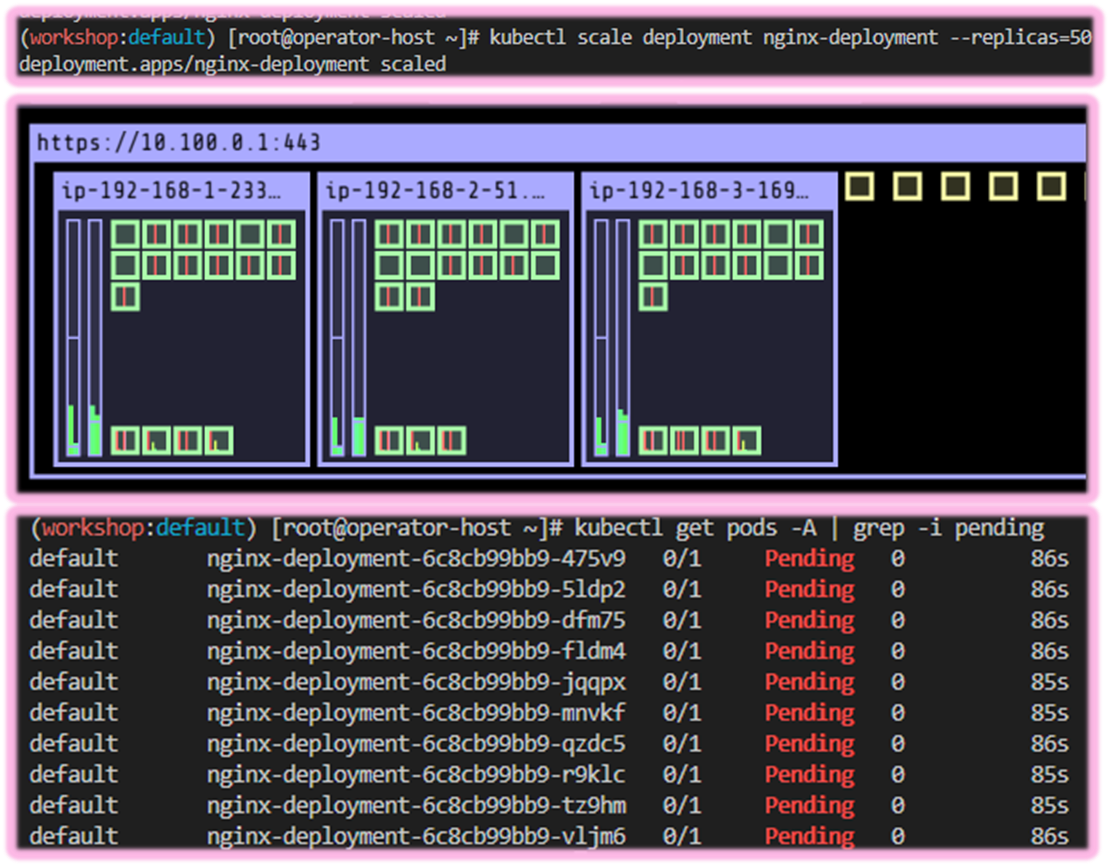

▶ 최대 파드 생성확인 하기

# 워커 노드 3대 EC2 - 모니터링

while true; do ip -br -c addr show && echo "--------------" ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; done

# 터미널1

watch -d 'kubectl get pods -o wide'

# 터미널2

## 디플로이먼트 생성

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

labels:

app: nginx

spec:

replicas: 2

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:alpine

ports:

- containerPort: 80

EOF

# 파드 확인

kubectl get pod -o wide

kubectl get pod -o=custom-columns=NAME:.metadata.name,IP:.status.podIP

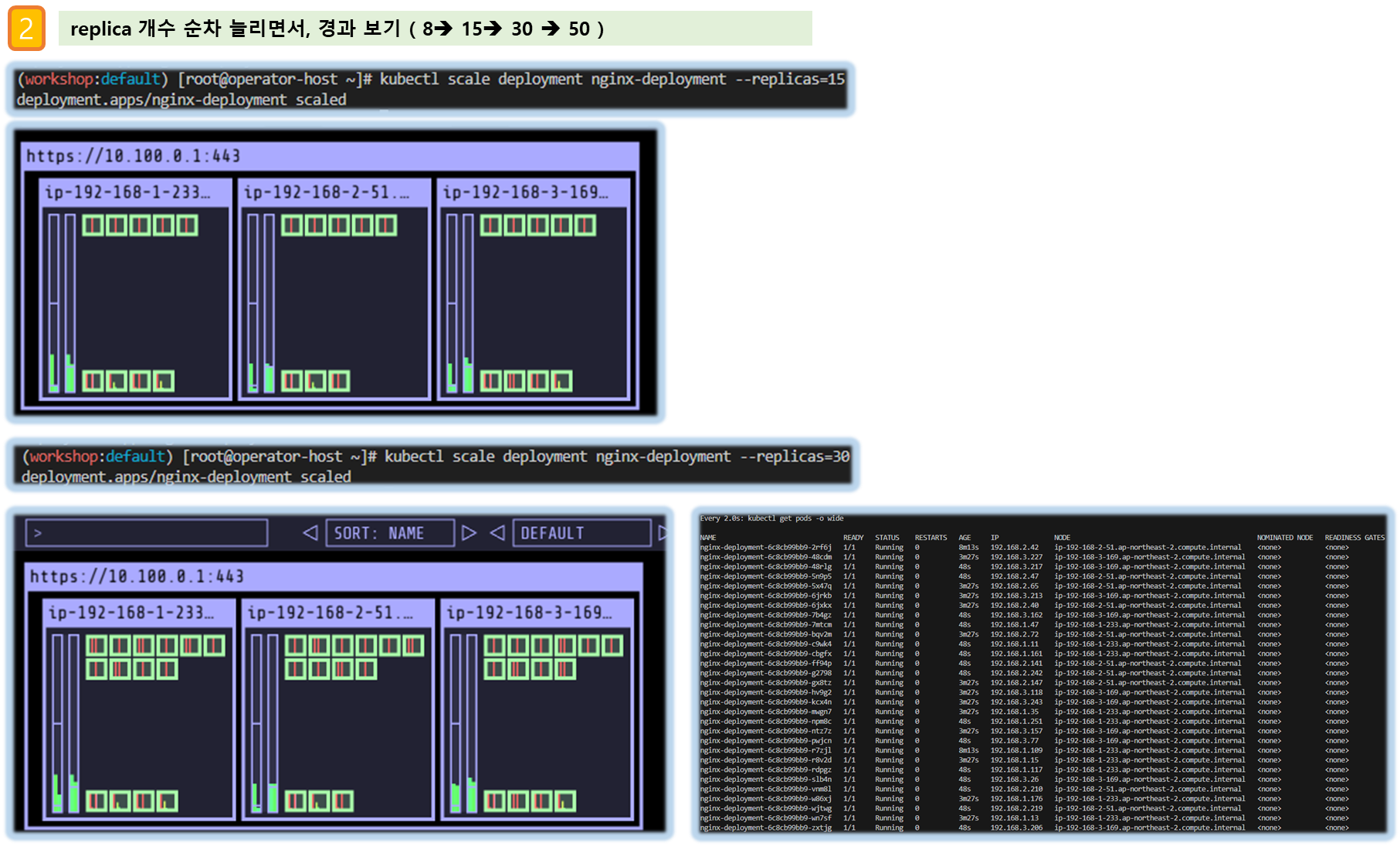

# 파드 증가 테스트 >> 파드 정상 생성 확인, 워커 노드에서 eth, eni 갯수 확인

kubectl scale deployment nginx-deployment --replicas=8

# 파드 증가 테스트 >> 파드 정상 생성 확인, 워커 노드에서 eth, eni 갯수 확인 >> 어떤일이 벌어졌는가?

kubectl scale deployment nginx-deployment --replicas=15

# 파드 증가 테스트 >> 파드 정상 생성 확인, 워커 노드에서 eth, eni 갯수 확인 >> 어떤일이 벌어졌는가?

kubectl scale deployment nginx-deployment --replicas=30

# 파드 증가 테스트 >> 파드 정상 생성 확인, 워커 노드에서 eth, eni 갯수 확인 >> 어떤일이 벌어졌는가?

kubectl scale deployment nginx-deployment --replicas=50

# 파드 생성 실패!

kubectl get pods | grep Pending

nginx-deployment-7fb7fd49b4-d4bk9 0/1 Pending 0 3m37s

nginx-deployment-7fb7fd49b4-qpqbm 0/1 Pending 0 3m37s

...

kubectl describe pod <Pending 파드> | grep Events: -A5

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Warning FailedScheduling 45s default-scheduler 0/3 nodes are available: 1 node(s) had untolerated taint {node-role.kubernetes.io/control-plane: }, 2 Too many pods. preemption: 0/3 nodes are available: 1 Preemption is not helpful for scheduling, 2 No preemption victims found for incoming pod.

# 디플로이먼트 삭제

kubectl delete deploy nginx-deployment[ 실행 결과 - 한 눈에 보기 ]

☞ 노드에 배포할 수 있는 파드의 최대 갯수는 지원하는 IP 주소가 주요 요인입니다. 다만 vCPU 30개 미만 EC2 인스턴스 유형은 (k8s 확장 권고값에 따라) 노드에 최대 파드 110개 제한이 되고, vCPU 30이상 EC2 인스턴스 유형은 (AWS 내부 테스트 권고값에 따라) 노드에 최대 파드 250개 제한을 권고합니다.

https://docs.aws.amazon.com/ko_kr/eks/latest/userguide/choosing-instance-type.html https://docs.aws.amazon.com/ko_kr/eks/latest/userguide/cni-increase-ip-addresses-procedure.html https://aws.amazon.com/ko/blogs/containers/amazon-vpc-cni-increases-pods-per-node-limits/

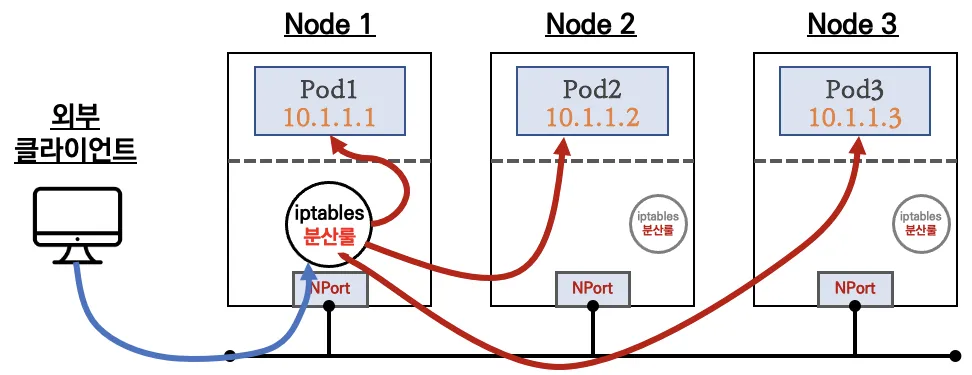

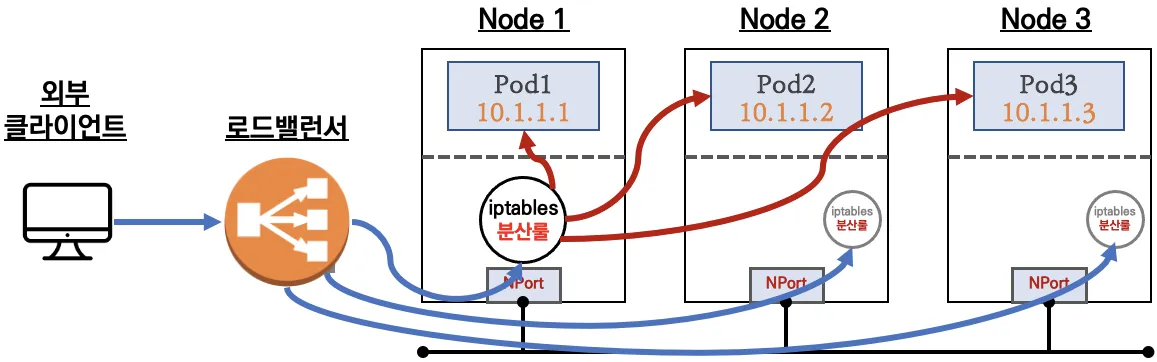

6. Service & AWS LoadBalancer Controller

[ 요약 ]

☞ 클러스터 서비스는 가용성 측면에서 서비스 부하에 따라 정해진 범주내에서 노드와 POD 가 늘었다 줄었다 하는 가용적인 구조이므로, 외부에서 고정 진입점이 필요하다. 이때 사용하는 개념이 "서비스" 이다.

서비스의 안정적 제공을 위해 부하분산이 필요하며, 이를 제공하고자 LoadBalancer type의 컨트롤러가 도입되었다.

[ K8s 서비스 소개 자료 ]

kube-proxy 모드 - iptables, ipvs, nftables, eBPF - 링크 , Finda , 커피고래

[ Blog ]

Kans3 학습자료 : 1) 서비스 (Cluster IP, Node IP), 2) LoadBalancer

[ 서비스 종류 ]

1) 클러스터 IP

- 클러스터 내부 통신 only

2) Node Port

- 외부 사용자가 고정 IP/port를 이용하여 접근가능 하며, 다른 노드에 있는 pod 서비스 접근을 위해서 내부 iptalbes를 이용하여 찾아감 (비효율적)

3) LoadBalancer 타입

- 외부 사용자는 로드밸런서 고정 IP/Port를 접속하며, 클러스터 내부 서비스 POD로의 Traffic 전달은 로드밸런서 내부 IPtable 규칙에 따라 전달됨

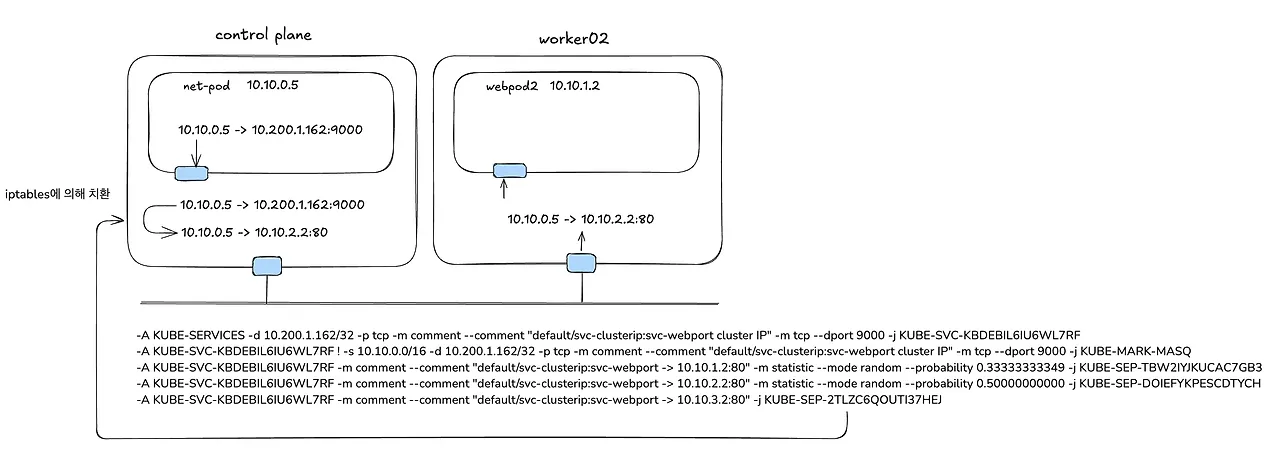

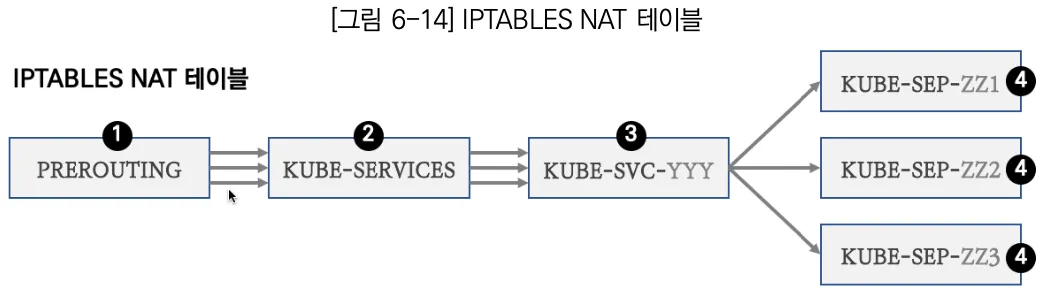

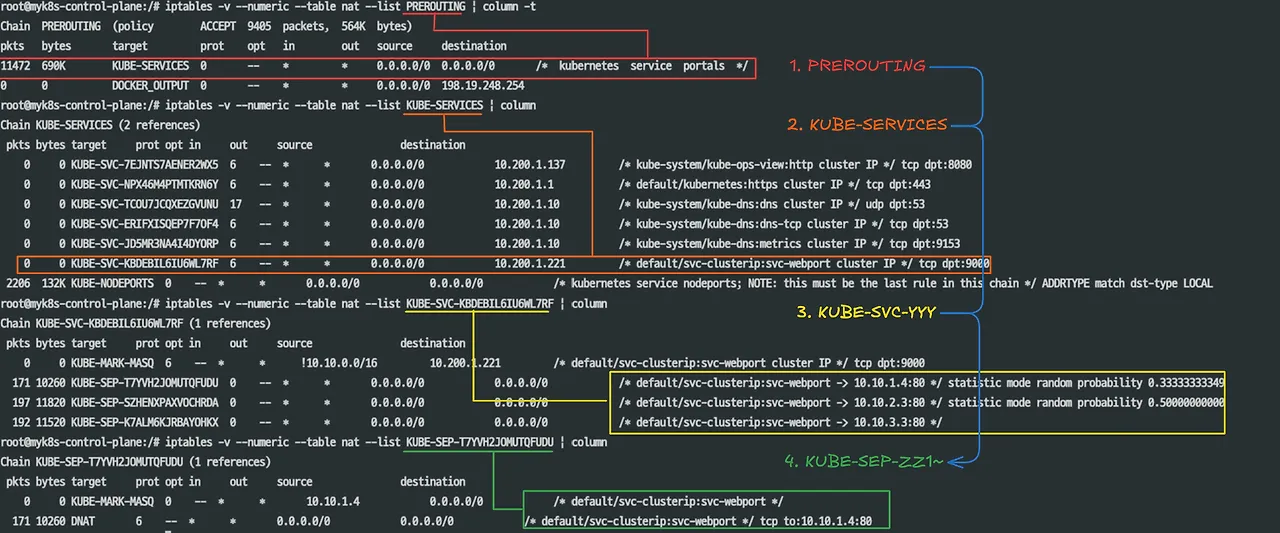

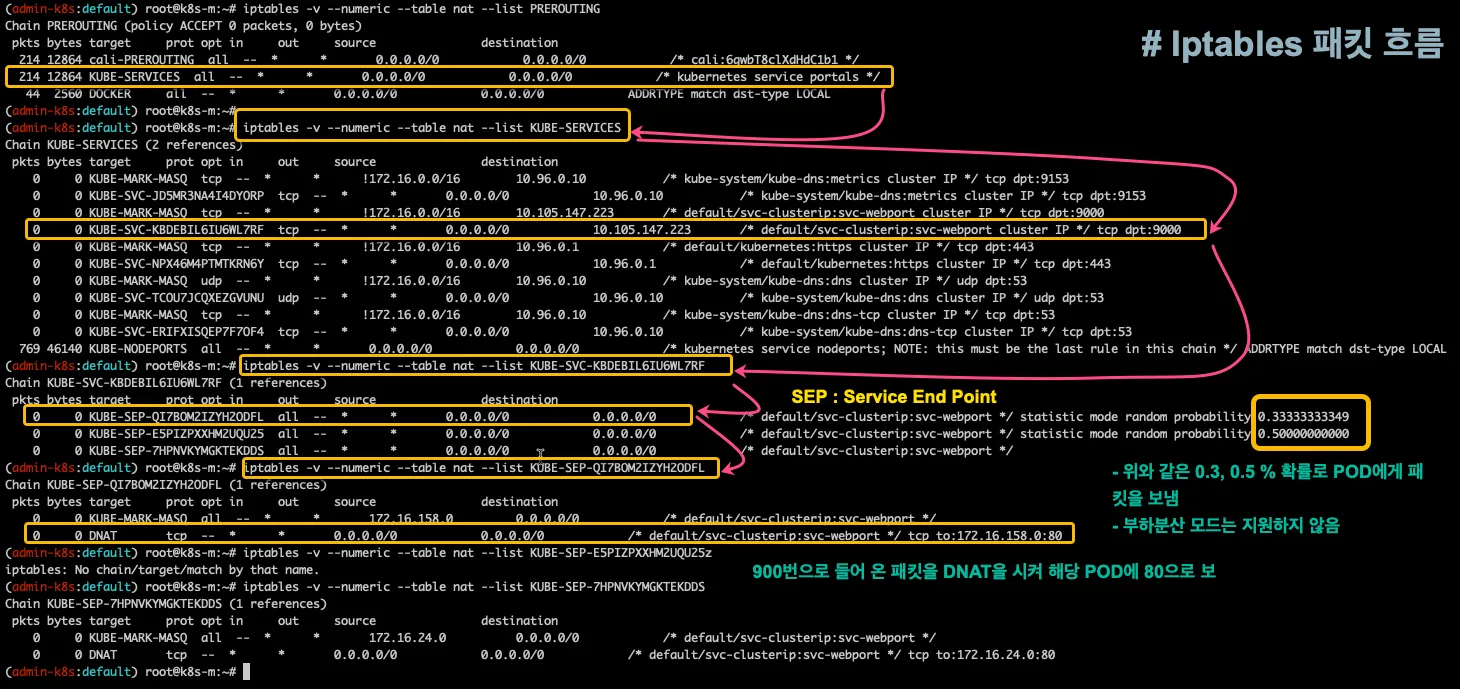

[ IPtables 정책 적용 순서 ]

☞ PREROUTING → KUBE-SERVICES → KUBE-SVC-### → KUBE-SEP-#<파드1> , KUBE-SEP-#<파드2> , KUBE-SEP-#<파드3>

▶ 결론 : 내부에서 클러스터 IP로 접속 시, PREROUTE(nat) 에서 DNAT(3개 파드) 되고, POSTROUTE(nat) 에서 SNAT 되지 않고 나간다!

# 컨트롤플레인에서 확인 : 너무 복잡해서 리턴 트래픽에 대해서는 상세히 분석 정리하지 않습니다.

docker exec -it myk8s-control-plane bash

----------------------------------------

# iptables 확인

iptables -t filter -S

iptables -t nat -S

iptables -t nat -S | wc -l

iptables -t mangle -S

# iptables 상세 확인 - 매칭 패킷 카운트, 인터페이스 정보 등 포함

iptables -nvL -t filter

iptables -nvL -t nat

iptables -nvL -t mangle

# rule 갯수 확인

iptables -nvL -t filter | wc -l

iptables -nvL -t nat | wc -l

# 규칙 패킷 바이트 카운트 초기화

iptables -t filter --zero; iptables -t nat --zero; iptables -t mangle --zero

# 정책 확인 : 아래 정책 내용은 핵심적인 룰(rule)만 표시했습니다!

iptables -t nat -nvL

iptables -v --numeric --table nat --list PREROUTING | column -t

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

778 46758 KUBE-SERVICES all -- * * 0.0.0.0/0 0.0.0.0/0 /* kubernetes service portals */

iptables -v --numeric --table nat --list KUBE-SERVICES | column

# 바로 아래 룰(rule)에 의해서 서비스(ClusterIP)를 인지하고 처리를 합니다

Chain KUBE-SERVICES (2 references)

pkts bytes target prot opt in out source destination

92 5520 KUBE-SVC-KBDEBIL6IU6WL7RF tcp -- * * 0.0.0.0/0 10.105.114.73 /* default/svc-clusterip:svc-webport cluster IP */ tcp dpt:9000

iptables -v --numeric --table nat --list KUBE-SVC-KBDEBIL6IU6WL7RF | column

watch -d 'iptables -v --numeric --table nat --list KUBE-SVC-KBDEBIL6IU6WL7RF'

SVC1=$(kubectl get svc svc-clusterip -o jsonpath={.spec.clusterIP})

kubectl exec -it net-pod -- zsh -c "for i in {1..100}; do curl -s $SVC1:9000 | grep Hostname; sleep 1; done"

# SVC-### 에서 랜덤 확률(대략 33%)로 SEP(Service EndPoint)인 각각 파드 IP로 DNAT 됩니다!

## 첫번째 룰에 일치 확률은 33% 이고, 매칭되지 않을 경우 아래 2개 남을때는 룰 일치 확률은 50%가 됩니다. 이것도 매칭되지 않으면 마지막 룰로 100% 일치됩니다

Chain KUBE-SVC-KBDEBIL6IU6WL7RF (1 references)

pkts bytes target prot opt in out source destination

38 2280 KUBE-SEP-6TM74ZFOWZXXYQW6 all -- * * 0.0.0.0/0 0.0.0.0/0 /* default/svc-clusterip:svc-webport */ statistic mode random probability 0.33333333349

29 1740 KUBE-SEP-354QUAZJTL5AR6RR all -- * * 0.0.0.0/0 0.0.0.0/0 /* default/svc-clusterip:svc-webport */ statistic mode random probability 0.50000000000

25 1500 KUBE-SEP-PY4VJNJPBUZ3ATEL all -- * * 0.0.0.0/0 0.0.0.0/0 /* default/svc-clusterip:svc-webport */

iptables -v --numeric --table nat --list KUBE-SEP-<각자 값 입력>

Chain KUBE-SEP-6TM74ZFOWZXXYQW6 (1 references)

pkts bytes target prot opt in out source destination

38 2280 DNAT tcp -- * * 0.0.0.0/0 0.0.0.0/0 /* default/svc-clusterip:svc-webport */ tcp to:172.16.158.3:80

iptables -v --numeric --table nat --list KUBE-SEP-354QUAZJTL5AR6RR | column -t

Chain KUBE-SEP-6TM74ZFOWZXXYQW6 (1 references)

pkts bytes target prot opt in out source destination

29 1500 DNAT tcp -- * * 0.0.0.0/0 0.0.0.0/0 /* default/svc-clusterip:svc-webport */ tcp to:172.16.184.3:80

iptables -v --numeric --table nat --list KUBE-SEP-PY4VJNJPBUZ3ATEL | column -t

Chain KUBE-SEP-6TM74ZFOWZXXYQW6 (1 references)

pkts bytes target prot opt in out source destination

25 1740 DNAT tcp -- * * 0.0.0.0/0 0.0.0.0/0 /* default/svc-clusterip:svc-webport */ tcp to:172.16.34.3:80

iptables -t nat --zero

iptables -v --numeric --table nat --list POSTROUTING | column; echo ; iptables -v --numeric --table nat --list KUBE-POSTROUTING | column

watch -d 'iptables -v --numeric --table nat --list POSTROUTING; echo ; iptables -v --numeric --table nat --list KUBE-POSTROUTING'

# POSTROUTE(nat) : 0x4000(2진수로 0100 0000 0000 0000, 10진수 16384) 마킹 되어 있지 않으니 RETURN 되고 그냥 빠져나가서 SNAT 되지 않는다!

Chain KUBE-POSTROUTING (1 references)

pkts bytes target prot opt in out source destination

572 35232 RETURN all -- * * 0.0.0.0/0 0.0.0.0/0 mark match ! 0x4000/0x4000

0 0 MARK all -- * * 0.0.0.0/0 0.0.0.0/0 MARK xor 0x4000

0 0 MASQUERADE all -- * * 0.0.0.0/0 0.0.0.0/0 /* kubernetes service traffic requiring SNAT */ random-fully

iptables -t nat -S | grep KUBE-POSTROUTING

-A KUBE-POSTROUTING -m mark ! --mark 0x4000/0x4000 -j RETURN

-A KUBE-POSTROUTING -j MARK --set-xmark 0x4000/0x0

-A KUBE-POSTROUTING -m comment --comment "kubernetes service traffic requiring SNAT" -j MASQUERADE --random-fully

...

exit

----------------------------------------

# 위 서비스 생성 시 kube-proxy 에 의해서 iptables 규칙이 모든 노드에 추가됨을 한번 더 확이

docker exec -it myk8s-control-plane iptables -v --numeric --table nat --list KUBE-SVC-KBDEBIL6IU6WL7RF

...

for i in control-plane worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i iptables -v --numeric --table nat --list KUBE-SVC-KBDEBIL6IU6WL7RF; echo; done

...[ NLB 모드 정리 ]

1. 인스턴스 유형 : 노드에 NodePort로 전달

- externalTrafficPolicy : ClusterIP ⇒ 2번 분산 및 SNAT으로 Client IP 확인 불가능 ← LoadBalancer 타입 (기본 모드) 동작

- externalTrafficPolicy : Local ⇒ 1번 분산 및 ClientIP 유지, 워커 노드의 iptables 사용함

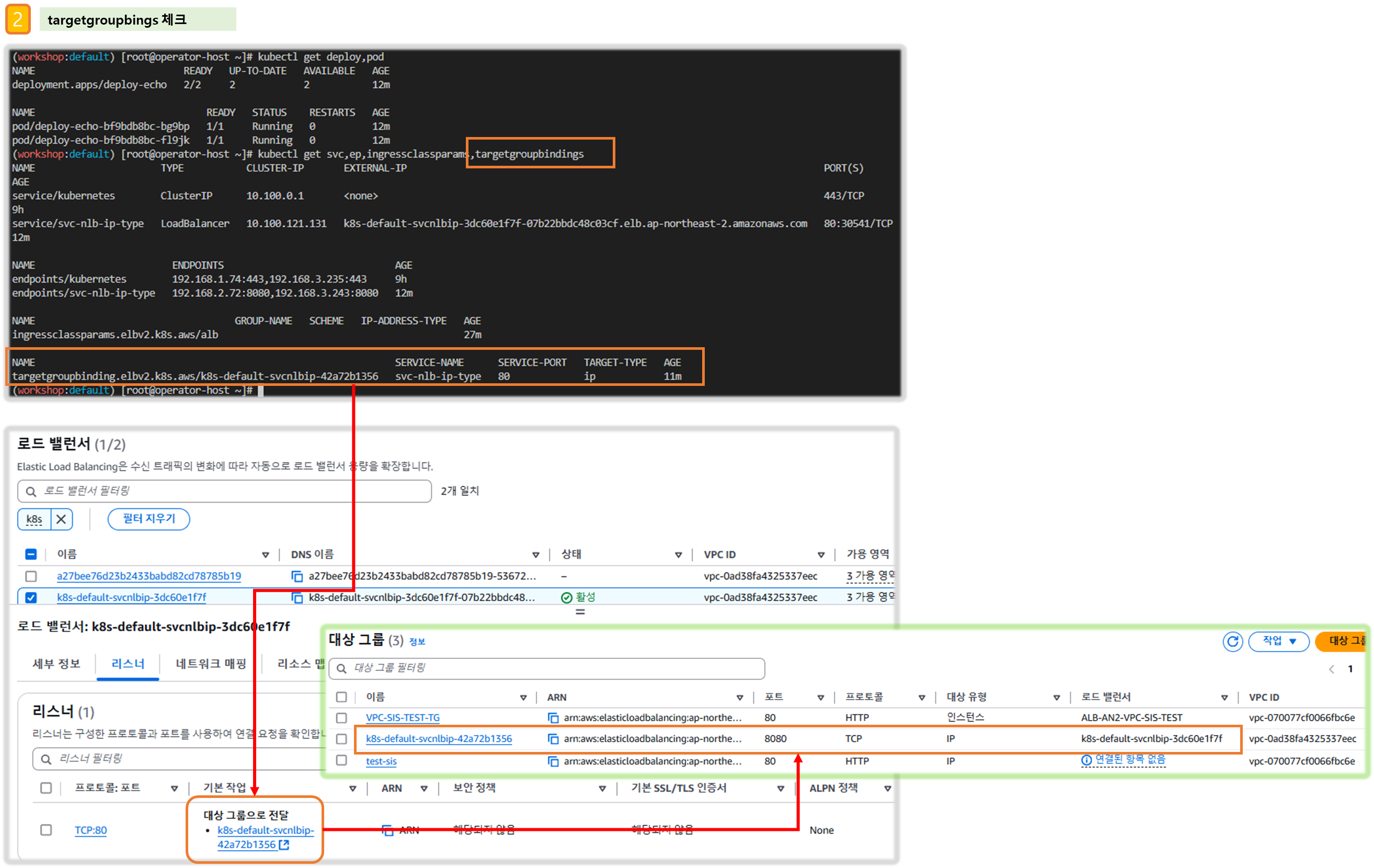

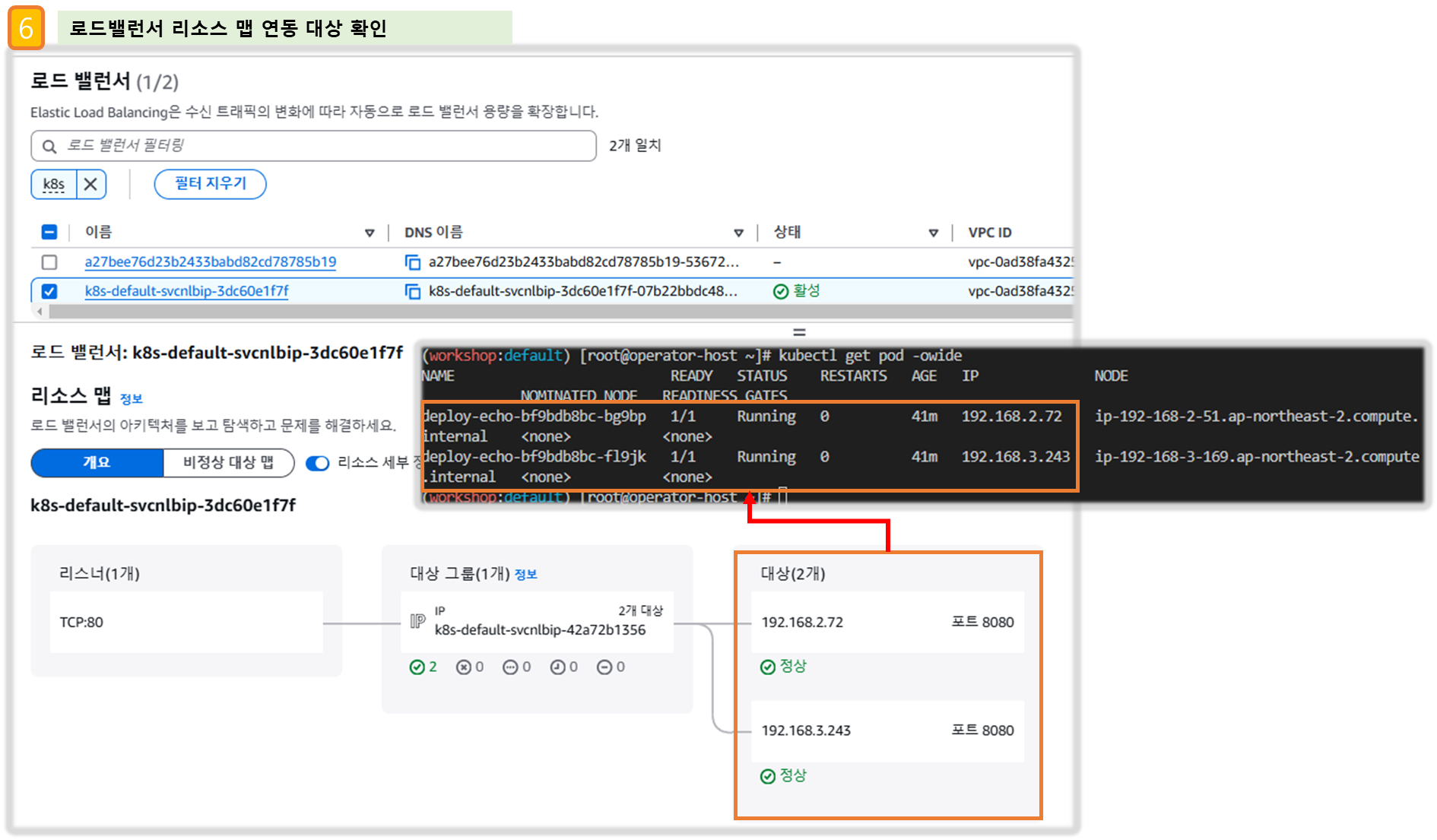

2. IP 유형 ⇒ 반드시 AWS LoadBalancer 컨트롤러 파드 및 정책 설정이 필요함!

- Proxy Protocol v2 비활성화 ⇒ NLB에서 바로 파드로 인입, 단 ClientIP가 NLB로 SNAT 되어 Client IP 확인 불가능

- Proxy Protocol v2 활성화 ⇒ NLB에서 바로 파드로 인입 및 ClientIP 확인 가능(→ 단 PPv2 를 애플리케이션이 인지할 수 있게 설정 필요)

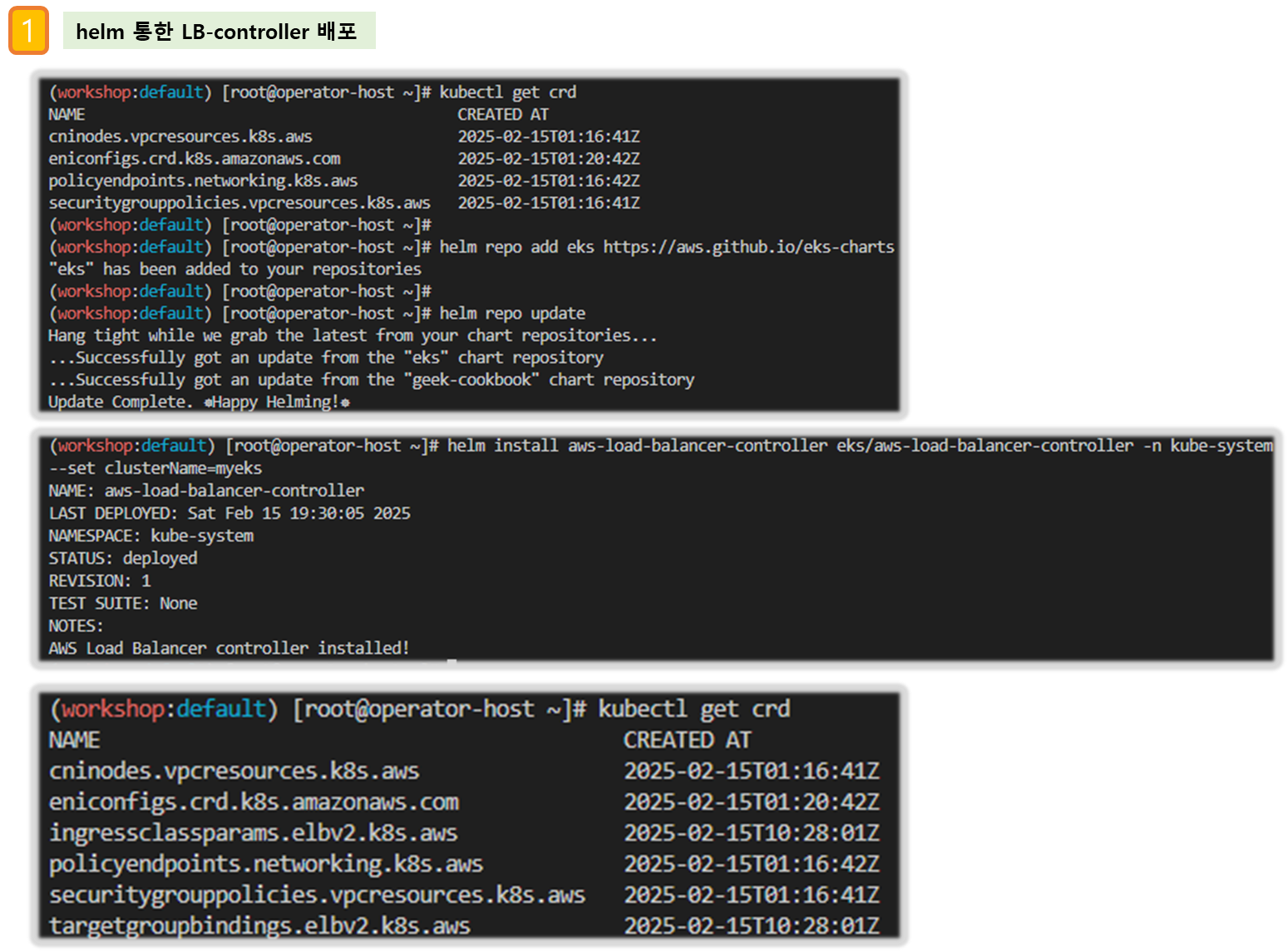

▶ AWS LoadBalancer Controller 배포 - Link

# 설치 전 CRD 확인

kubectl get crd

# Helm Chart 설치

helm repo add eks https://aws.github.io/eks-charts

helm repo update

helm install aws-load-balancer-controller eks/aws-load-balancer-controller -n kube-system --set clusterName=$CLUSTER_NAME

## 설치 확인

kubectl get crd

kubectl explain ingressclassparams.elbv2.k8s.aws

kubectl explain targetgroupbindings.elbv2.k8s.aws

kubectl get deployment -n kube-system aws-load-balancer-controller

kubectl describe deploy -n kube-system aws-load-balancer-controller

kubectl describe deploy -n kube-system aws-load-balancer-controller | grep 'Service Account'

Service Account: aws-load-balancer-controller

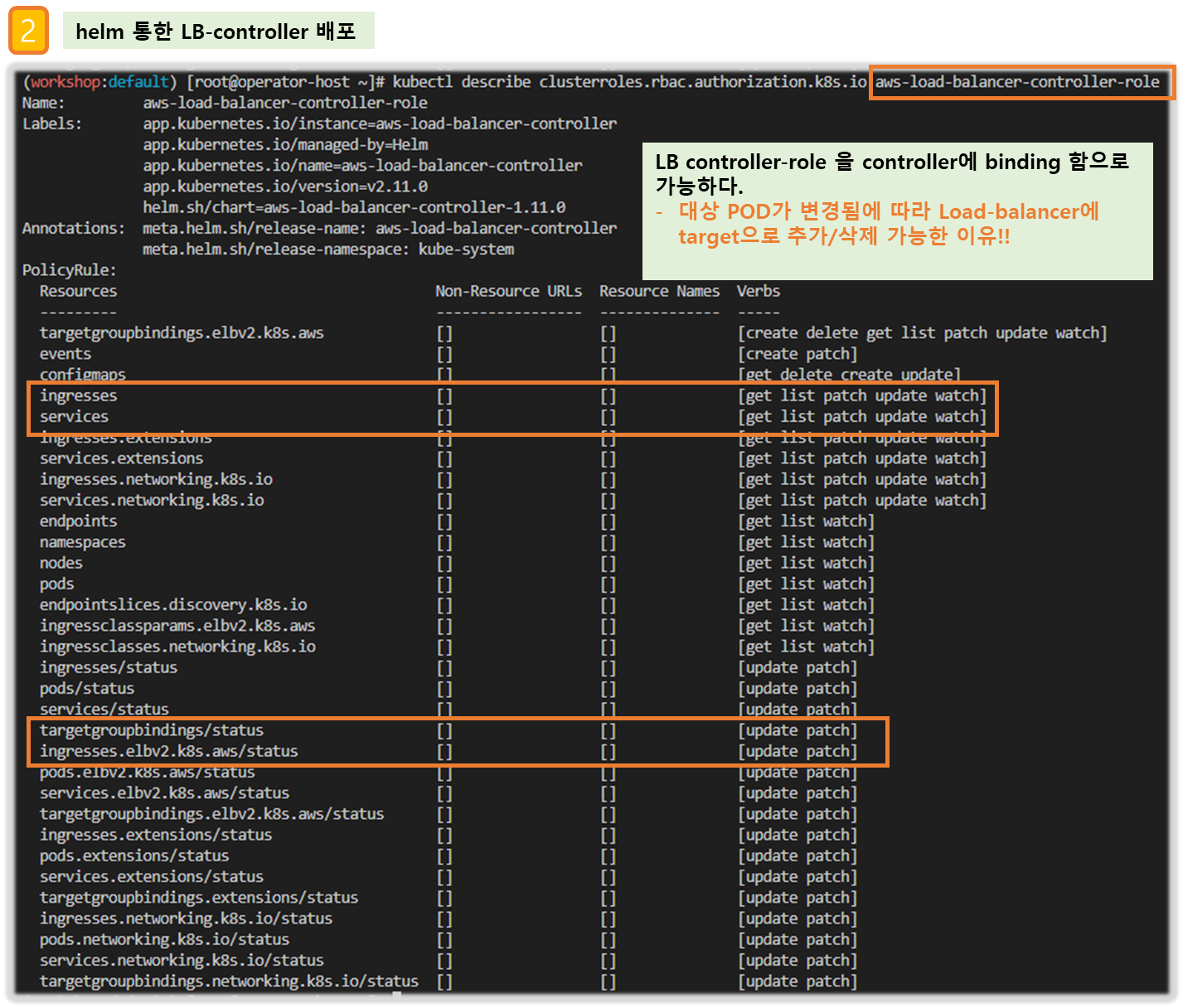

# 클러스터롤, 롤 확인

kubectl describe clusterrolebindings.rbac.authorization.k8s.io aws-load-balancer-controller-rolebinding

kubectl describe clusterroles.rbac.authorization.k8s.io aws-load-balancer-controller-role

...

PolicyRule:

Resources Non-Resource URLs Resource Names Verbs

--------- ----------------- -------------- -----

targetgroupbindings.elbv2.k8s.aws [] [] [create delete get list patch update watch]

events [] [] [create patch]

ingresses [] [] [get list patch update watch]

services [] [] [get list patch update watch]

ingresses.extensions [] [] [get list patch update watch]

services.extensions [] [] [get list patch update watch]

ingresses.networking.k8s.io [] [] [get list patch update watch]

services.networking.k8s.io [] [] [get list patch update watch]

endpoints [] [] [get list watch]

namespaces [] [] [get list watch]

nodes [] [] [get list watch]

pods [] [] [get list watch]

endpointslices.discovery.k8s.io [] [] [get list watch]

ingressclassparams.elbv2.k8s.aws [] [] [get list watch]

ingressclasses.networking.k8s.io [] [] [get list watch]

ingresses/status [] [] [update patch]

pods/status [] [] [update patch]

services/status [] [] [update patch]

targetgroupbindings/status [] [] [update patch]

ingresses.elbv2.k8s.aws/status [] [] [update patch]

pods.elbv2.k8s.aws/status [] [] [update patch]

services.elbv2.k8s.aws/status [] [] [update patch]

targetgroupbindings.elbv2.k8s.aws/status [] [] [update patch]

ingresses.extensions/status [] [] [update patch]

pods.extensions/status [] [] [update patch]

services.extensions/status [] [] [update patch]

targetgroupbindings.extensions/status [] [] [update patch]

ingresses.networking.k8s.io/status [] [] [update patch]

pods.networking.k8s.io/status [] [] [update patch]

services.networking.k8s.io/status [] [] [update patch]

targetgroupbindings.networking.k8s.io/status [] [] [update patch]

▶ 서비스/파드 배포 테스트 with NLB - Docs , NLB

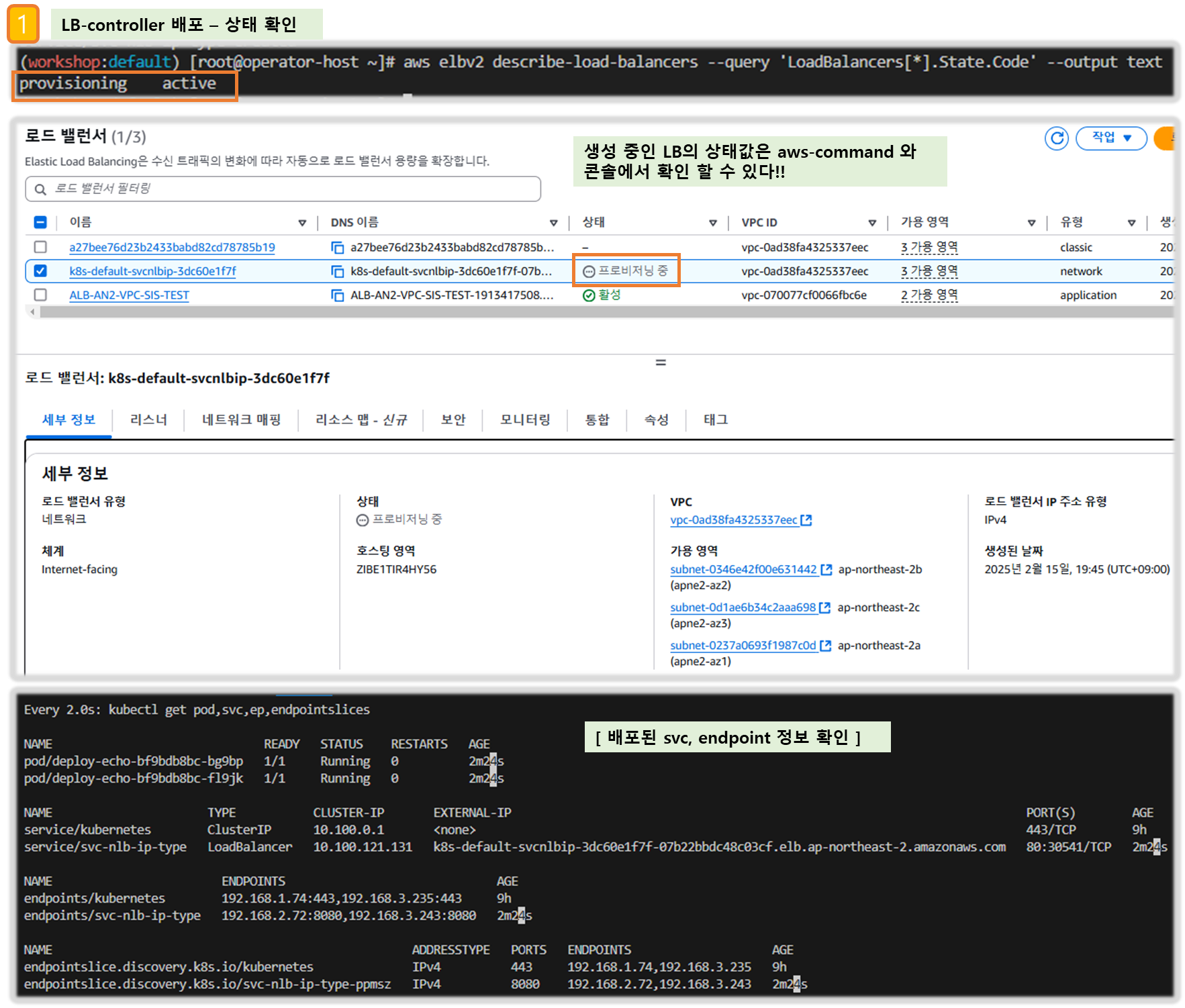

☞ 해당 실습을 통해 서비스 - LB controller 를 배포 후, POD 접속 시도로 부하분산 여부를 확인 할 수 있다.

# 모니터링

watch -d kubectl get pod,svc,ep,endpointslices

# 디플로이먼트 & 서비스 생성

cat << EOF > echo-service-nlb.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: deploy-echo

spec:

replicas: 2

selector:

matchLabels:

app: deploy-websrv

template:

metadata:

labels:

app: deploy-websrv

spec:

terminationGracePeriodSeconds: 0

containers:

- name: aews-websrv

image: k8s.gcr.io/echoserver:1.5

ports:

- containerPort: 8080

---

apiVersion: v1

kind: Service

metadata:

name: svc-nlb-ip-type

annotations:

service.beta.kubernetes.io/aws-load-balancer-nlb-target-type: ip

service.beta.kubernetes.io/aws-load-balancer-scheme: internet-facing

service.beta.kubernetes.io/aws-load-balancer-healthcheck-port: "8080"

service.beta.kubernetes.io/aws-load-balancer-cross-zone-load-balancing-enabled: "true"

spec:

ports:

- port: 80

targetPort: 8080

protocol: TCP

type: LoadBalancer

loadBalancerClass: service.k8s.aws/nlb

selector:

app: deploy-websrv

EOF

kubectl apply -f echo-service-nlb.yaml

# 확인

aws elbv2 describe-load-balancers --query 'LoadBalancers[*].State.Code' --output text

kubectl get deploy,pod

kubectl get svc,ep,ingressclassparams,targetgroupbindings

kubectl get targetgroupbindings -o json | jq

# AWS 관리콘솔에서 NLB 정보 확인

# 빠른 실습을 위해서 등록 취소 지연(드레이닝 간격) 수정 : 기본값 300초

echo-service-nlb.yaml 파일 IDE(VS code)에서 수정

..

apiVersion: v1

kind: Service

metadata:

name: svc-nlb-ip-type

annotations:

service.beta.kubernetes.io/aws-load-balancer-nlb-target-type: ip

service.beta.kubernetes.io/aws-load-balancer-scheme: internet-facing

service.beta.kubernetes.io/aws-load-balancer-healthcheck-port: "8080"

service.beta.kubernetes.io/aws-load-balancer-cross-zone-load-balancing-enabled: "true"

service.beta.kubernetes.io/aws-load-balancer-target-group-attributes: deregistration_delay.timeout_seconds=60

...

kubectl apply -f echo-service-nlb.yaml

# AWS ELB(NLB) 정보 확인

aws elbv2 describe-load-balancers | jq

aws elbv2 describe-load-balancers --query 'LoadBalancers[*].State.Code' --output text

ALB_ARN=$(aws elbv2 describe-load-balancers --query 'LoadBalancers[?contains(LoadBalancerName, `k8s-default-svcnlbip`) == `true`].LoadBalancerArn' | jq -r '.[0]')

aws elbv2 describe-target-groups --load-balancer-arn $ALB_ARN | jq

TARGET_GROUP_ARN=$(aws elbv2 describe-target-groups --load-balancer-arn $ALB_ARN | jq -r '.TargetGroups[0].TargetGroupArn')

aws elbv2 describe-target-health --target-group-arn $TARGET_GROUP_ARN | jq

{

"TargetHealthDescriptions": [

{

"Target": {

"Id": "192.168.2.153",

"Port": 8080,

"AvailabilityZone": "ap-northeast-2b"

},

"HealthCheckPort": "8080",

"TargetHealth": {

"State": "initial",

"Reason": "Elb.RegistrationInProgress",

"Description": "Target registration is in progress"

}

},

...

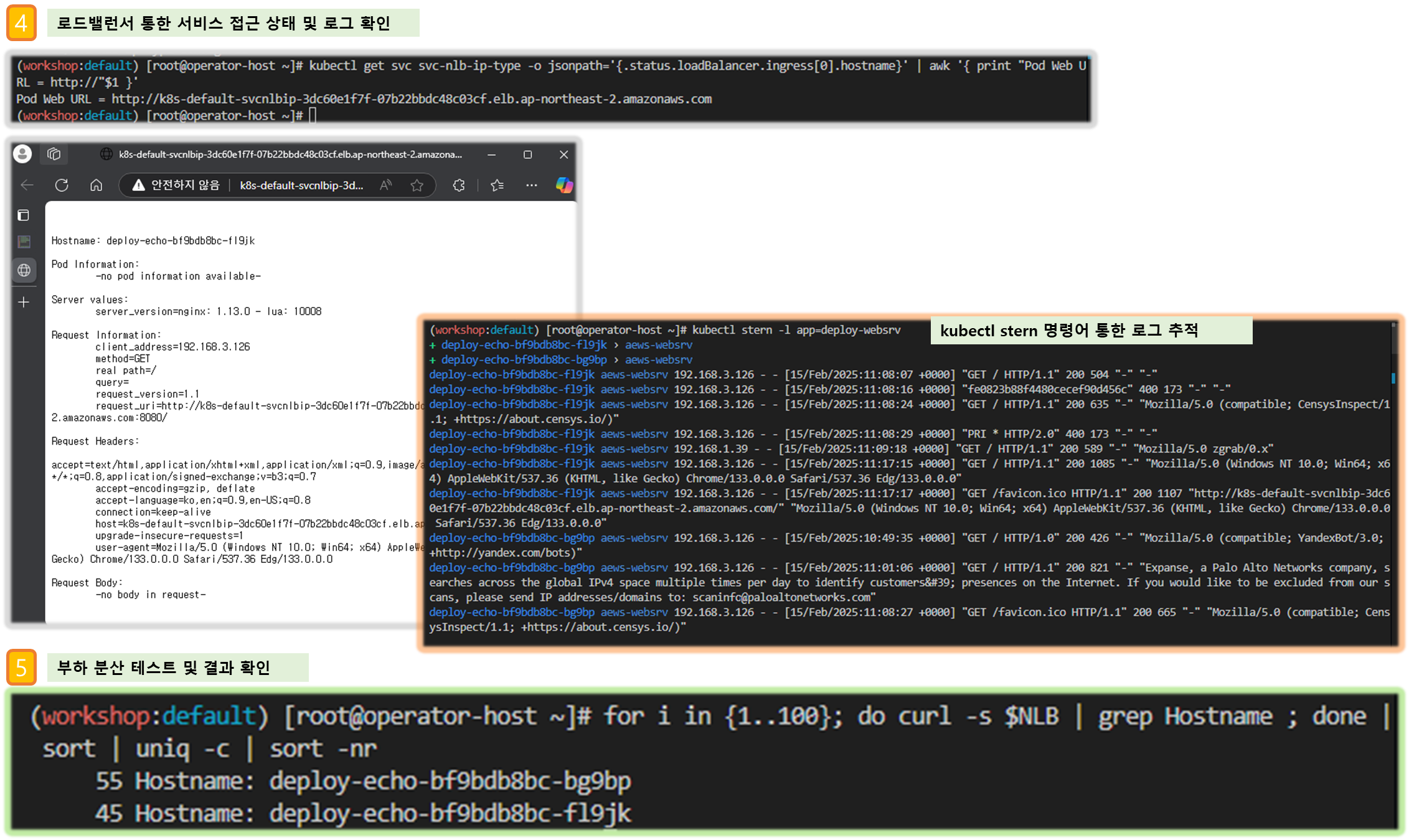

# 웹 접속 주소 확인

kubectl get svc svc-nlb-ip-type -o jsonpath='{.status.loadBalancer.ingress[0].hostname}' | awk '{ print "Pod Web URL = http://"$1 }'

# 파드 로깅 모니터링

kubectl logs -l app=deploy-websrv -f

kubectl stern -l app=deploy-websrv

# 분산 접속 확인

NLB=$(kubectl get svc svc-nlb-ip-type -o jsonpath='{.status.loadBalancer.ingress[0].hostname}')

curl -s $NLB

for i in {1..100}; do curl -s $NLB | grep Hostname ; done | sort | uniq -c | sort -nr

52 Hostname: deploy-echo-55456fc798-2w65p

48 Hostname: deploy-echo-55456fc798-cxl7z

# 지속적인 접속 시도 : 아래 상세 동작 확인 시 유용(패킷 덤프 등)

while true; do curl -s --connect-timeout 1 $NLB | egrep 'Hostname|client_address'; echo "----------" ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; done

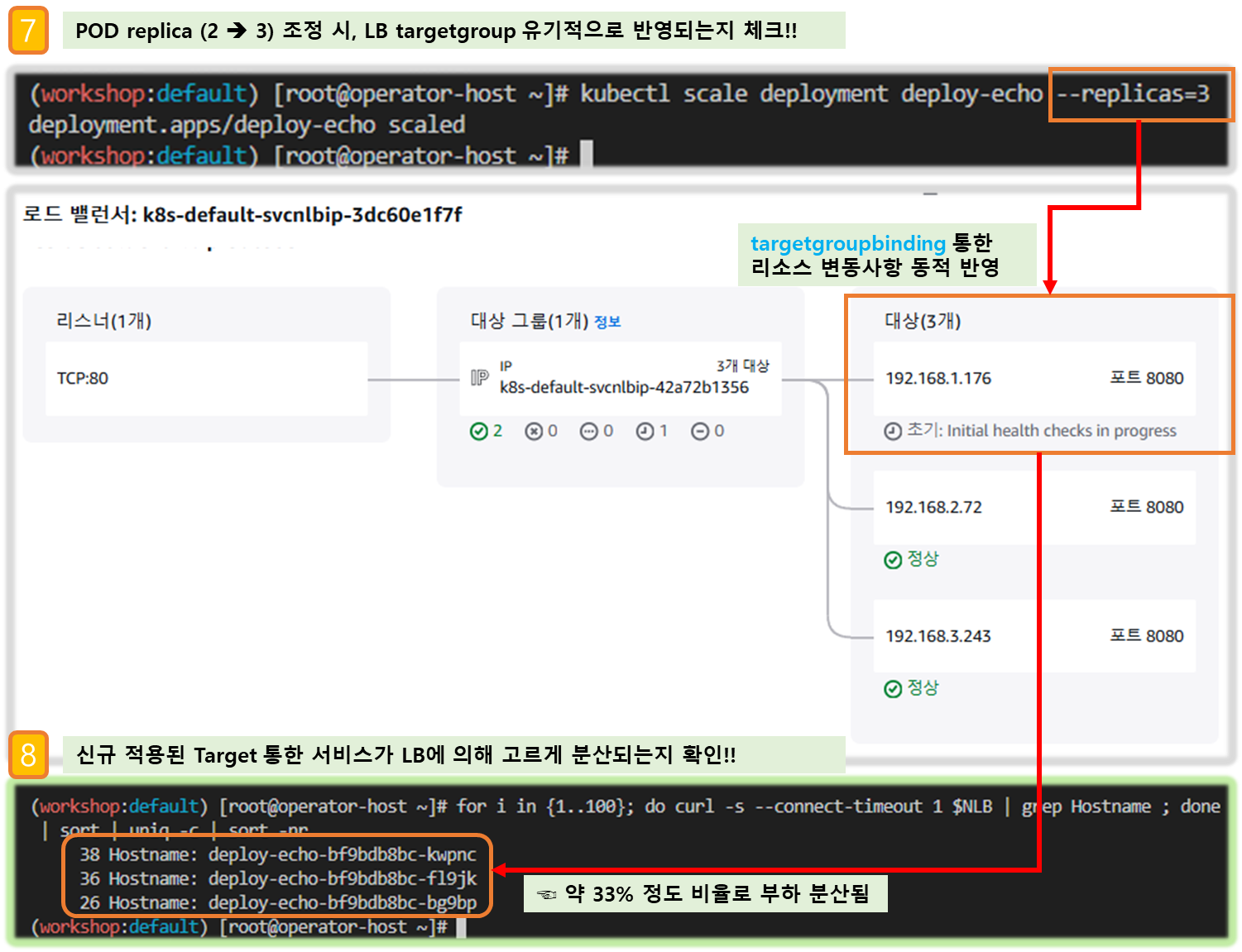

▶ 파드 2개 → 1개 → 3개 설정 시 동작 : auto discovery

# (신규 터미널) 모니터링

while true; do aws elbv2 describe-target-health --target-group-arn $TARGET_GROUP_ARN --output text; echo; done

# 작업용 EC2 - 파드 1개 설정

kubectl scale deployment deploy-echo --replicas=1

# 확인

kubectl get deploy,pod,svc,ep

NLB=$(kubectl get svc svc-nlb-ip-type -o jsonpath='{.status.loadBalancer.ingress[0].hostname}')

curl -s $NLB

for i in {1..100}; do curl -s --connect-timeout 1 $NLB | grep Hostname ; done | sort | uniq -c | sort -nr

# 파드 3개 설정

kubectl scale deployment deploy-echo --replicas=3

# 확인 : NLB 대상 타켓이 아직 initial 일 때 100번 반복 접속 시 어떻게 되는지 확인해보자!

kubectl get deploy,pod,svc,ep

NLB=$(kubectl get svc svc-nlb-ip-type -o jsonpath='{.status.loadBalancer.ingress[0].hostname}')

curl -s $NLB

for i in {1..100}; do curl -s --connect-timeout 1 $NLB | grep Hostname ; done | sort | uniq -c | sort -nr

#

kubectl describe deploy -n kube-system aws-load-balancer-controller | grep -i 'Service Account'

Service Account: aws-load-balancer-controller

# [AWS LB Ctrl] 클러스터 롤 바인딩 정보 확인

kubectl describe clusterrolebindings.rbac.authorization.k8s.io aws-load-balancer-controller-rolebinding

# [AWS LB Ctrl] 클러스터롤 확인

kubectl describe clusterroles.rbac.authorization.k8s.io aws-load-balancer-controller-role[ 실행 결과 - 한 눈에 보기 ]

7. Ingress

7-1. Ingress 이해하기

[ 요약 ]

☞ 클러스터 내부의 서비스(ClusterIP, NodePort, Loadbalancer)를 외부로 노출(HTTP/HTTPS) - Web Proxy 역할

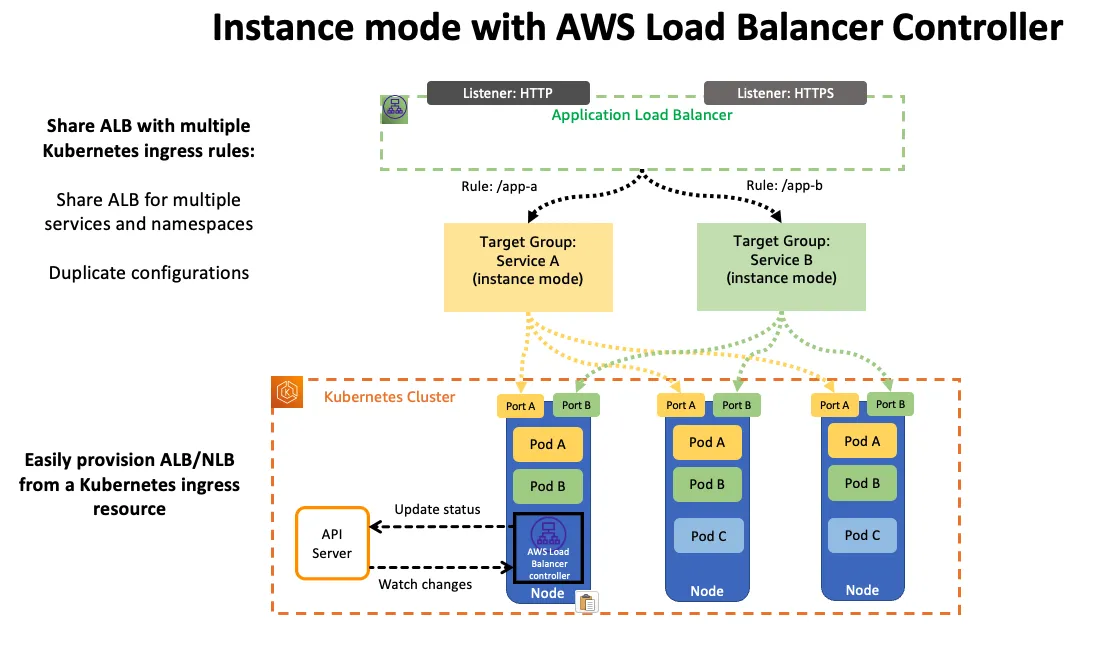

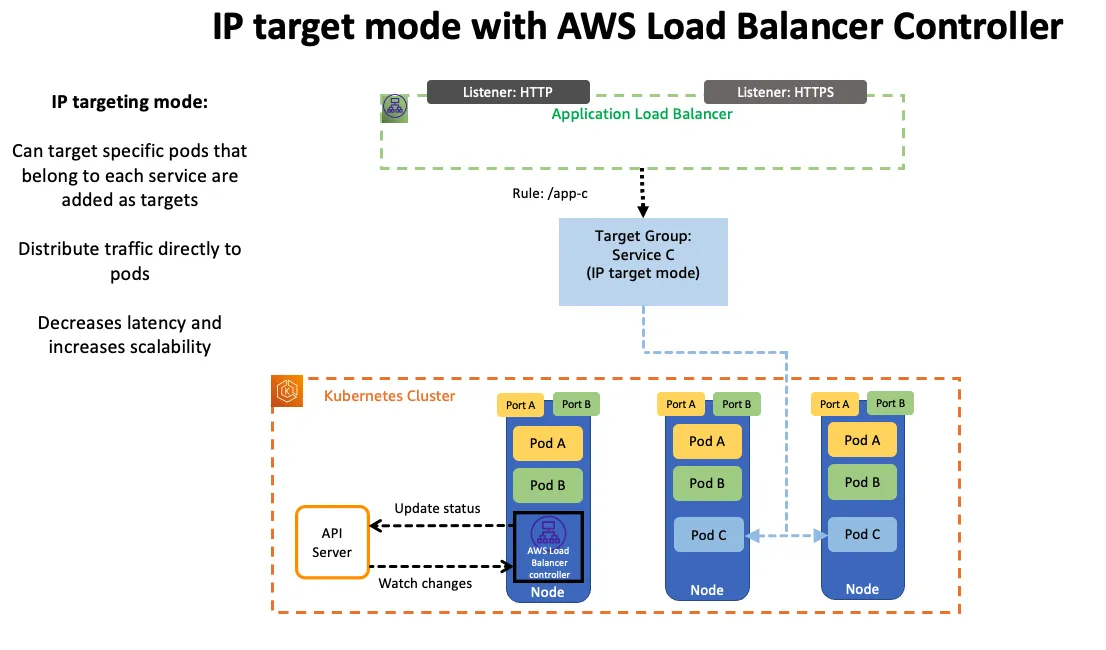

[ AWS Load Balancer Controller + Ingress (ALB) IP 모드 동작 with AWS VPC CNI ]

☞ Ingress ALB 통해서 서비스 Traffic 접근할 경우, ALB가 대상 POD에 대한 IP/Port 를 관리하고 있어 NodePort 서비스를 Bypass 하여 Traffic 을 전달한다. 이로써, NAT 에 필요한 conntract 테이블의 사용도 절약함으로써 최적화 동작이 가능하다.

7-2. 실습

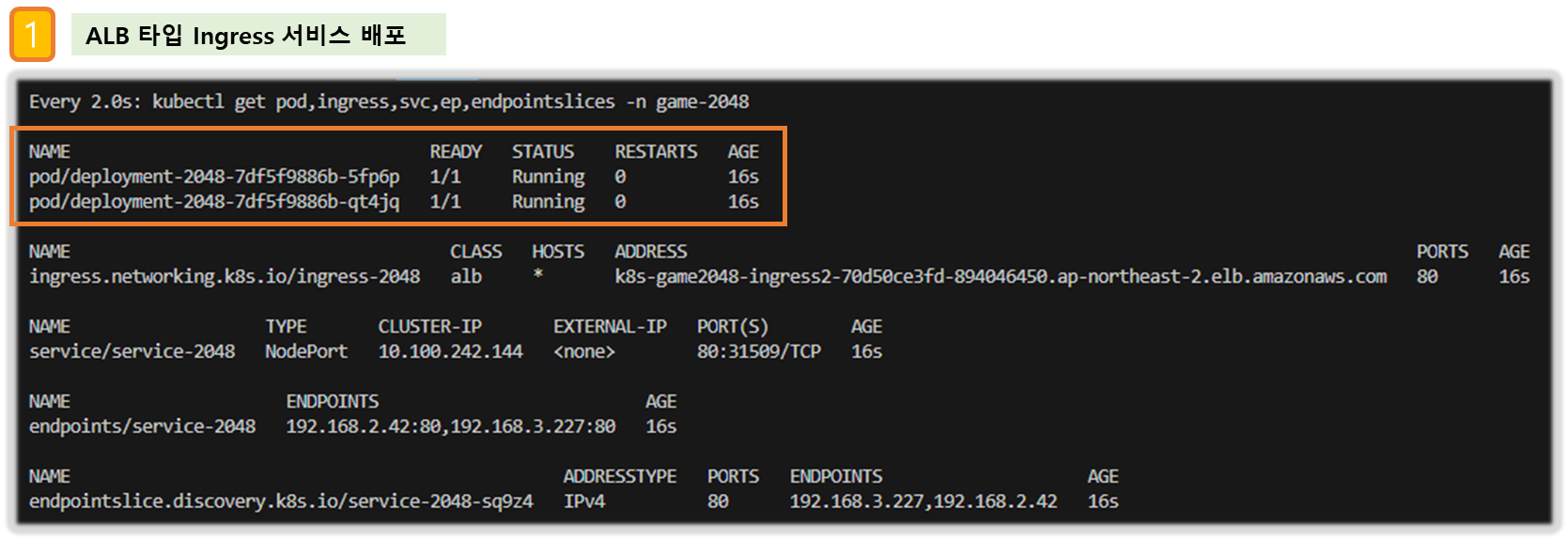

▶ 서비스/파드 배포 테스트 with Ingress(ALB) - ALB

- 코드 설명 : 2개의 replica 설정 된 deployment 로 Pod 배포하며, Nodeport 타입의 서비스를 ALB Ingress 통해서 제공한다.

# 게임 파드와 Service, Ingress 배포

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Namespace

metadata:

name: game-2048

---

apiVersion: apps/v1

kind: Deployment

metadata:

namespace: game-2048

name: deployment-2048

spec:

selector:

matchLabels:

app.kubernetes.io/name: app-2048

replicas: 2

template:

metadata:

labels:

app.kubernetes.io/name: app-2048

spec:

containers:

- image: public.ecr.aws/l6m2t8p7/docker-2048:latest

imagePullPolicy: Always

name: app-2048

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

namespace: game-2048

name: service-2048

spec:

ports:

- port: 80

targetPort: 80

protocol: TCP

type: NodePort

selector:

app.kubernetes.io/name: app-2048

---

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

namespace: game-2048

name: ingress-2048

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

spec:

ingressClassName: alb

rules:

- http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: service-2048

port:

number: 80

EOF

# 모니터링

watch -d kubectl get pod,ingress,svc,ep,endpointslices -n game-2048

# 생성 확인

kubectl get ingress,svc,ep,pod -n game-2048

kubectl get-all -n game-2048

kubectl get targetgroupbindings -n game-2048

# ALB 생성 확인

aws elbv2 describe-load-balancers --query 'LoadBalancers[?contains(LoadBalancerName, `k8s-game2048`) == `true`]' | jq

ALB_ARN=$(aws elbv2 describe-load-balancers --query 'LoadBalancers[?contains(LoadBalancerName, `k8s-game2048`) == `true`].LoadBalancerArn' | jq -r '.[0]')

aws elbv2 describe-target-groups --load-balancer-arn $ALB_ARN

TARGET_GROUP_ARN=$(aws elbv2 describe-target-groups --load-balancer-arn $ALB_ARN | jq -r '.TargetGroups[0].TargetGroupArn')

aws elbv2 describe-target-health --target-group-arn $TARGET_GROUP_ARN | jq

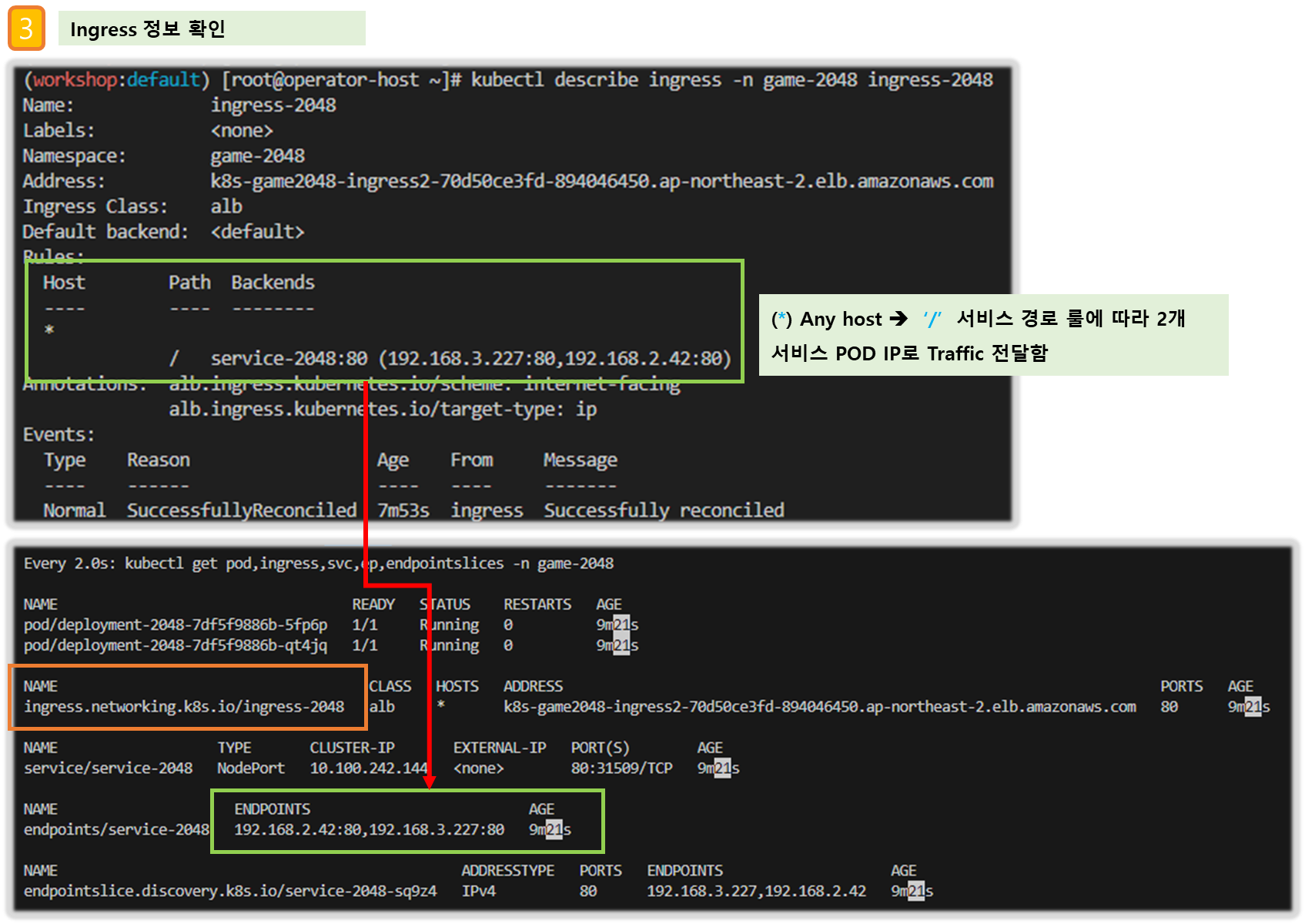

# Ingress 확인

kubectl describe ingress -n game-2048 ingress-2048

kubectl get ingress -n game-2048 ingress-2048 -o jsonpath="{.status.loadBalancer.ingress[*].hostname}{'\n'}"

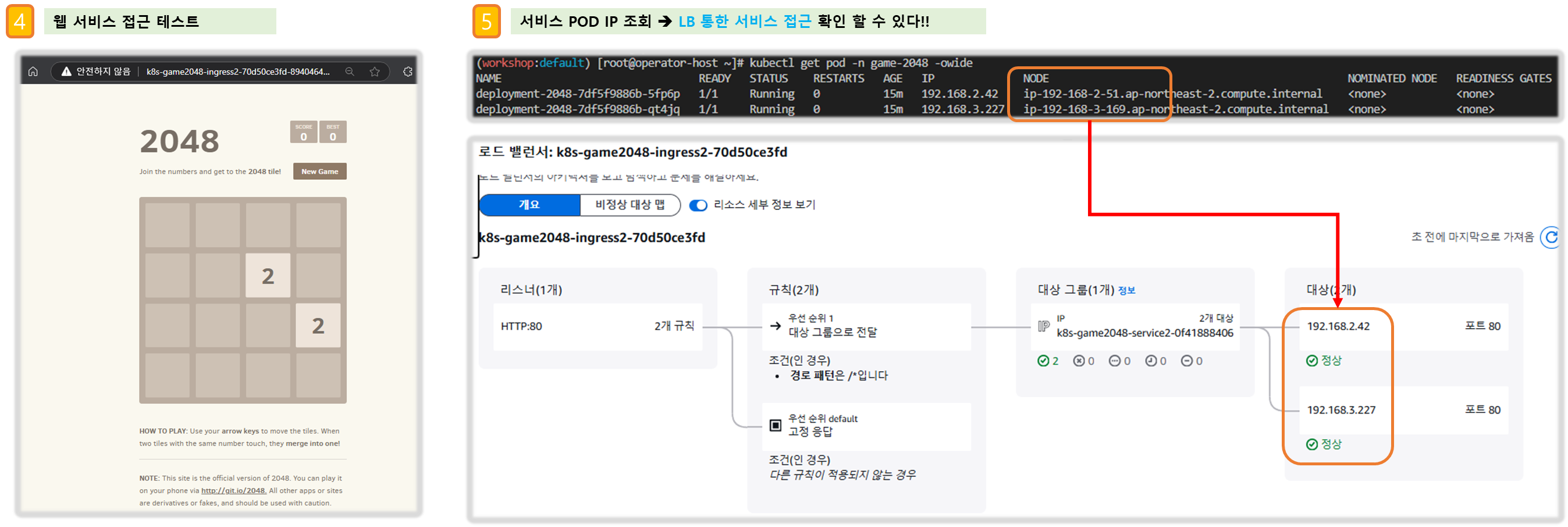

# 게임 접속 : ALB 주소로 웹 접속

kubectl get ingress -n game-2048 ingress-2048 -o jsonpath='{.status.loadBalancer.ingress[0].hostname}' | awk '{ print "Game URL = http://"$1 }'

# 파드 IP 확인

kubectl get pod -n game-2048 -owide

[ 실행 결과 - 한 눈에 보기 ]

8. External DNS

☞ K8S 서비스/인그레스 생성 시 도메인을 설정하면, AWS(Route 53), Azure(DNS), GCP(Cloud DNS) 에 A 레코드(TXT 레코드)로 자동 생성/삭제

- ExternalDNS CTRL 권한 주는 방법 3가지 : Node IAM Role, Static credentials, IRSA

▶ AWS Route 53 정보 확인 & 변수 지정 : Public 도메인 소유를 하고 있어야 테스트 가능함.

# 자신의 도메인 변수 지정 : 소유하고 있는 자신의 도메인을 입력하시면 됩니다

MyDomain=<자신의 도메인>

MyDomain=gasida.link

# 자신의 Route 53 도메인 ID 조회 및 변수 지정

aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." | jq

aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Name"

aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Id" --output text

MyDnzHostedZoneId=`aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Id" --output text`

echo $MyDnzHostedZoneId

# (옵션) NS 레코드 타입 첫번째 조회

aws route53 list-resource-record-sets --output json --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'NS']" | jq -r '.[0].ResourceRecords[].Value'

# (옵션) A 레코드 타입 모두 조회

aws route53 list-resource-record-sets --output json --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']"

# A 레코드 타입 조회

aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']" | jq

aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A'].Name" | jq

aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A'].Name" --output text

# A 레코드 값 반복 조회

while true; do aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']" | jq ; date ; echo ; sleep 1; done▶ ExternalDNS 설치 - 링크

# EKS 배포 시 Node IAM Role 설정되어 있음

# eksctl create cluster ... --external-dns-access ...

#

MyDomain=<자신의 도메인>

MyDomain=gasida.link

# 자신의 Route 53 도메인 ID 조회 및 변수 지정

MyDnzHostedZoneId=$(aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Id" --output text)

# 변수 확인

echo $MyDomain, $MyDnzHostedZoneId

# ExternalDNS 배포

curl -s -O https://raw.githubusercontent.com/gasida/PKOS/main/aews/externaldns.yaml

cat externaldns.yaml

MyDomain=$MyDomain MyDnzHostedZoneId=$MyDnzHostedZoneId envsubst < externaldns.yaml | kubectl apply -f -

# 확인 및 로그 모니터링

kubectl get pod -l app.kubernetes.io/name=external-dns -n kube-system

kubectl logs deploy/external-dns -n kube-system -f▶ Service(NLB) + 도메인 연동(ExternalDNS) - 도메인체크

# 터미널1 (모니터링)

watch -d 'kubectl get pod,svc'

kubectl logs deploy/external-dns -n kube-system -f

혹은

kubectl stern -l app.kubernetes.io/name=external-dns -n kube-system

# 테트리스 디플로이먼트 배포

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: tetris

labels:

app: tetris

spec:

replicas: 1

selector:

matchLabels:

app: tetris

template:

metadata:

labels:

app: tetris

spec:

containers:

- name: tetris

image: bsord/tetris

---

apiVersion: v1

kind: Service

metadata:

name: tetris

annotations:

service.beta.kubernetes.io/aws-load-balancer-nlb-target-type: ip

service.beta.kubernetes.io/aws-load-balancer-scheme: internet-facing

service.beta.kubernetes.io/aws-load-balancer-cross-zone-load-balancing-enabled: "true"

service.beta.kubernetes.io/aws-load-balancer-backend-protocol: "http"

#service.beta.kubernetes.io/aws-load-balancer-healthcheck-port: "80"

spec:

selector:

app: tetris

ports:

- port: 80

protocol: TCP

targetPort: 80

type: LoadBalancer

loadBalancerClass: service.k8s.aws/nlb

EOF

# 배포 확인

kubectl get deploy,svc,ep tetris

# NLB에 ExternanDNS 로 도메인 연결

kubectl annotate service tetris "external-dns.alpha.kubernetes.io/hostname=tetris.$MyDomain"

while true; do aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']" | jq ; date ; echo ; sleep 1; done

# Route53에 A레코드 확인

aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']" | jq

# 확인

dig +short tetris.$MyDomain @8.8.8.8

dig +short tetris.$MyDomain

# 도메인 체크

echo -e "My Domain Checker Site1 = https://www.whatsmydns.net/#A/tetris.$MyDomain"

echo -e "My Domain Checker Site2 = https://dnschecker.org/#A/tetris.$MyDomain"

# 웹 접속 주소 확인 및 접속

echo -e "Tetris Game URL = http://tetris.$MyDomain"

[ 중요 - 중간 자원 정리 ]

kubectl delete ingress ingress-2048 -n game-2048

kubectl delete svc service-2048 -n game-2048 && kubectl delete deploy deployment-2048 -n game-2048 && kubectl delete ns game-20489. Core DNS

[ 요약 ]

☞ Core DNS란 ?

- Kubernetes 클러스터 DNS로 사용할 수 있는 유연하고 확장 가능한 DNS 서버 를 말한다.

하나 이상의 노드가 있는 Amazon EKS 클러스터를 시작하면 클러스터에 배포된 노드 수에 관계없이 CoreDNS 이미지의 복제본 2개가 기본적으로 배포된다.

[ 참고 링크 ]

- (심화) Recent changes to the CoreDNS add-on - Link

☞ EKS CoreDNS 애드온 구성 스키마에 topologySpreadConstraints 설정 추가

# CoreDNS 기본 정보 확인 : volumes - configMap - Corefile - coredns

kubectl get deploy coredns -n kube-system -o yaml | kubectl neat

kubectl get cm -n kube-system coredns -o yaml | kubectl neat

data:

Corefile: |

.:53 {

errors

health {

lameduck 5s

}

ready

kubernetes cluster.local in-addr.arpa ip6.arpa {

pods insecure

fallthrough in-addr.arpa ip6.arpa

}

prometheus :9153

forward . /etc/resolv.conf

cache 30

loop

reload

loadbalance

}

# JSON 구성 스키마에 topologySpreadConstraints 매개변수를 추가

aws eks describe-addon-configuration --addon-name coredns --addon-version v1.10.1-eksbuild.2 --query 'configurationSchema' --output text | jq .

aws eks describe-addon-configuration --addon-name coredns --addon-version v1.10.1-eksbuild.2 --query 'configurationSchema' --output text | jq . | grep -A3 topologySpreadConstraints

# check coredns deployment - it returns an empty output because it is not set by default

kubectl get deploy -n kube-system coredns -o yaml | grep topologySpreadConstraints -A8

#

aws eks describe-addon --cluster-name $CLUSTER_NAME --addon-name coredns | jq

{

"addon": {

"addonName": "coredns",

"clusterName": "myeks",

"status": "ACTIVE",

"addonVersion": "v1.10.1-eksbuild.7",

"health": {

"issues": []

},

"addonArn": "arn:aws:eks:ap-northeast-2:911283464785:addon/myeks/coredns/4ec712ea-54eb-05df-5d57-7b52ef1efc6f",

"createdAt": "2024-03-10T09:47:58.100000+09:00",

"modifiedAt": "2024-03-10T09:48:06.073000+09:00",

"tags": {}

}

}

# add-on configuration YAML blob

cat << EOT > topologySpreadConstraints.yaml

"topologySpreadConstraints":

- maxSkew: 1

topologyKey: topology.kubernetes.io/zone

whenUnsatisfiable: ScheduleAnyway

labelSelector:

matchLabels:

k8s-app: kube-dns

EOT

# apply change to add-on

aws eks update-addon --cluster-name $CLUSTER_NAME --addon-name coredns --configuration-values 'file://topologySpreadConstraints.yaml'

# check add-on configuration to see if it is in ACTIVE status

aws eks describe-addon --cluster-name $CLUSTER_NAME --addon-name coredns | jq

kubectl get deploy coredns -n kube-system -o yaml | kubectl neat

...

topologySpreadConstraints:

- labelSelector:

matchLabels:

k8s-app: kube-dns

maxSkew: 1

topologyKey: topology.kubernetes.io/zone

whenUnsatisfiable: ScheduleAnyway

...[ 실습 후 자원 정리]

## - Amazon EKS 클러스터 삭제(10분 정도 소요):

`eksctl delete cluster --name $CLUSTER_NAME`

## - (클러스터 삭제 완료 확인 후) AWS CloudFormation 스택 삭제 : **

`aws cloudformation delete-stack --stack-name myeks`[ 마무리 ]

두번 째 수업도 양이 엄청 나네요~ 가능한 선에서 정리해보았는데도 절반도 못한 느낌입니다. ㅠㅠ 그만큼 제가 공부해야 할 양이 많다는 것이겠죠.. 환경세팅 부터 중간 중간 문제를 겪으면서, '왜 나는 안되지?' 라는 질문과 해답을 찾는 과정을 반복하고 있습니다. 그래도, 작년 KANS3 에서 배웠던 내용들에 대해서는 조금 익숙한 느낌이라 용기가 납니다. 쿠버네티스 과정을 마칠 때 쯤, 조금이나마 더 성장할 모습을 꿈꾸며 이번 주말도 열심히 달려야 겠습니다~ ^^/

[ 참고 링크 모음 ]

▶ AWS Docs & External-DNS

AWS EKS Docs - Link

- Quickstart: Deploy a web app and store data - Link

- Configure networking - Link

- Workloads - Link

- Enable EKS Zonal Shift to avoid impaired Availability Zones - Link

- Learn about Amazon Application Recovery Controller’s (ARC) Zonal Shift in Amazon EKS - Link

EKS Workshop - Link

- Amazon VPC CNI - Link

- Network Policies - Link

- Security Groups for Pods - Link

- Custom Networking - Link

- Prefix Delegation - Link

- Amazon VPC Lattice - Link

AWS Load Balancer Controller - Link

- How it works - Link

- Deployment

- Guide

- Ingress

- Service

- TargetGroupBinding

- Tasks

- SSL Redirect - Link

- Use Cases

External-DNS - Link

AWS EKS Best Practices Guide - Link

- Network - Link**

- VPC and Subnet Considerations - Link

- Amazon VPC CNI - Link*

- Optimizing IP Address Utilization - Link

- Custom Networking - Link

- Prefix Mode for Linux - Link

- Security Groups Per Pod - Link

- Load Balancing - Link

- Monitoring EKS workloads for Network performance issues - Link

- Running kube-proxy in IPVS Mode - Link

- Scalability

- Cluster Upgrades - Link

- Cost Optimization - Link

- Cost Optimization Network - Link

▶ AWS Blog

2024

- Implement a central ingress Application Load Balancer supporting private Amazon Elastic Kubernetes Service VPCs - 링크

- Monitoring and automating recovery from AZ impairments in Amazon EKS with Istio and ARC Zonal Shift - Link

- Amazon EKS now supports Amazon Application Recovery Controller - Link

- Preserving client IP address with Proxy protocol v2 and Network Load Balancer - Link

- Migrating from AWS App Mesh to Amazon VPC Lattice - Link

- Patterns for TargetGroupBinding with AWS Load Balancer Controller - Link

- Ensuring fair bandwidth allocation for Amazon EKS Workloads - Link

- Amazon VPC CNI introduces Enhanced Subnet Discovery - Link

- Enabling mTLS with ALB in Amazon EKS - Link

- Spark on Amazon EKS networking – Part 2 - Link

- Spark on Amazon EKS networking – Part 1 - Link

2023

- Empowering Kubernetes Observability with eBPF on Amazon EKS - Link , Caretta

- Deploying AWS Load Balancer Controller on Amazon EKS - Link

- Enhanced VPC flexibility: modify subnets and security groups in Amazon EKS - Link

- Improving availability with Application Load Balancer automatic target weights - Link

- Optimize AZ traffic costs using Amazon EKS, Karpenter, and Istio - Link

- Run Amazon EKS on RHEL Worker Nodes with IPVS Networking - Link

- On-premises egress design patterns for Amazon EKS - Link

- Recent changes to the CoreDNS add-on - Link

- Amazon VPC CNI now supports Kubernetes Network Policies - Link

- Network Load Balancers now support Security groups - Link

- Automating custom networking to solve IPv4 exhaustion in Amazon EKS - Link

- A deeper look at Ingress Sharing and Target Group Binding in AWS Load Balancer Controller - Link

- Scale from 100 to 10,000 pods on Amazon EKS - Link

- How to rapidly scale your application with ALB on EKS (without losing traffic) - Link

- Blue/Green or Canary Amazon EKS clusters migration for stateless ArgoCD workloads - Link

2022

- Expose Amazon EKS pods through cross-account load balancer - Link

- Exposing Kubernetes Applications, Part 3: Ingress-Nginx Controller - Link

- Exposing Kubernetes Applications, Part 2: AWS Load Balancer Controller - Link

- Exposing Kubernetes Applications, Part 1: Service and Ingress Resources - Link