| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 |

- life of packet

- kmesh

- prometheus

- kiali

- vpc cni

- argocd

- 엠비언트모드

- aws eks

- Ingress

- istio-proxy

- Ambient

- istio traffic flow

- Kubernetes

- CICD

- Observability

- vagrant

- Jenkins

- vm support

- Kind

- envoy filter

- CNI

- loadbalancer

- K8S

- docker

- WSL

- service mesh

- envoy

- 데이터 플레인 확장

- grafana

- Istio

- Today

- Total

WellSpring

Istio-3주차 Istio Traffic 제어 및 복원력 본문

목차

- Chap5. 트레픽 제어 : 세밀한 트레픽 라우팅

- 5.1 새로운 코드 배포의 위험 줄이기

- 5.1.1 배포 vs 릴리스

- 5.2 이스티오로 요청 라우팅 하기

- 5.3 Traffic shifting (실습)

- 5.3.1 (Automating) Canary releasing with Flagger (Progressive Delivery Operator for Kubernetes) - Link

- 5.4 Reducing risk even further: Traffic mirroring

- 5.5 Routing to services outside your cluster by using Istio’s service discovery

- Chap6. 복원력 : 애플리케이션 네트워킹 문제 해결하기

※ 본 게재 글은 gasida님의 'Istio' 스터디 강의 및 실습예제와 'Istio in Action' 서적을 참고하여 작성하였습니다.

[ 주요 참고 링크 ]

- Envoy **1.19.0** 공식 문서 https://www.envoyproxy.io/docs/envoy/**v1.19.0**/

- Istio **1.17** 공식 문서 https://istio.io/**v1.17**/docs/

- 스터디 실습 환경 : docker (kind - k8s **1.23.17** ‘23.2.28 - Link) , istio **1.17.8**(’23.10.11) - Link

[ 실습 환경 설정 ]

1) k8s(1.23.17) 배포 : NodePort(30000 HTTP, 30005 HTTPS)

#

git clone https://github.com/AcornPublishing/istio-in-action

cd istio-in-action/book-source-code-master

pwd # 각자 자신의 pwd 경로

code .

# 아래 extramounts 생략 시, myk8s-control-plane 컨테이너 sh/bash 진입 후 직접 git clone 가능

kind create cluster --name myk8s --image kindest/node:v1.23.17 --config - <<EOF

kind: Cluster

apiVersion: kind.x-k8s.io/v1alpha4

nodes:

- role: control-plane

extraPortMappings:

- containerPort: 30000 # Sample Application (istio-ingrssgateway) HTTP

hostPort: 30000

- containerPort: 30001 # Prometheus

hostPort: 30001

- containerPort: 30002 # Grafana

hostPort: 30002

- containerPort: 30003 # Kiali

hostPort: 30003

- containerPort: 30004 # Tracing

hostPort: 30004

- containerPort: 30005 # Sample Application (istio-ingrssgateway) HTTPS

hostPort: 30005

- containerPort: 30006 # TCP Route

hostPort: 30006

- containerPort: 30007 # kube-ops-view

hostPort: 30007

extraMounts: # 해당 부분 생략 가능

- hostPath: /Users/gasida/Downloads/istio-in-action/book-source-code-master # 각자 자신의 pwd 경로로 설정

containerPath: /istiobook

networking:

podSubnet: 10.10.0.0/16

serviceSubnet: 10.200.1.0/24

EOF

# 설치 확인

docker ps

# 노드에 기본 툴 설치

docker exec -it myk8s-control-plane sh -c 'apt update && apt install tree psmisc lsof wget bridge-utils net-tools dnsutils tcpdump ngrep iputils-ping git vim -y'

# (옵션) kube-ops-view

helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=NodePort,service.main.ports.http.nodePort=30007 --set env.TZ="Asia/Seoul" --namespace kube-system

kubectl get deploy,pod,svc,ep -n kube-system -l app.kubernetes.io/instance=kube-ops-view

## kube-ops-view 접속 URL 확인

open "http://localhost:30007/#scale=1.5"

open "http://localhost:30007/#scale=1.3"

# (옵션) metrics-server

helm repo add metrics-server https://kubernetes-sigs.github.io/metrics-server/

helm install metrics-server metrics-server/metrics-server --set 'args[0]=--kubelet-insecure-tls' -n kube-system

kubectl get all -n kube-system -l app.kubernetes.io/instance=metrics-server

2) istio 1.17.8 설치 (addon 필수) - Docs , Install , profile

# myk8s-control-plane 진입 후 설치 진행

docker exec -it myk8s-control-plane bash

-----------------------------------

# (옵션) 코드 파일들 마운트 확인

tree /istiobook/ -L 1

혹은

git clone ... /istiobook

# istioctl 설치

export ISTIOV=1.17.8

echo 'export ISTIOV=1.17.8' >> /root/.bashrc

curl -s -L https://istio.io/downloadIstio | ISTIO_VERSION=$ISTIOV sh -

cp istio-$ISTIOV/bin/istioctl /usr/local/bin/istioctl

istioctl version --remote=false

# default 프로파일 컨트롤 플레인 배포

istioctl install --set profile=default -y

# 설치 확인 : istiod, istio-ingressgateway, crd 등

kubectl get istiooperators -n istio-system -o yaml

kubectl get all,svc,ep,sa,cm,secret,pdb -n istio-system

kubectl get cm -n istio-system istio -o yaml

kubectl get crd | grep istio.io | sort

# 보조 도구 설치

kubectl apply -f istio-$ISTIOV/samples/addons

kubectl get pod -n istio-system

# 빠져나오기

exit

-----------------------------------

# 실습을 위한 네임스페이스 설정

kubectl create ns istioinaction

kubectl label namespace istioinaction istio-injection=enabled

kubectl get ns --show-labels

# istio-ingressgateway 서비스 : NodePort 변경 및 nodeport 지정 변경 , externalTrafficPolicy 설정 (ClientIP 수집)

kubectl patch svc -n istio-system istio-ingressgateway -p '{"spec": {"type": "NodePort", "ports": [{"port": 80, "targetPort": 8080, "nodePort": 30000}]}}'

kubectl patch svc -n istio-system istio-ingressgateway -p '{"spec": {"type": "NodePort", "ports": [{"port": 443, "targetPort": 8443, "nodePort": 30005}]}}'

kubectl patch svc -n istio-system istio-ingressgateway -p '{"spec":{"externalTrafficPolicy": "Local"}}'

kubectl describe svc -n istio-system istio-ingressgateway

# NodePort 변경 및 nodeport 30001~30003으로 변경 : prometheus(30001), grafana(30002), kiali(30003), tracing(30004)

kubectl patch svc -n istio-system prometheus -p '{"spec": {"type": "NodePort", "ports": [{"port": 9090, "targetPort": 9090, "nodePort": 30001}]}}'

kubectl patch svc -n istio-system grafana -p '{"spec": {"type": "NodePort", "ports": [{"port": 3000, "targetPort": 3000, "nodePort": 30002}]}}'

kubectl patch svc -n istio-system kiali -p '{"spec": {"type": "NodePort", "ports": [{"port": 20001, "targetPort": 20001, "nodePort": 30003}]}}'

kubectl patch svc -n istio-system tracing -p '{"spec": {"type": "NodePort", "ports": [{"port": 80, "targetPort": 16686, "nodePort": 30004}]}}'

# Prometheus 접속 : envoy, istio 메트릭 확인

open http://127.0.0.1:30001

# Grafana 접속

open http://127.0.0.1:30002

# Kiali 접속 1 : NodePort

open http://127.0.0.1:30003

# (옵션) Kiali 접속 2 : Port forward

kubectl port-forward deployment/kiali -n istio-system 20001:20001 &

open http://127.0.0.1:20001

# tracing 접속 : 예거 트레이싱 대시보드

open http://127.0.0.1:30004

# 내부 접속 테스트용 netshoot 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: netshoot

spec:

containers:

- name: netshoot

image: nicolaka/netshoot

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

[ 설치 결과 - 확인 ]

1) istio-system 내 istiod 및 monitoring Pods 확인 ( k8s-control-plane 에서 수행 )

2) istio enable 및 확인

Chap5. 트레픽 제어 : 세밀한 트레픽 라우팅

☞ 고객에게 제공하는 서비스의 품질 유지를 위해 최소한의 중단과 영향으로 안전하게 새 버전을 도입하는 방법을 고민해 보자!!

5.1 새로운 코드 배포의 위험 줄이기

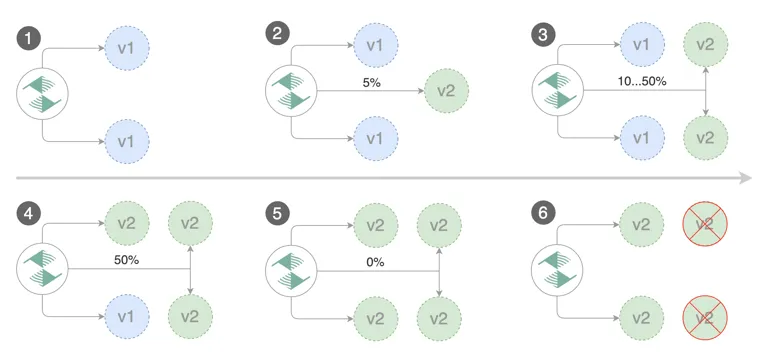

- ACME 사에서 시도한 패턴 중 블루/그린 배포 활용 : 여전히 v1 -> v2 전환 시 Big-bang을 겪어야 함

5.1.1 배포 vs 릴리스

[ 정의 ]

a. 배포( Deployment ) : 어플리케이션의 새 버전(또는 설정 변경)을 EKS 클러스터에 실제로 반영하는 작업

- 일반적으로는 GitOps 또는 CI/CD 파이프라인을 통해 이루어지며,

- kubectl apply, helm upgrade, 혹은 ArgoCD, Flux와 같은 툴을 통해 수행됩니다.

- 배포의 목적은 새로운 기능, 패치, 설정 등을 클러스터에 반영하는 것입니다.

b. 릴리스 ( Release ) : 배포된 기능이나 버전을 실제로 사용자에게 노출시키는 단계

☞ 해당 시점부터 사용자 트래픽이 해당 버전을 타게 되며, Istio 같은 서비스 메시를 사용하면 트래픽을 버전별로 분리해서 릴리스 전략을 정교하게 구현할 수 있습니다.

- Canary: 전체 트래픽 중 일부(예: 5%, 20%)만 새 버전으로 분기

- Blue-Green: 두 버전을 동시에 띄우고 라우팅만 전환

- Header 기반: 특정 조건(쿠키, 사용자, 지역)에 따라 라우팅

실 트래픽은 구 버전이 대부분 처리하고, 신규 트래픽 일부를 신 버전에서 처리하는 데, 이런 방식을 Canarying 또는 Canary release 라고 부른다.

5.2 이스티오로 요청 라우팅 하기

☞ 이전 Chap2 에서 트래픽 라우팅은 Istio Virtual Service 리소스를 사용함

- 2장에서는 Istio를 사용하여 카탈로그 서비스로의 트래픽을 제어했습니다.

- Istio VirtualService 리소스를 사용하여 트래픽을 라우팅하는 방법을 지정했습니다.

- 어떻게 작동하는지 자세히 살펴보겠습니다. 요청의 내용에 따라 헤더를 평가하여 요청의 경로를 제어합니다.

- 이러한 방식으로 다크 런치라는 기술을 사용하여 특정 사용자에게 배포를 제공할 수 있습니다.

- 어두운 실행에서는 많은 사용자가 알려진 작동 중인 서비스 버전으로 보내지며, 특정 클래스의 사용자는 최신 버전으로 보내집니다.

- 따라서 우리는 다른 모든 사람에게 영향을 미치지 않고 특정 그룹에 통제된 방식으로 새로운 기능을 노출할 수 있습니다.

5.2.1 작업 공간 청소

# 4장 실습 리소스들 삭제

kubectl delete deployment,svc,gateway,virtualservice,destinationrule --all -n istioinaction

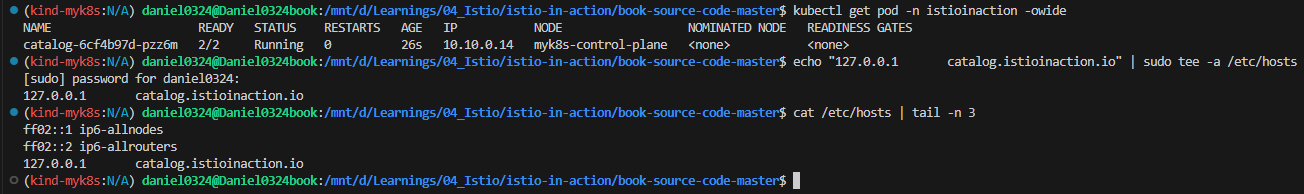

▶ 5.2.2 Deploying v1 of the catalog service

# Let’s deploy v1 of our catalog service. From the root of the book’s source code, run the following command

kubectl apply -f services/catalog/kubernetes/catalog.yaml -n istioinaction

# 확인

kubectl get pod -n istioinaction -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

catalog-6cf4b97d-ftl77 2/2 Running 0 42s 10.10.0.14 myk8s-control-plane <none> <none>

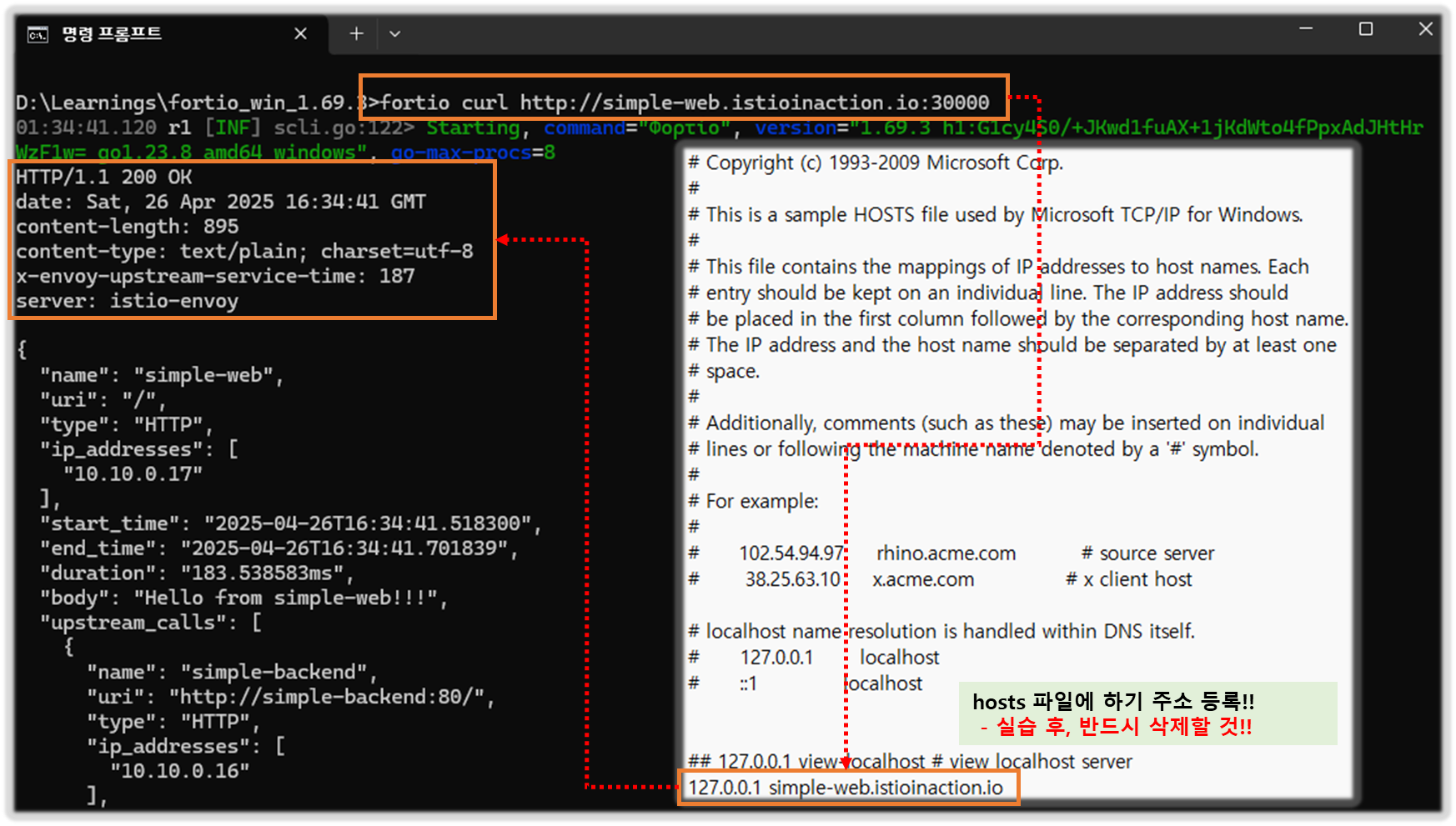

# 도메인 질의를 위한 임시 설정 : 실습 완료 후에는 삭제 해둘 것

echo "127.0.0.1 catalog.istioinaction.io" | sudo tee -a /etc/hosts

cat /etc/hosts | tail -n 3

# netshoot로 내부에서 catalog 접속 확인

kubectl exec -it netshoot -- curl -s http://catalog.istioinaction/items | jq

# 외부 노출을 위해 Gateway 설정

cat ch5/catalog-gateway.yaml

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: catalog-gateway

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "catalog.istioinaction.io"

kubectl apply -f ch5/catalog-gateway.yaml -n istioinaction

# 트래픽을 catalog 서비스로 라우팅하는 VirtualService 리소스 설정

cat ch5/catalog-vs.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog-vs-from-gw

spec:

hosts:

- "catalog.istioinaction.io"

gateways:

- catalog-gateway

http:

- route:

- destination:

host: catalog

kubectl apply -f ch5/catalog-vs.yaml -n istioinaction

# 확인

kubectl get gw,vs -n istioinaction

NAME AGE

gateway.networking.istio.io/catalog-gateway 95s

NAME GATEWAYS HOSTS AGE

virtualservice.networking.istio.io/catalog-vs-from-gw ["catalog-gateway"] ["catalog.istioinaction.io"] 3s

# 도메인 질의를 위한 임시 설정 : 실습 완료 후에는 삭제 해둘 것

echo "127.0.0.1 catalog.istioinaction.io" | sudo tee -a /etc/hosts

cat /etc/hosts | tail -n 3

# istio-ingressgateway Service(NodePort)에 포트 정보 확인

kubectl get svc -n istio-system istio-ingressgateway -o jsonpath="{.spec.ports}" | jq

[

{

"name": "status-port",

"nodePort": 31674,

"port": 15021,

"protocol": "TCP",

"targetPort": 15021

},

{

"name": "http2",

"nodePort": 30000, # 순서1

"port": 80,

"protocol": "TCP",

"targetPort": 8080 # 순서2

},

{

"name": "https",

"nodePort": 30005,

"port": 443,

"protocol": "TCP",

"targetPort": 8443

}

]

# 호스트에서 NodePort(Service)로 접속 확인

curl -v -H "Host: catalog.istioinaction.io" http://localhost:30000

kubectl stern -l app=catalog -n istioinaction

open http://localhost:30000

open http://catalog.istioinaction.io:30000

open http://catalog.istioinaction.io:30000/items

# 신규 터미널 : 반복 접속 실행 해두기

while true; do curl -s http://catalog.istioinaction.io:30000/items/ ; sleep 1; echo; done

while true; do curl -s http://catalog.istioinaction.io:30000/items/ -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

while true; do curl -s http://catalog.istioinaction.io:30000/items/ -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 0.5; echo; done

[ 실행 결과 - 한 눈에 보기 ]

1) istio 실습 POD 상태 확인

2) netshoot Pod 통한 catalog items 확인

3) gw, svc 배포 확인

- 호스트 외부에서 호출 경로 : 아래 그림 맨 왼쪽(curl client)는 외부라고 생각하면 됨.

- 상세 정보 확인

#

docker exec -it myk8s-control-plane istioctl proxy-status

NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION

catalog-6cf4b97d-ftl77.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

istio-ingressgateway-996bc6bb6-zvtdc.istio-system Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

# istio-ingressgateway

## LDS - Listener Discovery Service

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/istio-ingressgateway.istio-system --port 8080

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/istio-ingressgateway.istio-system --port 8080 -o json

## RDS - Route Discovery Service

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080 -o json

## CDS - Cluseter Discovery Service

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local -o json

## EDS - Endpoint Discovery Service

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local'

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local' -o json

# catalog

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction

- 특정 파드의 istio-proxy 에 Envoy 에 Admin 웹 접속

# 신규 터미널 : istio-ingressgateway 파드

kubectl port-forward deploy/istio-ingressgateway -n istio-system 15000:15000

#

open http://127.0.0.1:15000

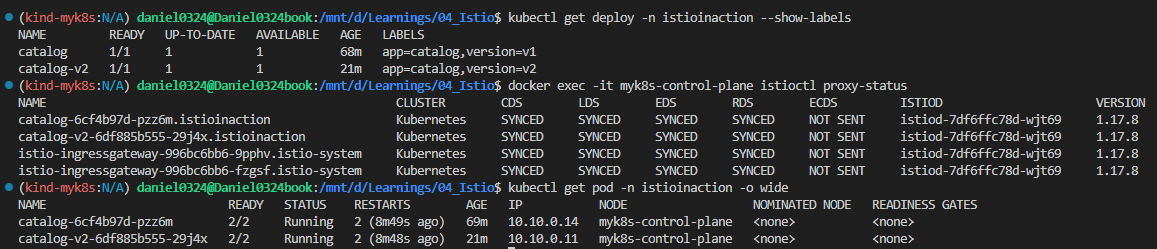

▶ 5.2.3 Deploying v2 of the catalog service

☞ istio 트래픽 제어 기능 동작을 알아보기 위해, catalog 서비스 v2 를 배포해보자.

⇒ 버전1,2 호출 된다. v2 호출되지 않게 할 수 없을까?

# catalog 서비스 v2 를 배포 : v2에서는 imageUrl 필드가 추가

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction

#

kubectl get deploy -n istioinaction --show-labels

NAME READY UP-TO-DATE AVAILABLE AGE LABELS

catalog 1/1 1 1 30m app=catalog,version=v1

catalog-v2 1/1 1 1 34s app=catalog,version=v2

kubectl get pod -n istioinaction -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

catalog-6cf4b97d-ftl77 2/2 Running 0 43m 10.10.0.14 myk8s-control-plane <none> <none>

catalog-v2-6df885b555-6hmcl 2/2 Running 0 13m 10.10.0.15 myk8s-control-plane <none> <none>

docker exec -it myk8s-control-plane istioctl proxy-status

NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION

catalog-6cf4b97d-ftl77.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

catalog-v2-6df885b555-6hmcl.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

istio-ingressgateway-996bc6bb6-zvtdc.istio-system Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

# 호출 테스트 : v1 , v2 호출 확인

for i in {1..10}; do curl -s http://catalog.istioinaction.io:30000/items/ ; printf "\n\n"; done

# istio-ingressgateway proxy-config 확인

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local -o json

...

"name": "outbound|80||catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80||catalog.istioinaction.svc.cluster.local"

},

"connectTimeout": "10s",

"lbPolicy": "LEAST_REQUEST",

"circuitBreakers": {

"thresholds": [

{

"maxConnections": 4294967295,

"maxPendingRequests": 4294967295,

"maxRequests": 4294967295,

"maxRetries": 4294967295,

"trackRemaining": true

}

]

},

"commonLbConfig": {

"localityWeightedLbConfig": {}

},

...

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.16:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local' -o json

...

{

"name": "outbound|80||catalog.istioinaction.svc.cluster.local",

"addedViaApi": true,

"hostStatuses": [

{

"address": {

"socketAddress": {

"address": "10.10.0.14",

"portValue": 3000

}

},

"stats": [

{

"name": "cx_connect_fail"

},

{

"value": "8",

"name": "cx_total"

},

{

"name": "rq_error"

},

{

"value": "315",

"name": "rq_success"

},

{

"name": "rq_timeout"

},

{

"value": "315",

"name": "rq_total"

},

{

"type": "GAUGE",

"value": "8",

"name": "cx_active"

},

{

"type": "GAUGE",

"name": "rq_active"

}

],

"healthStatus": {

"edsHealthStatus": "HEALTHY"

},

"weight": 1,

"locality": {}

},

{

"address": {

"socketAddress": {

"address": "10.10.0.15",

"portValue": 3000

}

},

"stats": [

{

"name": "cx_connect_fail"

},

{

"value": "8",

"name": "cx_total"

},

{

"name": "rq_error"

},

{

"value": "308",

"name": "rq_success"

},

{

"name": "rq_timeout"

},

{

"value": "308",

"name": "rq_total"

},

{

"type": "GAUGE",

"value": "8",

"name": "cx_active"

},

{

"type": "GAUGE",

"name": "rq_active"

}

],

"healthStatus": {

"edsHealthStatus": "HEALTHY"

},

"weight": 1,

"locality": {}

}

],

"circuitBreakers": {

"thresholds": [

{

"maxConnections": 4294967295,

"maxPendingRequests": 4294967295,

"maxRequests": 4294967295,

"maxRetries": 4294967295

},

{

"priority": "HIGH",

"maxConnections": 1024,

"maxPendingRequests": 1024,

"maxRequests": 1024,

"maxRetries": 3

}

]

},

"observabilityName": "outbound|80||catalog.istioinaction.svc.cluster.local",

"edsServiceName": "outbound|80||catalog.istioinaction.svc.cluster.local"

},

...

# catalog proxy-config 도 직접 확인해보자

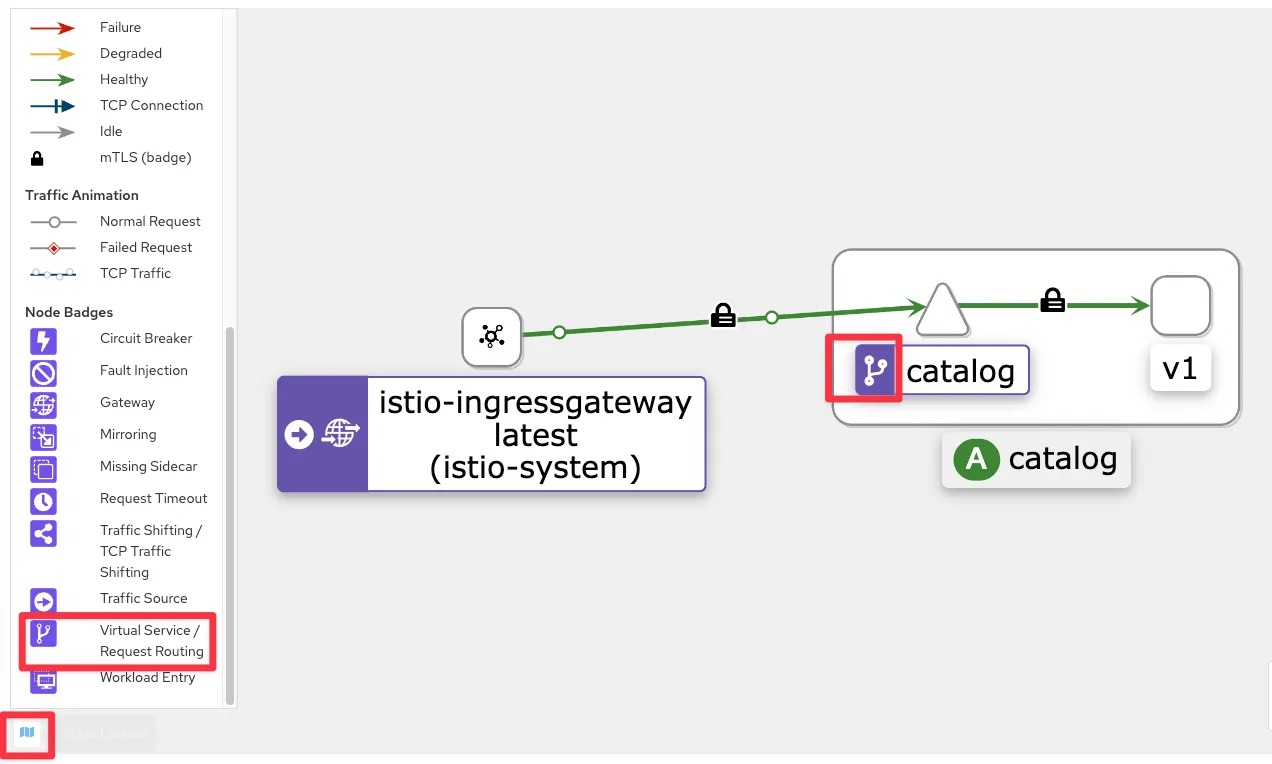

[ 실행 결과 - 한 눈에 보기 ]

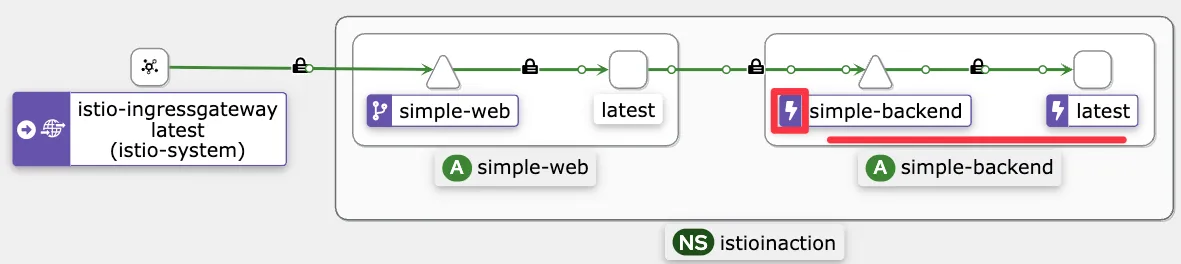

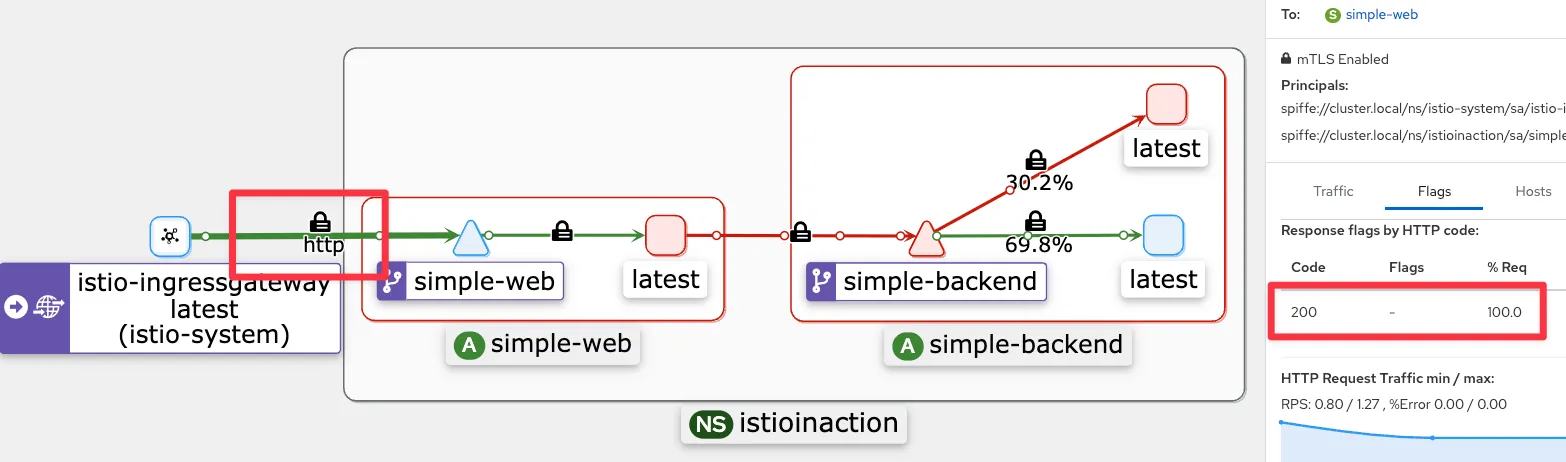

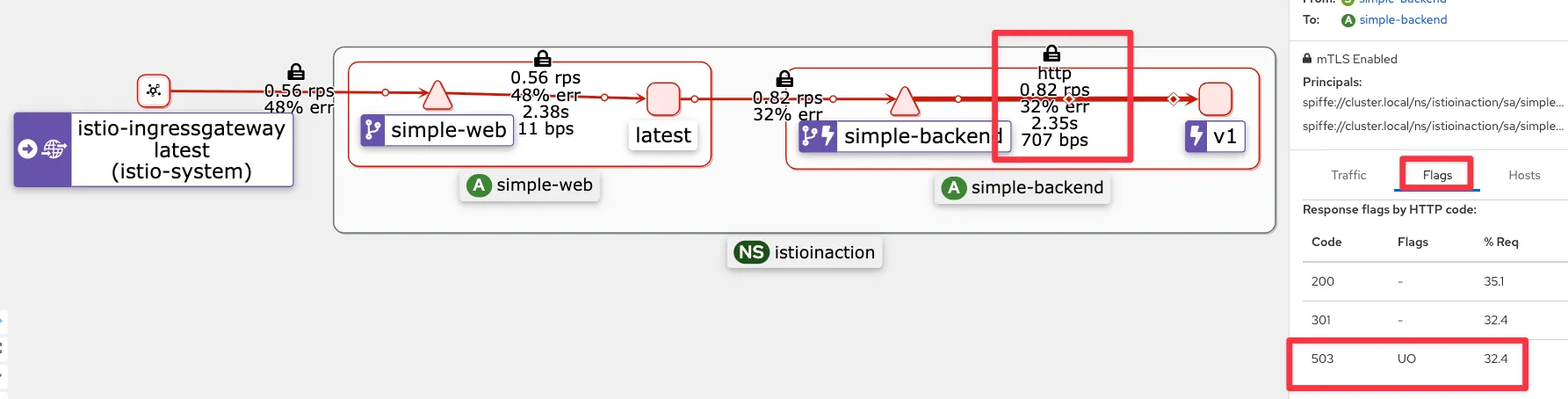

1) Catalog v2 배포후, deploy, POD, proxy status 확인

2) Kiali 확인

3) Destination Rule 배포

4) FQDN 확인

5) endpoint 확인

6) V1으로 routing 변경한 VS 배포 후, kiali 관찰

▶ 5.2.4 Routing all traffic to v1 of the catalog service

- 모든 트래픽을 catalog v1 으로 라우팅. 이것이 다크런치를 시작하기 전의 일반적인 트래픽 패턴이다.

- 어느 워크로드가 v1, v2 인지 이스티오에게 힌트를 줘야한다.

- catalog v1은 deployment 리소스에서 레이블 app:catalog, version:v1 을 사용한다.

- catalog v2은 deployment 리소스에서 레이블 app:catalog, version:v2 을 사용한다.

- 이스티오에게는 이렇게 다른 버전들의 부분집합 subset 으로 지정하는 DestinationRule 을 만들어준다.

#

kubectl get pod -l app=catalog -n istioinaction --show-labels

NAME READY STATUS RESTARTS AGE LABELS

catalog-6cf4b97d-ftl77 2/2 Running 0 56m app=catalog,...,version=v1

catalog-v2-6df885b555-6hmcl 2/2 Running 0 26m app=catalog,...,version=v2

#

cat ch5/catalog-dest-rule.yaml

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: catalog

spec:

host: catalog.istioinaction.svc.cluster.local

subsets:

- name: version-v1

labels:

version: v1

- name: version-v2

labels:

version: v2

kubectl apply -f ch5/catalog-dest-rule.yaml -n istioinaction

# 확인

kubectl get destinationrule -n istioinaction

NAME HOST AGE

catalog catalog.istioinaction.svc.cluster.local 8s

# catalog proxy-config 확인 : SUBSET(v1, v2, -) 확인

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog.istioinaction.svc.cluster.local 80 - outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v1 outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v2 outbound EDS catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --subset version-v1 -o json

...

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local"

},

"connectTimeout": "10s",

"lbPolicy": "LEAST_REQUEST",

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --subset version-v2 -o json

...

"name": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local"

},

"connectTimeout": "10s",

"lbPolicy": "LEAST_REQUEST",

...

#

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local -o json

...

"name": "outbound|80||catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80||catalog.istioinaction.svc.cluster.local"

},

...

#

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system | egrep 'ENDPOINT|istioinaction'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.16:3000 HEALTHY OK outbound|80|version-v1|catalog.istioinaction.svc.cluster.local

10.10.0.16:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80|version-v2|catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v1|catalog.istioinaction.svc.cluster.local'

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v1|catalog.istioinaction.svc.cluster.local' -o json

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v2|catalog.istioinaction.svc.cluster.local'

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v2|catalog.istioinaction.svc.cluster.local' -o json

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.16:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

# VirtualService 수정 (subset 추가)

cat ch5/catalog-vs-v1.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog-vs-from-gw

spec:

hosts:

- "catalog.istioinaction.io"

gateways:

- catalog-gateway

http:

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v1.yaml -n istioinaction

# 호출 테스트 : v1

for i in {1..10}; do curl -s http://catalog.istioinaction.io:30000/items/ ; printf "\n\n"; done

# 세부 정보 확인

# routes 에 virtualHosts 항목에 routes.route 에 cluster 부분이 ...version-v1... 설정 확인

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080 -o json

...

"virtualHosts": [

{

"name": "catalog.istioinaction.io:80",

"domains": [

"catalog.istioinaction.io"

],

"routes": [

{

"match": {

"prefix": "/"

},

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"timeout": "0s",

"retryPolicy": {

"retryOn": "connect-failure,refused-stream,unavailable,cancelled,retriable-status-codes",

"numRetries": 2,

...

# cluster

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --subset version-v1

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog.istioinaction.svc.cluster.local 80 version-v1 outbound EDS catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --subset version-v1 -o json

...

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local"

},

...

"metadata": {

"filterMetadata": {

"istio": {

"config": "/apis/networking.istio.io/v1alpha3/namespaces/istioinaction/destination-rule/catalog",

"default_original_port": 80,

"services": [

{

"host": "catalog.istioinaction.svc.cluster.local",

"name": "catalog",

"namespace": "istioinaction"

}

],

"subset": "version-v1"

...

# endpoint

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system | egrep 'ENDPOINT|istioinaction'

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v1|catalog.istioinaction.svc.cluster.local'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.16:3000 HEALTHY OK outbound|80|version-v1|catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v1|catalog.istioinaction.svc.cluster.local' -o json

...

# istio-proxy (catalog)

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction --subset version-v1 -o json

...

"metadata": {

"filterMetadata": {

"istio": {

"config": "/apis/networking.istio.io/v1alpha3/namespaces/istioinaction/destination-rule/catalog",

"default_original_port": 80,

"services": [

{

"host": "catalog.istioinaction.svc.cluster.local",

"name": "catalog",

"namespace": "istioinaction"

}

],

"subset": "version-v1"

}

}

},

...

- 이 시점에서 모든 트래픽이 v1 라우팅 된다.

- 이제 특정 요청들을 통제된 방식으로 v2 라우팅하고 싶다. 다음 절에서 알아보자.

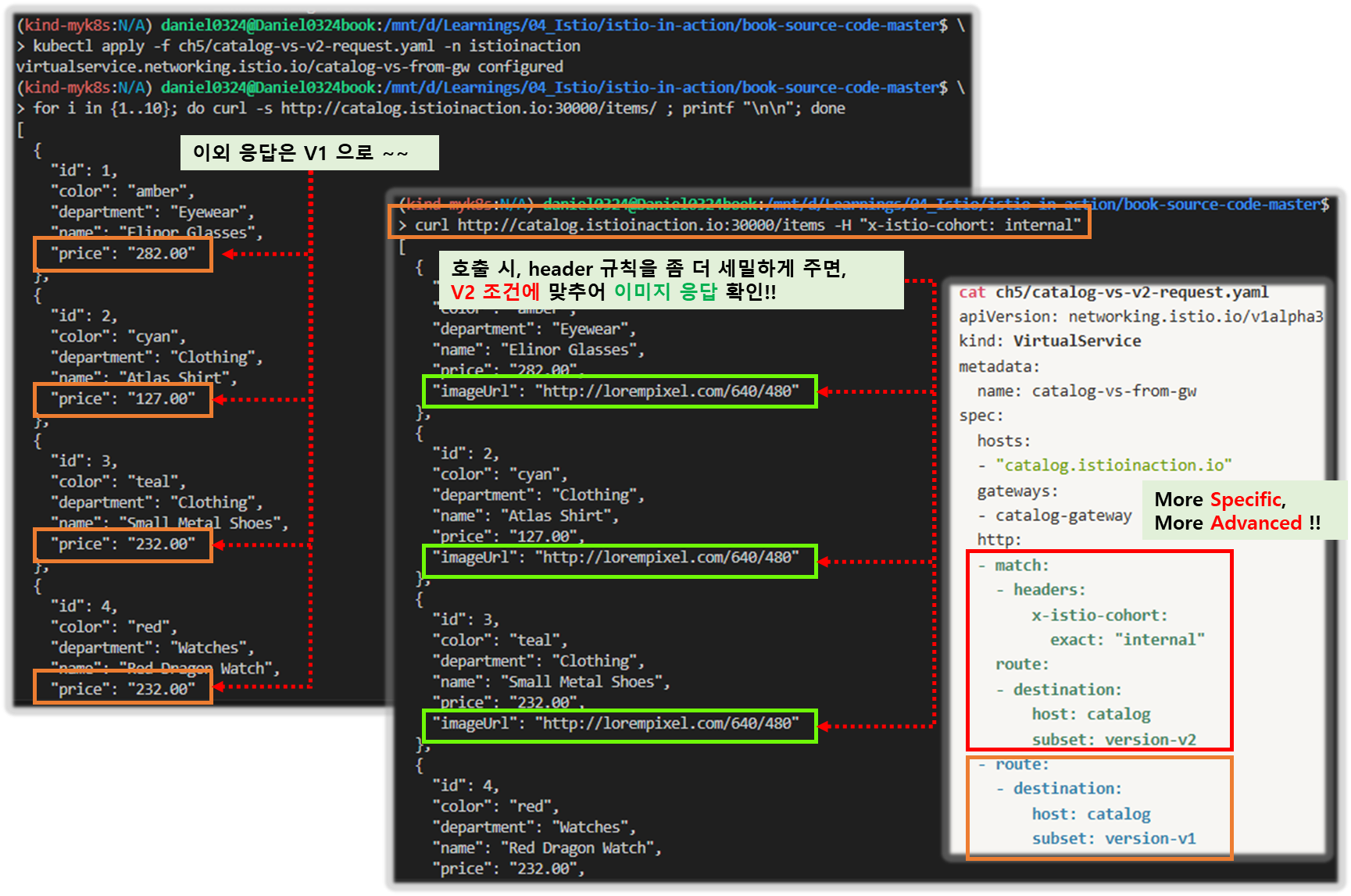

▶ 5.2.5 Routing specific requests to v2

HTTP 요청 헤더 x-istio-cohort: internal 을 포함한 트래픽(통제된 방식)은 catalog v2로 보내도록 하자.

#

cat ch5/catalog-vs-v2-request.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog-vs-from-gw

spec:

hosts:

- "catalog.istioinaction.io"

gateways:

- catalog-gateway

http:

- match:

- headers:

x-istio-cohort:

exact: "internal"

route:

- destination:

host: catalog

subset: version-v2

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v2-request.yaml -n istioinaction

# 호출 테스트 : 여전히 v1

for i in {1..10}; do curl -s http://catalog.istioinaction.io:30000/items/ ; printf "\n\n"; done

# 요청 헤더 포함 호출 테스트 : v2!

curl http://catalog.istioinaction.io:30000/items -H "x-istio-cohort: internal"

# (옵션) 신규 터미널 : v2 반복 접속

while true; do curl -s http://catalog.istioinaction.io:30000/items/ -H "x-istio-cohort: internal" -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done

# 상세 확인

# route 추가 : routes 에 2개의 route 확인 - 위에서 부터 적용되는 순서 중요!

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080

NAME DOMAINS MATCH VIRTUAL SERVICE

http.8080 catalog.istioinaction.io /* catalog-vs-from-gw.istioinaction

http.8080 catalog.istioinaction.io /* catalog-vs-from-gw.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080 -o json

...

"virtualHosts": [

{

"name": "catalog.istioinaction.io:80",

"domains": [

"catalog.istioinaction.io"

],

"routes": [

{

"match": {

"prefix": "/",

"caseSensitive": true,

"headers": [

{

"name": "x-istio-cohort",

"stringMatch": {

"exact": "internal"

}

}

]

},

"route": {

"cluster": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"timeout": "0s",

...

{

"match": {

"prefix": "/"

},

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

...

#

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system | egrep 'ENDPOINT|istioinaction'

# istio-proxy (catalog)에는 routes 정보가 아래 cluster 로 보내는 1개만 있다. 즉 istio-proxy(istio-ingressgateway)가 routes 분기 처리하는 것을 알 수 있다.

## "cluster": "outbound|80||catalog.istioinaction.svc.cluster.local"

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction --name 80 -o json

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction | grep catalog

80 catalog, catalog.istioinaction + 1 more... /*

[ 헤더 규칙에 따른 routing 분기 확인 ]

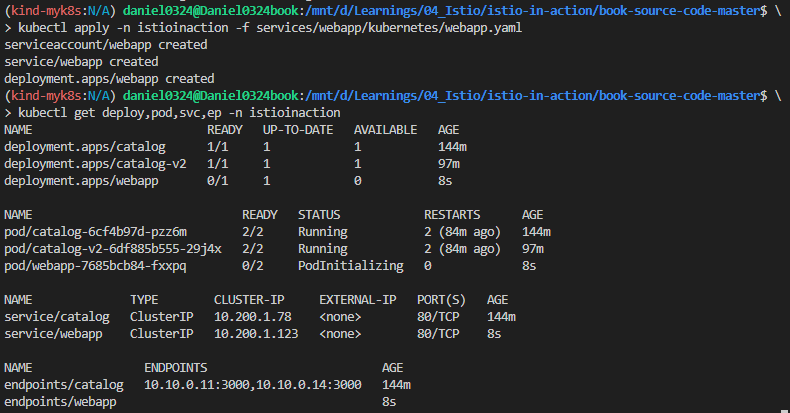

▶ 5.2.6 Routing deep within a call graph 호출 그래프 내 깊은 위치에서 라우팅 Mesh(Gateway)

- 지금까지 이스티오를 사용해 요청을 라우팅하는 방법을 살펴봤지만, 라우팅 수행 위치가 에지/게이트웨이뿐이었다.

- 이런 트래픽 규칙은 호출 그래프 내 깊은 곳에서도 적용할 수 있습니다. (그림 5.9 참조).

- 2장에서 이 작업을 수행했으므로, 프로세스를 다시 만들고 기대대로 동작하는지 확인해보자.

# 초기화

kubectl delete gateway,virtualservice,destinationrule --all -n istioinaction

# webapp 기동

kubectl apply -n istioinaction -f services/webapp/kubernetes/webapp.yaml

kubectl apply -f services/catalog/kubernetes/catalog.yaml -n istioinaction # 이미 배포 상태

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction # 이미 배포 상태

# 확인

kubectl get deploy,pod,svc,ep -n istioinaction

NAME READY UP-TO-DATE AVAILABLE AGE

deployment.apps/catalog 1/1 1 1 55m

deployment.apps/catalog-v2 1/1 1 1 48m

deployment.apps/webapp 1/1 1 1 42s

NAME READY STATUS RESTARTS AGE

pod/catalog-6cf4b97d-jxpb8 2/2 Running 0 55m

pod/catalog-v2-6df885b555-rg9f5 2/2 Running 0 48m

pod/webapp-7685bcb84-2q7rg 2/2 Running 0 42s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/catalog ClusterIP 10.200.1.254 <none> 80/TCP 55m

service/webapp ClusterIP 10.200.1.61 <none> 80/TCP 42s

NAME ENDPOINTS AGE

endpoints/catalog 10.10.0.16:3000,10.10.0.17:3000 55m

endpoints/webapp 10.10.0.18:8080 42s

- GW, VS 설정 후 호출 테스트 : webapp → catalog 는 k8s service(clusterIP) 라우팅 사용

# Now, set up the Istio ingress gateway to route to the webapp service

cat services/webapp/istio/webapp-catalog-gw-vs.yaml

---

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: coolstore-gateway

spec:

selector:

istio: ingressgateway # use istio default controller

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "webapp.istioinaction.io"

---

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: webapp-virtualservice

spec:

hosts:

- "webapp.istioinaction.io"

gateways:

- coolstore-gateway

http:

- route:

- destination:

host: webapp

port:

number: 80

kubectl apply -f services/webapp/istio/webapp-catalog-gw-vs.yaml -n istioinaction

# 확인

kubectl get gw,vs -n istioinaction

NAME AGE

gateway.networking.istio.io/coolstore-gateway 3s

NAME GATEWAYS HOSTS AGE

virtualservice.networking.istio.io/webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 3s

# 도메인 질의를 위한 임시 설정 : 실습 완료 후에는 삭제 해둘 것

echo "127.0.0.1 webapp.istioinaction.io" | sudo tee -a /etc/hosts

cat /etc/hosts | tail -n 3

# 호출테스트 : 외부(web, curl) → ingressgw → webapp → catalog (v1, v2)

curl -s http://webapp.istioinaction.io:30000/api/catalog | jq

# 반복 호출테스트 : 신규터미널 2개에 아래 각각 실행 해두기

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -H "x-istio-cohort: internal" -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done

# proxy-config : istio-ingressgateway

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080

NAME DOMAINS MATCH VIRTUAL SERVICE

http.8080 webapp.istioinaction.io /* webapp-virtualservice.istioinaction

=> route."cluster": "outbound|80||webapp.istioinaction.svc.cluster.local"

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system | egrep 'webapp|catalog'

catalog.istioinaction.svc.cluster.local 80 - outbound EDS

webapp.istioinaction.svc.cluster.local 80 - outbound EDS

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn webapp.istioinaction.svc.cluster.local -o json

...

"name": "outbound|80||webapp.istioinaction.svc.cluster.local",

"type": "EDS",

...

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||webapp.istioinaction.svc.cluster.local'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.18:8080 HEALTHY OK outbound|80||webapp.istioinaction.svc.cluster.local

# proxy-config : webapp

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/webapp.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction

# proxy-config : catalog

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction

# webapp istio-proxy 로그 활성화

# 신규 터미널

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

# webapp istio-proxy 로그 활성화 적용

cat << EOF | kubectl apply -f -

apiVersion: telemetry.istio.io/v1alpha1

kind: Telemetry

metadata:

name: webapp

namespace: istioinaction

spec:

selector:

matchLabels:

app: webapp

accessLogging:

- providers:

- name: envoy #2 액세스 로그를 위한 프로바이더 설정

disabled: false #3 disable 를 false 로 설정해 활성화한다

EOF

# webapp → catalog 는 k8s service(clusterIP) 라우팅 사용 확인!

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

[2025-04-18T13:27:57.178Z] "HEAD /api/catalog HTTP/1.1" 200 - via_upstream - "-" 0 0 8 8 "172.18.0.1" "curl/8.7.1" "8d425652-17a9-4b41-a21c-874acab3b1f4" "webapp.istioinaction.io:30000" "10.10.0.18:8080" inbound|8080|| 127.0.0.6:51809 10.10.0.18:8080 172.18.0.1:0 outbound_.80_._.webapp.istioinaction.svc.cluster.local default

=> 이 로그는 webapp 서비스의 사이드카 프록시가 클라이언트로부터 직접 HTTP 요청을 받은 장면이고, 이 요청을 10.10.0.18:8080 (즉, webapp 서비스의 실제 컨테이너)으로 보냄을 의미

[2025-04-18T13:27:58.237Z] "GET /items HTTP/1.1" 200 - via_upstream - "-" 0 502 2 2 "172.18.0.1" "beegoServer" "49b55b86-2505-4a5c-aadf-950d03705b87" "catalog.istioinaction:80" "10.10.0.16:3000" outbound|80||catalog.istioinaction.svc.cluster.local 10.10.0.18:45152 10.200.1.254:80 172.18.0.1:0 - default

=> 이 로그는 webapp 서비스가 catalog 서비스로 HTTP 요청을 보낸 상황이에요. Envoy는 catalog.istioinaction이라는 Kubernetes catalog 서비스(clusterIp 10.200.1.254:80)로 라우팅하고, 실제 Pod IP는 10.10.0.16:3000으로 연결되었어요.

...

[ VS 및 DR 재 배포 후, 라우팅 규칙 확인 ]

Let’s create VirtualService and DestinationRule resources that route all traffic to v1 of the catalog service

카탈로그 서비스 v1으로 모든 트래픽을 보내는 virtual Service 와 DR 을 설정해보자.

#

ch5/catalog-dest-rule.yaml

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: catalog

spec:

host: catalog.istioinaction.svc.cluster.local

subsets:

- name: version-v1

labels:

version: v1

- name: version-v2

labels:

version: v2

kubectl apply -f ch5/catalog-dest-rule.yaml -n istioinaction

# istio-proxy

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog.istioinaction.svc.cluster.local 80 - outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v1 outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v2 outbound EDS catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system | egrep 'ENDPOINT|istioinaction'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.16:3000 HEALTHY OK outbound|80|version-v1|catalog.istioinaction.svc.cluster.local

10.10.0.16:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80|version-v2|catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.18:8080 HEALTHY OK outbound|80||webapp.istioinaction.svc.cluster.local

#

cat ch5/catalog-vs-v1-mesh.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways: # 만약, gateways 부분을 제외하고 배포하면 암묵적으로 mesh gateways가 적용됨.

- mesh # VirtualService는 메시 내의 모든 사이드카(현재 webapp, catalog)에 적용된다. edge는 제외.

http:

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v1-mesh.yaml -n istioinaction

# VirtualService 확인 : GATEWAYS 에 mesh 확인

kubectl get vs -n istioinaction

NAME GATEWAYS HOSTS AGE

catalog ["mesh"] ["catalog"] 12s

webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 28s

# 반복 호출테스트 : 신규터미널 2개에 아래 각각 실행 해두기 >> 현재는 v1만 라우팅 처리

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -H "x-istio-cohort: internal" -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done

# webapp → catalog 호출도 istio 의 DestinationRule 라우팅 전달 처리! : 신규터미널

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

[2025-04-18T13:52:54.772Z] "GET /items HTTP/1.1" 200 - via_upstream - "-" 0 502 2 2 "172.18.0.1" "beegoServer" "2035962f-144f-4d07-9102-4e3ab7ea3484" "catalog.istioinaction:80" "10.10.0.16:3000" outbound|80|version-v1|catalog.istioinaction.svc.cluster.local 10.10.0.18:52458 10.200.1.254:80 172.18.0.1:0 - -

=> 이 로그는 webapp이 내부적으로 catalog 서비스를 호출하는 로그이고, version-v1이라는 **서브셋(subset)**으로 요청이 라우팅되었어요. 이는 DestinationRule에서 subset: version-v1으로 정의된 엔드포인트로 라우팅이 잘 되었다는 뜻이에요.

# proxy-config (webapp) : 기존에 webapp 에서 catalog 로 VirtualService 정보는 없었는데, 추가됨을 확인

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction | egrep 'NAME|catalog'

NAME DOMAINS MATCH VIRTUAL SERVICE

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json > webapp-routes.json

cat webapp-routes.json | jq

...

"virtualHosts": [

{

"name": "catalog.istioinaction.svc.cluster.local:80",

"domains": [

"catalog.istioinaction.svc.cluster.local",

"catalog",

"catalog.istioinaction.svc",

"catalog.istioinaction",

"10.200.1.254" # 해당 IP는 catalog service(clusterIP)

],

"routes": [

{

"match": {

"prefix": "/"

},

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"timeout": "0s",

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog.istioinaction.svc.cluster.local

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog.istioinaction.svc.cluster.local 80 - outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v1 outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v2 outbound EDS catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --subset version-v1 -o json

...

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"type": "EDS",

...

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | egrep 'ENDPOINT|catalog'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.16:3000 HEALTHY OK outbound|80|version-v1|catalog.istioinaction.svc.cluster.local

10.10.0.16:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80|version-v2|catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

# proxy-config (catalog) : gateway.mesh 이므로, 메시 내에 모든 사이드카에 VirtualService 적용됨을 확인. 아래 routes 부분

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction | egrep 'NAME|catalog'

NAME DOMAINS MATCH VIRTUAL SERVICE

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction

[ 실행 결과 - 한 눈에 보기 ]

#

cat ch5/catalog-vs-v2-request-mesh.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways:

- mesh

http:

- match:

- headers:

x-istio-cohort:

exact: "internal"

route:

- destination:

host: catalog

subset: version-v2

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v2-request-mesh.yaml -n istioinaction

# 반복 호출테스트 : 신규터미널 2개에 아래 각각 실행 >> v1, v2 각기 라우팅 확인

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -H "x-istio-cohort: internal" -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done

# proxy-config (webapp) : 기존에 webapp 에서 catalog 로 VirtualService 추가된 2개 항목 확인

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction | egrep 'NAME|catalog'

NAME DOMAINS MATCH VIRTUAL SERVICE

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json > webapp-routes.json

cat webapp-routes.json | jq

...

"virtualHosts": [

{

"name": "catalog.istioinaction.svc.cluster.local:80",

"domains": [

"catalog.istioinaction.svc.cluster.local",

"catalog",

"catalog.istioinaction.svc",

"catalog.istioinaction",

"10.200.1.254"

],

"routes": [

{

"match": {

"prefix": "/",

"caseSensitive": true,

"headers": [

{

"name": "x-istio-cohort",

"stringMatch": {

"exact": "internal"

}

}

]

},

"route": {

"cluster": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

....

{

"match": {

"prefix": "/"

},

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | egrep 'ENDPOINT|catalog'

# proxy-config (catalog) : mesh 이므로 VS가 아래 routes(catalog)에도 적용됨

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction

[ 실행 결과 - 한 눈에 보기 ]

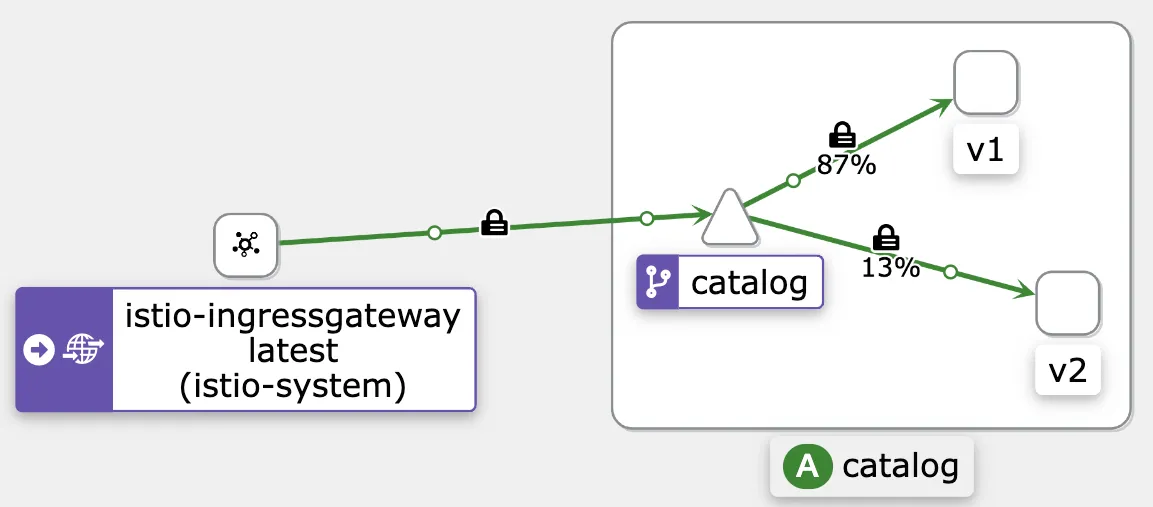

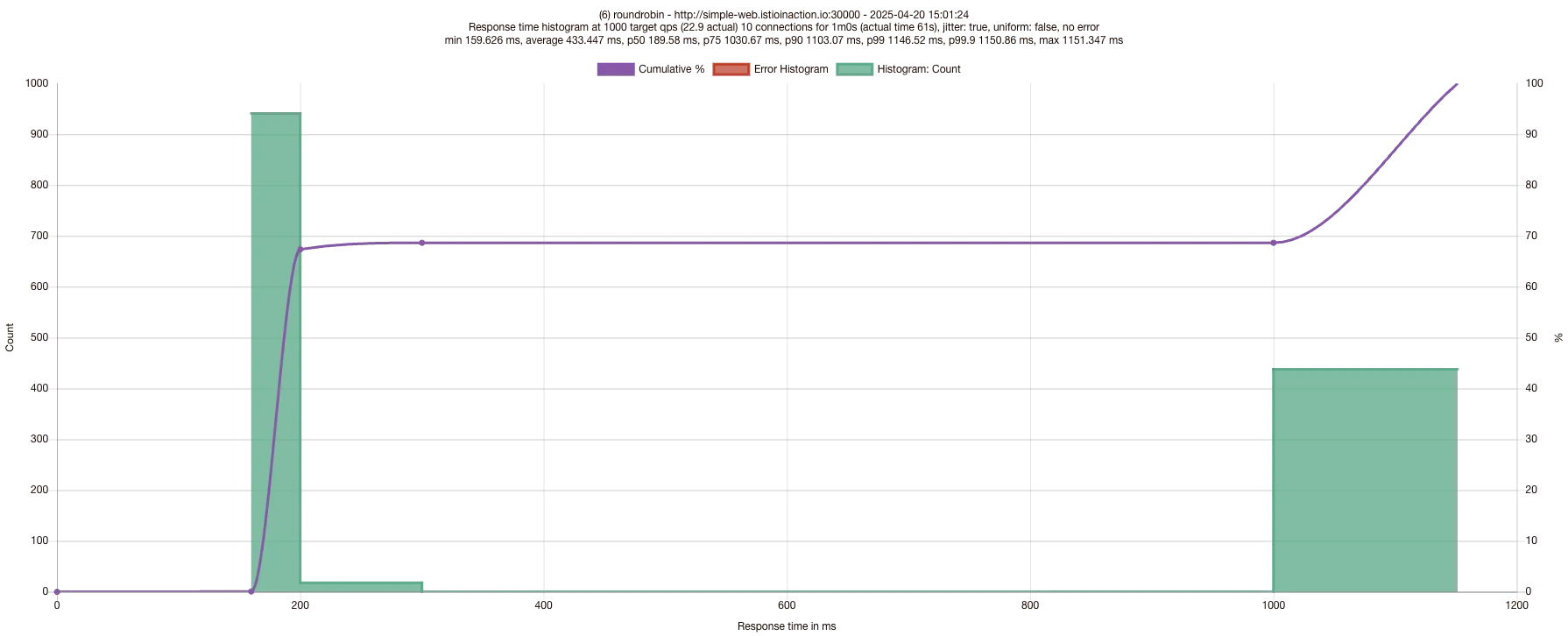

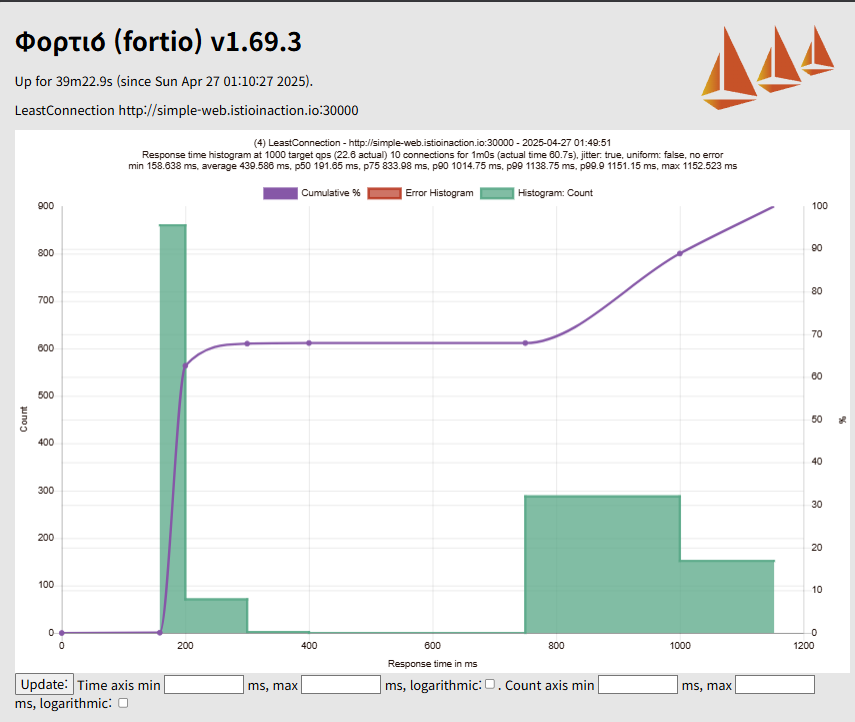

5.3 Traffic shifting (실습)

▶ Manual Canary release

- 이 절에서는 배포를 ‘카나리 canary’하거나 점진적으로 릴리스 incrementally release 하는 또 다른 방법을 살펴본다.

- 이전 절에서는 헤더 비교를 기반해 특정 사용자 그룹에 다크 런치 dark launch 를 수행하는 라우팅을 살펴봤다.

- 이 절에서는 가중치를 기반으로 특정 서비스의 여러 버전에 라이브 트래픽을 분배해본다.

- 예를 들어 catalog 서비스 v2를 내부 직원에게 다크 런치했고 이 버전을 모두에게 천천히 릴리스하고 싶다면, v2의 라우팅 가중치를 10%로 지정할 수 있다.

- catalog로 향하는 전체 트래픽의 10%는 v2로 가고 90%는 여전히 v1으로 갈 것이다.

- 이렇게 하면, 전체 트래픽 중 얼마만큼이 v2 코드에 부정적 영향을 받을지 제어함으로써 릴리스의 위험성을 더욱 줄일 수 있다.

- 다크 런치와 마찬가지로 서비스에 오류가 있는지 모니터링하고 관찰하려고 하며, 문제가 있으면 릴리스를 롤백하려고 한다.

- 이 경우, 롤백은 catalog v2 서비스로 가는 트래픽 가중치를 줄이는 것만큼(필요한 경우 다시 0%까지) 간단하다.

- 이스티오로 가중치 기반의 트래픽 전환을 수행하는 방법을 살펴보자.

# 이전 절부터 다음 서비스가 실행 중이다 : 파드에 labels 에 버전 정보 없을 경우 latest 설정되며, kiali 에 Workloads Details 에 'Missing Version' 표기됨

kubectl apply -f services/webapp/kubernetes/webapp.yaml -n istioinaction # 이미 배포 상태

kubectl apply -f services/catalog/kubernetes/catalog.yaml -n istioinaction # 이미 배포 상태

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction # 이미 배포 상태

kubectl get deploy,rs,pod -n istioinaction --show-labels

NAME READY STATUS RESTARTS AGE LABELS

catalog-6cf4b97d-q4xv5 2/2 Running 0 19m app=catalog,...,service.istio.io/canonical-revision=v1,version=v1

catalog-v2-6df885b555-df7g4 2/2 Running 0 19m app=catalog,...,service.istio.io/canonical-revision=v2,version=v2

webapp-7685bcb84-skzgg 2/2 Running 0 2m48s app=webapp,...,service.istio.io/canonical-revision=latest

# 반복 호출테스트 : 신규터미널

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# 모든 트래픽을 catalog service v1 으로 재설정하자

cat ch5/catalog-vs-v1-mesh.yaml

...

http:

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v1-mesh.yaml -n istioinaction

# 호출테스트

curl -s http://webapp.istioinaction.io:30000/api/catalog | jq- 트래픽 중 10%를 catalog v2 로 라우팅해보자

#

cat ch5/catalog-vs-v2-10-90-mesh.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways:

- mesh

http:

- route:

- destination:

host: catalog

subset: version-v1

weight: 90

- destination:

host: catalog

subset: version-v2

weight: 10

kubectl apply -f ch5/catalog-vs-v2-10-90-mesh.yaml -n istioinaction

#

kubectl get vs -n istioinaction catalog

NAME GATEWAYS HOSTS AGE

catalog ["mesh"] ["catalog"] 112s

# 호출 테스트 : v2 호출 비중 확인

for i in {1..10}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

# proxy-config(webapp) : mesh 이므로 메시 내 모든 사이드카에 VS 적용

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json

...

"route": {

"weightedClusters": {

"clusters": [

{

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"weight": 90

},

{

"name": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"weight": 10

}

],

"totalWeight": 100

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | grep catalog

# proxy-config(catalog) : mesh 이므로 메시 내 모든 사이드카에 VS 적용

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction --name 80 -o json

...- 트래픽을 50:50 반반으로 라우팅 해보자

#

cat ch5/catalog-vs-v2-50-50-mesh.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways:

- mesh

http:

- route:

- destination:

host: catalog

subset: version-v1

weight: 50

- destination:

host: catalog

subset: version-v2

weight: 50

kubectl apply -f ch5/catalog-vs-v2-50-50-mesh.yaml -n istioinaction

# 호출 테스트 : v2 호출 비중 확인

for i in {1..10}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

# proxy-config(webapp)

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json

...

"route": {

"weightedClusters": {

"clusters": [

{

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"weight": 50

},

{

"name": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"weight": 50

}

],

"totalWeight": 100

...- 각 서비스 버전의 트래픽 가중치를 1에서 100 사이로 바꿀 수 있지만, 가중치 총합은 반드시 100이어야 한다.

- 그렇지 않으면 예기치 못한 트래픽 라우팅이 발생할 수 있다.

- v1, v2 외 다른 버전이 있을 경우, DestinationRule 에서 subnet 으로 선언해야 한다는 것도 유념하자.

- 예시로는 ch5/catalog-dest-rule.yaml 을 참조하자.

[ 실행 결과 - 한 눈에 보기 ]

이 절에서는 여러 버전 사이에서 트래픽을 단계적으로 옮기는 작업을 수작업으로 수행했다.

이상적으로는 이 트래픽 전환을 어떤 도구나 CI/CD 파이프라인의 배포 파이프라인에서 자동화하고 싶다.

다음 절에서는 이런 카나리 릴리스 프로세스 자동화를 돕는 도구를 살펴본다.

☞ 소프트웨어 새 버전을 천천히 출시할 때는 구 버전과 신 버전을 모두 모니터링하고 관찰해 안정성, 성능, 정확성 등을 확인해야 한다.

문제를 발견하면 가중치를 변경해 구 버전으로 쉽게 롤백할 수 있다.

이 방식을 사용할 때는 여러 버전을 동시에 실행할 수 있도록 서비스를 구축해야 한다는 점도 명심하자.

서비스가 더 많은 상태를 갖고 있을 수록(심지어 외부 상태에 의존한다 하더라고) 이런 작업은 더 어려워질 수 있다.

이 주제에 대한 자세한 내용은 우리의 블로그 포스트를 참조하자.

https://blog.christianposta.com/microservices/traffic-shadowing-with-istio-reduce-the-risk-of-code-release/

https://blog.christianposta.com/microservices/advanced-traffic-shadowing-patterns-for-microservices-with-istio-service-mesh/

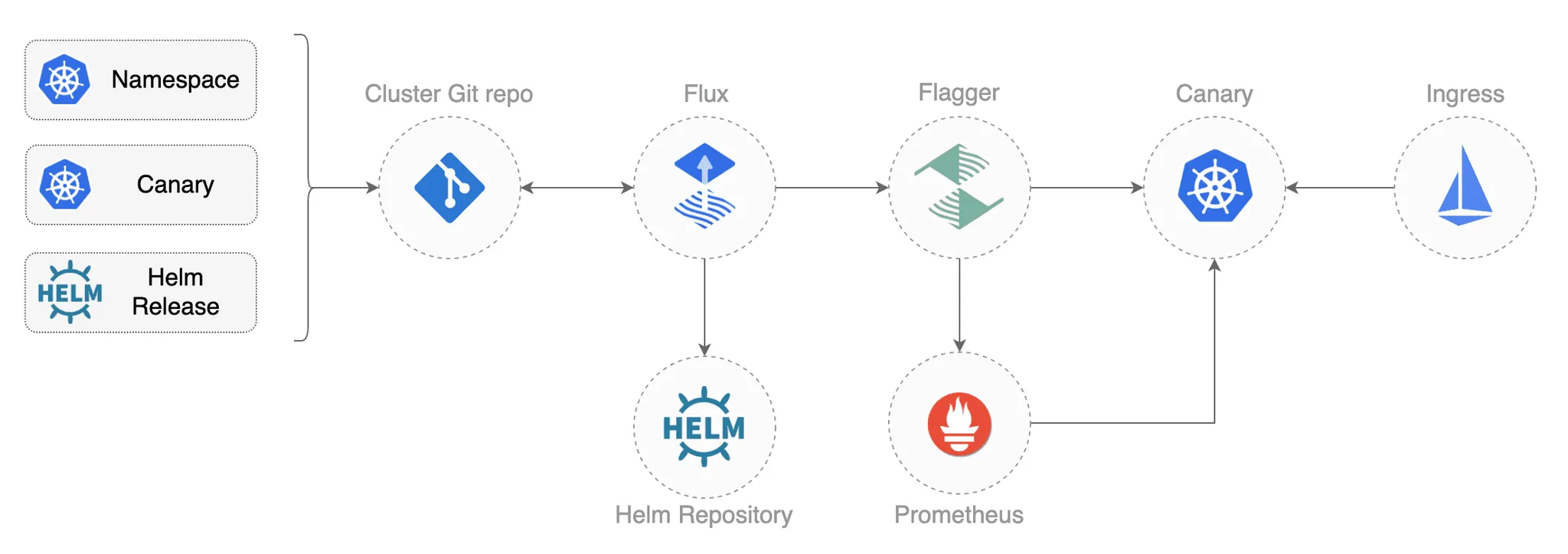

5.3.1 (Automating) Canary releasing with Flagger (Progressive Delivery Operator for Kubernetes) - Link

- 이전 절 에서 본 것처럼 이스티오는 트래픽 라우팅을 제어하는 강력한 기능을 운영자에게 제공하지만, 라우팅 변경과 새로운 설정 적용은 CLI에서 수동으로 해야 한다. 또한 여러 버전의 설정을 만들었기 때문에 작업도 더 많았고 설정이 잘못될 가능성도 있었다. 수백 개의 릴리스가 동시에 진행될 수도 있으므로, 카나리를 수행할 때 사람에 의한 이와 같은 수작업을 피하길 원하며 실수 가능성도 줄이고 싶다.

- Flagger 같은 것을 사용하면 서비스 릴리스를 자동화할 수 있다. Flagger는 스테판 프로단 Stefan Prodan 이 만든 카나리 자동화 도구로, 릴리스를 어떻게 수행할지, 언제 더 많은 사용자에게 릴리스를 개방할지, 릴리스가 문제를 일으킬 경우 언제 롤백할지 등에 관련된 파라미터를 지정할 수 있다. Flagger는 릴리스를 수행하는 데 필요한 작절한 설정을 모두 만든다.

- 이스티오와 Flagger를 함께 사용하는 방법을 살펴보자.

- 이전 절에서는 catalog-v2 와 트래픽 라우팅을 명시적으로 제어하는 VirtualService를 배포했다.

Step1. 이 둘을 제거하고 Flagger가 라우팅과 배포 변경을 처리하게 하자.

# catalog-v2 와 트래픽 라우팅을 명시적으로 제어하는 VirtualService를 제거

kubectl delete virtualservice catalog -n istioinaction

kubectl delete deploy catalog-v2 -n istioinaction

kubectl delete service catalog -n istioinaction

kubectl delete destinationrule catalog -n istioinaction

# 남은 리소스 확인

kubectl get deploy,svc,ep -n istioinaction

NAME READY UP-TO-DATE AVAILABLE AGE

deployment.apps/catalog 1/1 1 1 77m

deployment.apps/webapp 1/1 1 1 78m

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/webapp ClusterIP 10.200.1.73 <none> 80/TCP 78m

NAME ENDPOINTS AGE

endpoints/webapp 10.10.0.19:8080 78m

kubectl get gw,vs -n istioinaction

NAME AGE

gateway.networking.istio.io/coolstore-gateway 73m

NAME GATEWAYS HOSTS AGE

virtualservice.networking.istio.io/webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 73m

- Flagger는 서비스 상태를 판단할 때 메트릭에 의존하며, 카나리 릴리스를 사용할 때 특히 그렇다.

- Flagger가 성공 메트릭을 사용하려면 프로메테우스를 설치해 이스티오 데이터 플레인을 수집해야 한다.

- 이 책의 예제를 따라오고 있다면, 프로메테우스 샘플이 이미 설치돼 있을 것이다.

Step2. 다음으로는 Flagger를 설치하려고 한다.

helm 사용. https://docs.flagger.app/install/flagger-install-on-kubernetes

# CRD 설치

kubectl apply -f https://raw.githubusercontent.com/fluxcd/flagger/main/artifacts/flagger/crd.yaml

kubectl get crd | grep flagger

alertproviders.flagger.app 2025-04-19T03:11:50Z

canaries.flagger.app 2025-04-19T03:11:50Z

metrictemplates.flagger.app 2025-04-19T03:11:50Z

# Helm 설치

helm repo add flagger https://flagger.app

helm install flagger flagger/flagger \

--namespace=istio-system \

--set crd.create=false \

--set meshProvider=istio \

--set metricServer=http://prometheus:9090

# 디플로이먼트 flagger 에 의해 배포된 파드 확인

kubectl get pod -n istio-system -l app.kubernetes.io/name=flagger

NAME READY STATUS RESTARTS AGE

flagger-6d4ffc5576-q78ls 1/1 Running 0 2m54s

# 시크릿

kubectl get secret -n istio-system | grep flagger-token

flagger-token-v2f5z kubernetes.io/service-account-token 3 4m11s

# 시크릿 확인 : ca.crt 는 k8s 루프 인증서

kubectl view-secret -n istio-system flagger-token-v2f5z --all

ca.crt='-----BEGIN CERTIFICATE-----

MIIC/jCCAeagAwIBAgIBADANBgkqhkiG9w0BAQsFADAVMRMwEQYDVQQDEwprdWJl

cm5ldGVzMB4XDTI1MDQxOTAxNDEyMVoXDTM1MDQxNzAxNDEyMVowFTETMBEGA1UE

AxMKa3ViZXJuZXRlczCCASIwDQYJKoZIhvcNAQEBBQADggEPADCCAQoCggEBAMzN

onEbSSXBHfHhJICwREU4EX4D0K2Bwg7SXNwZNl3QwwPOpjFoaRbr6Hdog88jmo8A

Mo/RDKDj+Lvr0FE3hBvm5igLndWgnjYqpIHfDq31AYvWCoJvbBQ/omDIal4u1HHI

8XNqEpxl3JhsV9M9pMEx2+Gvlp1og8qjbB3B5amutriNQom6VOG0HBzJQuvNG8op

2GhWD4IOQf3vfKltGE9Y/KzbBLajtPueMkHZr/kH4Qy/Xu9kSGc8lhdsxrRSqoTX

ytyr2rOe83vliKhGKYtkiWESIm35BcVF1rp+jl0nLGs8IMhmR5Ll9A9pZ5xsqFzN

ndg7DjpdcKKwCxzw9BsCAwEAAaNZMFcwDgYDVR0PAQH/BAQDAgKkMA8GA1UdEwEB

/wQFMAMBAf8wHQYDVR0OBBYEFPm+n2+NblRv8ZWaoVW4fMvmFzuNMBUGA1UdEQQO

MAyCCmt1YmVybmV0ZXMwDQYJKoZIhvcNAQELBQADggEBAFkDbnnWS+9u9AKnlih0

Cltedk01oId5I31SWzvfI1owgudBH6pGxs3dGeij5iNDlV2StDzG5mqUIW6Y5iXR

hVMUUl/GvscaoSqFb5cIEgfmzdDSsNm1eBON8HpoN4VuEyuRZn1O39JAYIzVQcwD

LgO/dTCZwqM6hs6LC2Qx/PlxlQLt3agT3sZWXkztbOjLpLCuqVrz0NIRzFS3M2hA

b1+ACPllYGIRiEpSNxzbybgjui4W8bt8W2AjTPuqXIB/TuEcQrgAzrVcQsVf2XID

nC+WEpmUURKxQ51dLpLLQgFfojz+LXrdrlGJ4hpcfj0aN5j221+rjHTnI6PrsQdT

qME=

-----END CERTIFICATE-----

'

namespace='istio-system'

token='eyJhbGciOiJSUzI1NiIsImtpZCI6InFIUnV5blBfSUVDaDQ0MUxyOXR2MFRqV1g5ekVjaU1wdWZvSDFXZXl6Z3cifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJpc3Rpby1zeXN0ZW0iLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlY3JldC5uYW1lIjoiZmxhZ2dlci10b2tlbi12MmY1eiIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VydmljZS1hY2NvdW50Lm5hbWUiOiJmbGFnZ2VyIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQudWlkIjoiNWIxZWM4MjUtODU4My00OGViLWI4MGMtNmYyNzEzZTBlMzA3Iiwic3ViIjoic3lzdGVtOnNlcnZpY2VhY2NvdW50OmlzdGlvLXN5c3RlbTpmbGFnZ2VyIn0.Eb14h5EKU9FfYZa3XkydrFFYUSk4gPYUM0j76Cbsb4XTtAL0U54-RfMiNcX5rfyK6WFOUhU5W6yuAChRhsl7TEzZCpgj3aVRNNe5TRsy-mYpG89FfBSpU0H6wmZyJnvHDcweo1eh-BLIThH6-_1GuUeJDc18WsapllkcHNIXiR_7gudgY7tfn29KoKxlv72K_HPYIerIsTGZe9tHr7K__lvl0Yz779yKNXKUlSerqho0-z2cPsmhFRR1KvPwrhi6UQck70s_snMlaecVJvkrYXCnEvsMkUwpaa6JmDmamKC3NNm9zWJYKtEt0fHHomZoJQFHHQCiYDTVkjYi8ErE2A'

# token 을 jtw.io 에서 Decoded 확인

{

"iss": "kubernetes/serviceaccount",

"kubernetes.io/serviceaccount/namespace": "istio-system",

"kubernetes.io/serviceaccount/secret.name": "flagger-token-v2f5z",

"kubernetes.io/serviceaccount/service-account.name": "flagger",

"kubernetes.io/serviceaccount/service-account.uid": "5b1ec825-8583-48eb-b80c-6f2713e0e307",

"sub": "system:serviceaccount:istio-system:flagger"

}

Step3. 아래 코드 처럼 Flagger Canara 리소스를 사용해 카나리 릴리스의 파라미터를 지정하자.

Flagger가 적절한 리로스를 만들어 이 릴리스를 주관하게 할 것이다. - Docs

# cat ch5/flagger/catalog-release.yaml

apiVersion: flagger.app/v1beta1

kind: Canary

metadata:

name: catalog-release

namespace: istioinaction

spec:

targetRef: #1 카나리 대상 디플로이먼트 https://docs.flagger.app/usage/how-it-works#canary-target

apiVersion: apps/v1

kind: Deployment

name: catalog

progressDeadlineSeconds: 60

# Service / VirtualService Config

service: #2 서비스용 설정 https://docs.flagger.app/usage/how-it-works#canary-service

name: catalog

port: 80

targetPort: 3000

gateways:

- mesh

hosts:

- catalog

analysis: #3 카니리 진행 파라미터 https://docs.flagger.app/usage/how-it-works#canary-analysis

interval: 45s

threshold: 5

maxWeight: 50

stepWeight: 10

match:

- sourceLabels:

app: webapp

metrics: # https://docs.flagger.app/usage/metrics , https://docs.flagger.app/faq#metrics

- name: request-success-rate # built-in metric 요청 성공률

thresholdRange:

min: 99

interval: 1m

- name: request-duration # built-in metric 요청 시간

thresholdRange:

max: 500

interval: 30s

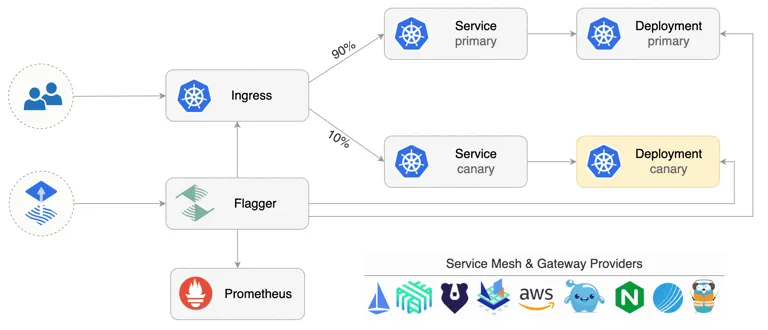

- 이 Canary 리소스에서는 어떤 쿠버네티스 Deployment가 카나리 대상인지, 어떤 쿠버네티스 Service와 이스티오 VirtualService가 자동으로 만들어져야 하는지, 카나리를 어떻게 진행해야 하는지 등을 지정한다.

- Canary 리소스의 마지막 부분은 카나리를 얼마나 빨리 진행할지, 생존을 판단하기 위해 지켜볼 메트릭은 무엇인지, 성공을 판단할 임계값은 얼마인지를 기술하고 있다.

- 45초마다 카나리의 각 단계를 평가하고, 단계별로 트래픽을 10%씩 늘린다. 트래픽이 **50%에 도달하면 100%**로 바꾼다.

- 성공률 메트릭의 경우 1분 동안의 성공률이 99% 이상이어야 한다. 또한 P99(상위 99%) 요청 시간은 500ms까지 허용한다.

- 이 메트릭들이 연속으로 5회를 초과해 지정한 범위와 다르면, 롤백한다.

Step4. 위 설정을 적용하고 catalog 서비스를 자동으로 v2로 카나리하는 절차를 시작해보자

# 반복 호출테스트 : 신규터미널

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# flagger (operator) 가 catalog를 위한 canary 배포환경을 구성

kubectl apply -f ch5/flagger/catalog-release.yaml -n istioinaction

# flagger 로그 확인 : Service, Deployment, VirtualService 등을 설치하는 것을 확인할 수 있습니다.

kubectl logs -f deploy/flagger -n istio-system

...

# 확인

kubectl get canary -n istioinaction -w

NAME STATUS WEIGHT LASTTRANSITIONTIME

catalog-release Initializing 0 2025-04-19T05:10:00Z

catalog-release Initialized 0 2025-04-19T05:15:54Z

kubectl get canary -n istioinaction -owide

NAME STATUS WEIGHT SUSPENDED FAILEDCHECKS INTERVAL MIRROR STEPWEIGHT STEPWEIGHTS MAXWEIGHT LASTTRANSITIONTIME

catalog-release Initialized 0 0 45s 10 50 2025-04-19T05:15:54Z

# flagger Initialized 동작 확인

## catalog-primary deployment/service 가 생성되어 있음, 기존 catalog deploy/service 는 파드가 0으로 됨

kubectl get deploy,svc,ep -n istioinaction -o wide

NAME READY UP-TO-DATE AVAILABLE AGE CONTAINERS IMAGES SELECTOR

deployment.apps/catalog 0/0 0 0 3h34m catalog istioinaction/catalog:latest app=catalog,version=v1

deployment.apps/catalog-primary 1/1 1 1 6m41s catalog istioinaction/catalog:latest app=catalog-primary

deployment.apps/webapp 1/1 1 1 3h36m webapp istioinaction/webapp:latest app=webapp

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

service/catalog ClusterIP 10.200.1.168 <none> 80/TCP 5m56s app=catalog-primary

service/catalog-canary ClusterIP 10.200.1.242 <none> 80/TCP 6m41s app=catalog

service/catalog-primary ClusterIP 10.200.1.119 <none> 80/TCP 6m41s app=catalog-primary

service/webapp ClusterIP 10.200.1.73 <none> 80/TCP 3h36m app=webapp

NAME ENDPOINTS AGE

endpoints/catalog 10.10.0.23:3000 5m56s

endpoints/catalog-canary <none> 6m41s

endpoints/catalog-primary 10.10.0.23:3000 6m41s

endpoints/webapp 10.10.0.19:8080 3h36m

## VS catalog 생성되었음

kubectl get gw,vs -n istioinaction

NAME AGE

gateway.networking.istio.io/coolstore-gateway 137m

NAME GATEWAYS HOSTS AGE

virtualservice.networking.istio.io/catalog ["mesh"] ["catalog"] 8m17s

virtualservice.networking.istio.io/webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 137m

## VS catalog 확인

kubectl get vs -n istioinaction catalog -o yaml | kubectl neat

apiVersion: networking.istio.io/v1beta1

kind: VirtualService

metadata:

annotations:

helm.toolkit.fluxcd.io/driftDetection: disabled

kustomize.toolkit.fluxcd.io/reconcile: disabled

name: catalog

namespace: istioinaction

spec:

gateways:

- mesh

hosts:

- catalog

http:

- match:

- sourceLabels:

app: webapp

route:

- destination:

host: catalog-primary

weight: 100

- destination:

host: catalog-canary

weight: 0

- route:

- destination:

host: catalog-primary

weight: 100

# destinationrule 확인

kubectl get destinationrule -n istioinaction

NAME HOST AGE

catalog-canary catalog-canary 15m

catalog-primary catalog-primary 15m

kubectl get destinationrule -n istioinaction catalog-primary -o yaml | kubectl neat

apiVersion: networking.istio.io/v1beta1

kind: DestinationRule

metadata:

name: catalog-primary

namespace: istioinaction

spec:

host: catalog-primary

kubectl get destinationrule -n istioinaction catalog-canary -o yaml | kubectl neat

apiVersion: networking.istio.io/v1beta1

kind: DestinationRule

metadata:

name: catalog-canary

namespace: istioinaction

spec:

host: catalog-canary

#

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80

NAME DOMAINS MATCH VIRTUAL SERVICE

80 catalog-canary, catalog-canary.istioinaction + 1 more... /*

80 catalog-primary, catalog-primary.istioinaction + 1 more... /*

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction | egrep 'RULE|catalog'

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog-canary.istioinaction.svc.cluster.local 80 - outbound EDS catalog-canary.istioinaction

catalog-primary.istioinaction.svc.cluster.local 80 - outbound EDS catalog-primary.istioinaction

catalog.istioinaction.svc.cluster.local 80 - outbound EDS

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog.istioinaction.svc.cluster.local -o json

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog-primary.istioinaction.svc.cluster.local -o json

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog-canary.istioinaction.svc.cluster.local -o json

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | grep catalog

10.10.0.23:3000 HEALTHY OK outbound|80||catalog-primary.istioinaction.svc.cluster.local

10.10.0.23:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

# 해당 EDS에 메트릭 통계 값 0.

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local' -o json

...

# 현재 EDS primary 에 메트릭 통계 값 출력 중. 해당 EDS 호출.

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction --cluster 'outbound|80||catalog-primary.istioinaction.svc.cluster.local' -o json

...

위 VS catalog 등 설정을 보면, catalog 서비스로 향하는 트래픽이 catalog-primary 서비스로는100%, catalog-canary 로는 0% 라우팅될 것임을 알 수 있다.

[ 실행 결과 - 한 눈에 보기 ]

- 지금까지는 기본 설정만 준비 했을 뿐, 실제 카나리는 수행하지 않았다.

- Flagger는 원본 디폴로이먼트 대상(여기서는 catalog 디플로이먼트

?catalog-primary가 아닌가?)의 변경 사항을 지켜보고, 카나리 디폴로이먼트(catalog-canary) 및 서비스(catalog-canary)를 생성하고, VirtualService 의 가중치를 조정한다.

이제 catalog v2 를 도입하고 Flagger가 어떻게 릴리스에서 이를 자동화하는지, 어떻게 메트릭에 기반해 의사결정을 내리는지 살펴보자.

- 또한 Flagger가 정상 메트릭 기준선을 가져올 수 있도록 이스티오를 통해 서비스에 대한 부하를 만들어보자.

- 카나리는 Carary 오브젝트에 설정한 대로 45초마다 진행될 것이다.

- 트래픽의 50%가 카나리로 이동할 때까지는 단계별로 10%씩 증가한다.

- flagger가 메트릭에 문제가 없고 기준과 차이가 없다고 판단되면, 모든 트래픽이 카나리로 이동해 카나리가 기본 서비스로 승격 될 때까지 카나리가 진행된다.

- 만약 문제가 발생하면 flagger는 자동으로 카나리 릴리스를 롤백할 것이다.

# 반복 호출테스트 : 신규터미널1 - 부하 만들기

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# flagger 로그 확인 : 신규터미널2

kubectl logs -f deploy/flagger -n istio-system

{"level":"info","ts":"2025-04-19T05:15:54.453Z","caller":"controller/events.go:33","msg":"Initialization done! catalog-release.istioinaction","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:09:09.442Z","caller":"router/istio.go:414","msg":"Canary catalog-release.istioinaction uses HTTP service"}

{"level":"info","ts":"2025-04-19T06:09:09.444Z","caller":"controller/events.go:33","msg":"New revision detected! Scaling up catalog.istioinaction","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:09:54.441Z","caller":"router/istio.go:414","msg":"Canary catalog-release.istioinaction uses HTTP service"}

{"level":"info","ts":"2025-04-19T06:09:54.446Z","caller":"controller/events.go:33","msg":"Starting canary analysis for catalog.istioinaction","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:09:54.461Z","caller":"controller/events.go:33","msg":"Advance catalog-release.istioinaction canary weight 10","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:10:39.443Z","caller":"router/istio.go:414","msg":"Canary catalog-release.istioinaction uses HTTP service"}

{"level":"info","ts":"2025-04-19T06:10:39.469Z","caller":"controller/events.go:33","msg":"Advance catalog-release.istioinaction canary weight 20","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:11:24.437Z","caller":"router/istio.go:414","msg":"Canary catalog-release.istioinaction uses HTTP service"}

{"level":"info","ts":"2025-04-19T06:11:24.461Z","caller":"controller/events.go:33","msg":"Advance catalog-release.istioinaction canary weight 30","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:12:09.445Z","caller":"router/istio.go:414","msg":"Canary catalog-release.istioinaction uses HTTP service"}

{"level":"info","ts":"2025-04-19T06:12:09.472Z","caller":"controller/events.go:33","msg":"Advance catalog-release.istioinaction canary weight 40","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:12:54.429Z","caller":"router/istio.go:414","msg":"Canary catalog-release.istioinaction uses HTTP service"}

{"level":"info","ts":"2025-04-19T06:12:54.445Z","caller":"controller/events.go:33","msg":"Advance catalog-release.istioinaction canary weight 50","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:13:39.444Z","caller":"router/istio.go:414","msg":"Canary catalog-release.istioinaction uses HTTP service"}

{"level":"info","ts":"2025-04-19T06:13:39.453Z","caller":"controller/events.go:33","msg":"Copying catalog.istioinaction template spec to catalog-primary.istioinaction","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:14:24.438Z","caller":"router/istio.go:414","msg":"Canary catalog-release.istioinaction uses HTTP service"}

{"level":"info","ts":"2025-04-19T06:14:24.440Z","caller":"controller/events.go:33","msg":"Routing all traffic to primary","canary":"catalog-release.istioinaction"}

{"level":"info","ts":"2025-04-19T06:15:09.436Z","caller":"router/istio.go:414","msg":"Canary catalog-release.istioinaction uses HTTP service"}

{"level":"info","ts":"2025-04-19T06:15:09.642Z","caller":"controller/events.go:33","msg":"Promotion completed! Scaling down catalog.istioinaction","canary":"catalog-release.istioinaction"}

# flagger 상태 확인 : 신규터미널3

## 카나리는 Carary 오브젝트에 설정한 대로 45초마다 진행될 것이다.

## 트래픽의 50%가 카나리로 이동할 때까지는 단계별로 10%씩 증가한다.

## flagger가 메트릭에 문제가 없고 기준과 차이가 없다고 판단되면, 모든 트래픽이 카나리로 이동해 카나리가 기본 서비스로 승격 될 때까지 카나리가 진행된다.

## 만약 문제가 발생하면 flagger는 자동으로 카나리 릴리스를 롤백할 것이다.

kubectl get canary -n istioinaction -w

NAME STATUS WEIGHT LASTTRANSITIONTIME

catalog-release Initialized 0 2025-04-19T05:15:54Z

catalog-release Progressing 0 2025-04-19T06:09:09Z

catalog-release Progressing 10 2025-04-19T06:09:54Z # 45초 간격

catalog-release Progressing 20 2025-04-19T06:10:39Z

catalog-release Progressing 30 2025-04-19T06:11:24Z

catalog-release Progressing 40 2025-04-19T06:12:09Z

catalog-release Progressing 50 2025-04-19T06:12:54Z

catalog-release Promoting 0 2025-04-19T06:13:39Z

catalog-release Finalising 0 2025-04-19T06:14:24Z

catalog-release Succeeded 0 2025-04-19T06:15:09Z

# imageUrl 출력 (v2)을 포함하는 catalog deployment v2 배포

cat ch5/flagger/catalog-deployment-v2.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: catalog

version: v1

name: catalog

spec:

replicas: 1

selector:

matchLabels:

app: catalog

version: v1

template:

metadata:

labels:

app: catalog

version: v1

spec:

containers:

- env:

- name: KUBERNETES_NAMESPACE

valueFrom:

fieldRef:

fieldPath: metadata.namespace

- name: SHOW_IMAGE

value: "true"

image: istioinaction/catalog:latest

imagePullPolicy: IfNotPresent

name: catalog

ports:

- containerPort: 3000

name: http

protocol: TCP

securityContext:

privileged: false

kubectl apply -f ch5/flagger/catalog-deployment-v2.yaml -n istioinaction

kubectl get vs -n istioinaction catalog -o yaml -w # catalog vs 에 가중치 변경 모니터링

---

route:

- destination:

host: catalog-primary

weight: 90

- destination:

host: catalog-canary

weight: 10

- route:

- destination:

host: catalog-primary

weight: 90

---

route:

- destination:

host: catalog-primary

weight: 80

- destination:

host: catalog-canary

weight: 20

- route:

- destination:

host: catalog-primary

weight: 80

---

route:

- destination:

host: catalog-primary

weight: 70

- destination:

host: catalog-canary

weight: 30

- route:

- destination:

host: catalog-primary

weight: 70

---

route:

- destination:

host: catalog-primary

weight: 60

- destination:

host: catalog-canary

weight: 40

- route:

- destination:

host: catalog-primary

weight: 60

---

route:

- destination:

host: catalog-primary

weight: 50

- destination:

host: catalog-canary

weight: 50

- route:

- destination:

host: catalog-primary

weight: 50

---

route:

- destination:

host: catalog-primary

weight: 100

- destination:

host: catalog-canary

weight: 0

- route:

- destination:

host: catalog-primary

weight: 100

---

# canary CRD 이벤트 확인

kubectl describe canary -n istioinaction catalog-release | grep Events: -A20

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal Synced 10m flagger New revision detected! Scaling up catalog.istioinaction

Normal Synced 9m54s flagger Starting canary analysis for catalog.istioinaction

Normal Synced 9m54s flagger Advance catalog-release.istioinaction canary weight 10

Normal Synced 9m9s flagger Advance catalog-release.istioinaction canary weight 20

Normal Synced 8m24s flagger Advance catalog-release.istioinaction canary weight 30

Normal Synced 7m39s flagger Advance catalog-release.istioinaction canary weight 40

Normal Synced 6m54s flagger Advance catalog-release.istioinaction canary weight 50

Normal Synced 6m9s flagger Copying catalog.istioinaction template spec to catalog-primary.istioinaction

Normal Synced 5m24s flagger Routing all traffic to primary

Normal Synced 4m39s flagger (combined from similar events): Promotion completed! Scaling down catalog.istioinaction

# 최종 v2 접속 확인

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

100

☞ 카나리 과정 중 kiali 확인

☞ 프로메테우스에서 확인 : flagger_canary_weight - Link

☞ flagger_canary_metric_analysis{metric="request-duration"}

☞ flagger_canary_metric_analysis{metric="request-success-rate"}

- Flagger를 사용해 이스티오의 API로 카나리 릴리스를 자동 제어함으로써, 리소스를 직접 설정하는 등 설정 오류를 일으킬 수 있는 수작업의 필요성을 없앴다.

- 또한 Flagger는 다크 런치 테스트, 트래픽 미러링(다음 절에서 설명한다) 등도 할 수 있다.

- 관련 내용은 웹 사이트를 참고하자. https://docs.flagger.app/usage/deployment-strategies